Malgré la très grande fiabilité des grands réseaux de transport électrique, la principale difficulté à leur opération est la gestion de la stabilité. Cette stabilité des réseaux de transport a toujours été un enjeu pour l’exploitation de grands réseaux électriques et des réseaux voisins. Les problèmes de stabilité sont au cœur de plusieurs incidents au fil du temps sur de nombreux réseaux électriques à travers le monde.

Pour relever le défi des problèmes de stabilités, de nombreuses méthodes ont été étudiées dans le passé pour permettre de stabiliser les réseaux à l’aide de diverses technologies. Plusieurs relais de protection de synchronisme ont déjà été développés. Ceux-ci mesurent les caractéristiques concentriques et le taux de changement de l’impédance, pour ne citer qu’elles (Kundur, 1994).

Avec l’ère numérique, de nouvelles approches sont maintenant envisageables pour résoudre des problèmes de stabilité (Kirby et al., 2011) ; (Perron et al., 2018). Récemment, l’apparition de nouvelles méthodes permettent d’entraîner les ordinateurs à reconnaître certains phénomènes. Cette approche prend un nouvel envol grâce aux puissances de calcul des ordinateurs actuels (Zhang, Wang, Liu & Bao, 2018). L’apprentissage machine est une discipline de l’intelligence artificielle qui vise à faire apprendre les ordinateurs. Cet ouvrage vise à explorer la possibilité d’utiliser l’apprentissage machine pour des applications en problèmes de stabilité de réseaux électriques.

Les méthodes d’apprentissage machine existaient depuis longtemps. Leur mise en application n’a toutefois commencé que depuis quelques années grâce à la plus grande capacité des ordinateurs (Chothani, Bhalja & Parikh, 2014).

Parmi de nombreuses recherches dans le domaine de l’intelligence artificielle, on peut citer que dans les années 1940, McCulloch et Pins furent les premiers à publier des travaux sur leur modélisation de réseaux de neurones, puis Farley et Clark, en 1954, furent les premiers à utiliser des ordinateurs pour simuler un réseau de neurones. En 1958, Rosenblatt créa le modèle du perceptron. Puis en 1965, le premier réseau de neurones artificiel fonctionnel avec plusieurs couches de neurones fut publié par Ivakhnenko et Lapa. Toutefois, les technologies ont changé moins rapidement dans le domaine électrique. Le réseau électrique possède les mêmes composantes qu’avant. La seule différence est qu’il y a de plus en plus de consommateurs d’énergie pour les mêmes infrastructures. De nouvelles infrastructures électriques sont difficiles à développer pour des raisons d’acceptabilité sociale.

Cette situation amène l’exposition des réseaux contemporains à plus de problèmes d’instabilité. Lorsqu’il y a une perturbation du réseau lors d’un défaut de ligne ou lors d’une diminution de la charge ou encore l’ouverture de plusieurs lignes, il y a une accélération ou un ralentissement des machines électriques. Si ces perturbations sont trop brusques, il y a un risque que les machines décrochent et entraînent des pertes de service sur le réseau (Kundur, 1994). Ce fut le cas de la ville de New York en 2003 qui a perdu le service électrique pour des millions de consommateurs d’énergie.

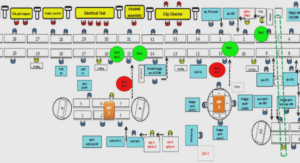

L’idée de ce rapport est de développer une façon de prévoir les instabilités pour des applications sur un relais de perte de synchronisme qui a pour rôle d’isoler certaines sections d’un réseau lorsque la fréquence accélère ou décélère de façon importante, ce qui peut entraîner une perte de la synchronisation de la fréquence d’un réseau. Ce relais peut prendre des décisions comme déconnecter des machines ou des charges pour éviter ces écarts de fréquences trop élevés.

Principe de fonctionnement du relais

Le principe de classement qui sera employé utilisera la méthode de centre d’inertie (Burhan, 2012) ; (Sauer & Pai, 1998) ; (Hashim, Abidin, Yap, Musirin & Zulkepali, 2010). Les simulations effectuées sont au préalable manuellement classées stables et instables. Pour les simulations stables, la variable à prédire de chaque série et pour chaque générateur est définie à 0 alors que pour les cas instables, celle-ci est définie à 1. Le modèle de prédiction est ensuite entraîné par apprentissage supervisé à classifier les cas série après série. Appliquée en temps réel, après un court-circuit, chaque nouvelle donnée échantillonnée est ajoutée à la série et classée par le modèle de prédiction dans un état stable ou instable jusqu’à ce qu’une décision d’ouverture des disjoncteurs soit prise.

Réseau de neurones artificiels classique

Les réseaux de neurones artificiels classique (Artificiel Neural Network ANN) sont des systèmes vaguement inspirés des réseaux de neurones biologiques qui constituent le cerveau animal. Ces systèmes « apprenant » exécutent des tâches en considérant des exemples sans être programmés par des règles spécifiques. Par exemple, dans la reconnaissance d’images, ils peuvent apprendre à reconnaître un chien en analysant plusieurs exemples d’images contenant un chien qui ont été préalablement identifiées comme des images contenant un chien ou non. Ils peuvent faire ce genre de tâche sans connaissance à priori de ce qu’est un chien.

Principe général

Un réseau de neurones artificiels est composé de 3 éléments :

• le premier élément du réseau contient des neurones d’entrée du réseau de neurones en rouge dans l’image suivante. Ceux-ci sont joints aux neurones de la couche du milieu en bleu nommée couche cachée. Ces neurones servent d’entrée aux informations de l’extérieur vers le réseau. Ces neurones ne font aucun traitement, ils ne font que diffuser l’information brute de l’extérieur au réseau;

• le deuxième élément du réseau contient les neurones de la couche cachée en bleu dans l’image suivante. Ces neurones font le travail de traiter l’information des différents neurones d’entrée. Les neurones de la couche cachée sont reliés aux neurones de la couche de sortie;

• le troisième élément du réseau contient les neurones de la couche de sortie en vert dans l’image suivante. Ces neurones sont rattachés aux différents neurones de la couche cachée. Ces neurones font un traitement de l’information des neurones de la couche précédente pour produire l’information à la sortie du réseau.

INTRODUCTION |