Concepts de base en fiabilité et maintenance

Le but des activités de maintenance est d’assurer et de maintenir la performance d’un produit ou système. La maintenance se distingue de la production de biens dans le fait que la qualité ou la conformité d’un bien est fonction de la performance de celui-ci, selon des spécifications préétablies (tolérance, % défectueux, etc.). En production, le bien est conforme s’il respecte les standards et qu’il est en mesure d’effectuer l’action pour laquelle il a été conçu. Lorsqu’il est question de maintenance, la fiabilité est la capacité de ce bien à effectuer ses actions d’usage selon un intervalle de temps donné. Ainsi, la fiabilité peut être exprimée comme étant la probabilité qu’un bien soit en mesure de performer ses fonctions d’usages dans un intervalle de temps et dans des conditions préétablies (Lazzaroni et al., 2011). La fiabilité s’exprime sous la forme de modèle mathématique, ou sous forme d’estimateur statistique, comme le temps moyen avant la défaillance (MTTF) ou le temps moyen de bon fonctionnement (MTBF). Le but de l’étude de fiabilité est de prévenir et/ou de réduire la fréquence des défaillances en appliquant l’ ingénierie et les diverses techniques statistiques. C’est aussi d’identifier et d’éliminer, si possible, les mécanismes qui causent des défaillances, en dépit des efforts de prévention. Enfin, les fiabilistes doivent estimer la fiabilité de nouveaux composants (design) et analyser les données (O’Connor & Kleyner, 2011), notamment à l’aide de tests accélérés de durée de vie. En ce qui a trait à la maintenance, il s’agit des actions visant la mise en oeuvre des objectifs de production d’une entreprise. Elle inclut l’ensemble des activités de planification, de gestion et d’exécution de l’entretien des équipements, dans le but d’atteindre ces objectifs d’entreprise. En fiabilité, on distingue deux types de systèmes, les systèmes réparables et les systèmes non réparables.

Système réparable

Dans le cas d’un système réparable, il se distingue par le fait que lorsqu ‘un événement de défaillance survient, le système peut être ramené dans un état de fonctionnement. La fiabilité est alors exprimée comme le taux d’occurrence des événements de défaillances (ROCOF ou taux de réparation), ou comme le temps moyen de bon fonctionnement (MTBF). Le taux de défaillance peut varier avec le temps, ou demeurer constant. Un taux constant, comme pour les systèmes non réparables, est associé à des défaillances aléatoires causées par des facteurs externes. Dans d’autres cas, le taux de défaillance peut être décroissant, si une réparation vient améliorer l’état de santé d’un équipement. Finalement, l’usure globale du système causera progressivement un taux de défaillance en croissance. Le choix d’un modèle mathématique dépend grandement du type de décision à prendre, en plus du type de système à l’étude. Dans la représentation des systèmes réparables, il y a trois cas de figure auxquels les modèles de probabilités permettent de répondre. La première situation est lorsqu’il faut remplacer un élément non réparable d’un système.

Ce type de problème, nommé modèle de remplacement, permet entre autres de déterminer le nombre de pièces de remplacement en inventaire, afin de minimiser les coûts de stockage et de calculer la probabilité de pénurie de stock. Cela permet aussi de choisir différente politique de remplacement : La Figure 2.6, tiré de Leemis (2009), permet d’identifier trois politiques de remplacement. Les défaillances sont illustrées par un « x » et les remplacements par un « 0 ». La première politique stipule qu’un remplacement de pièce est effectué seulement lorsque celle-ci subit une défaillance. Dans la seconde politique, un remplacement de la pièce est effectué lorsqu’elle atteint un âge prédéfini «c ». La troisième politique consiste à remplacer la composante à chaque intervalle de temps « c », peu importe l’âge de la pièce (Leemis, 2009). Pour continuer, la seconde problématique se résout à l’aide des modèles de maintenance. Ces modèles sont utilisés lorsqu’un système doit subir de la maintenance 21 préventive, ainsi que de la maintenance corrective. Le but est donc de déterminer à quel moment il faut effectuer la maintenance préventive, par exemple, à quelle fréquence changée l’huile d’un moteur à combustion. Finalement, il ya les modèles de réparation, qui décrivent la situation où l’action de maintenance s’effectue seulement dans le cas où le système défaillit (Leemis, 2009). Afin de pouvoir répondre à ces situations, il faut utiliser des modèles de probabilités pour déterminer l’occurrence des défaillances. Différents modèles ont été développés, se distinguant selon plusieurs hypothèses. Si le temps de maintenance est négligeable par rapport au temps de fonctionnement par exemple, le temps de défaillance est modélisé par un processus ponctuel. Dans le cas contraire, certains utilisent notamment les modèles de Markov (Leemis, 2009). Pour cette étude, il est raisonnable de faire l ‘hypothèse que les temps de réparations sont négligeables par rapport au temps de fonctionnement. Ainsi, les probabilités peuvent être déterminées entre autres par les modèles HPP et NHPP, qui seront décrits plus bas.

Qualité et nettoyage des données

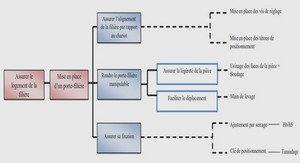

Comme mentionné plus haut, la qualité des données est un enjeu important du projet. En ce sens, la plupart des projets qui nécessitent l’utilisation de données d’opération saisies manuellement font face au même problème. Bien que ce mémoire ne traite pas directement cette problématique, le contexte appliqué du projet force à adopter de bonnes pratiques dans le nettoyage des données. Cette section décrit différentes techniques qui ont été développées. Dans un premier temps, Ho et ses collaborateurs (2015) proposent une étude de cas, appliquer dans la GDA des équipements du domaine minier, afin de recenser différents problèmes issus des données. Ils soulignent que les données enregistrées sont souvent erronées, manquant de détails et de précision, et par conséquent peu propice à aider la prise de décision (Ho, Hodkiewicz, Pun, Petchey, & Li, 2015). L’attention se porte sur différents champs des bases de données relationnelles (BD) et l’étude révèle des faiblesses au niveau de: Ensuite, Hodkiewicz et Ho (2016) proposent de développer une méthode efficiente pour corriger les données, en identifiant les problèmes de qualité à partir des bons de travail de maintenance pour pouvoir faire des analyses de fiabilité. En effet, une méthode de nettoyage de donnée basée sur des règles est développée et appliquée au cas des équipements miniers, sur un jeu de données réelles. Celle-ci permet de démontrer qu’il est possible de corriger les erreurs d’une base de données de maintenance et de les rendre aptes au traitement statistique. Le nettoyage se fait en partie par la récupération d’informations essentielles qui sont consignées dans les champs de texte libre. Prasad et al. (2011) développent un ensemble d’outils pour personnaliser les règles de nettoyages de données, ainsi que les dictionnaires. La principale contribution est de développer un outil d’organisation des règles de nettoyage en élaborant une structure arborescente. La méthodologie débute par l’examen des données, où sont recensées les différentes erreurs. Ensuite, à partir de cette analyse, des règles et des dictionnaires de synonymes et de variantes sont élaborés. Le client peut alors décider d’appliquer les règles sur ces données, puis faire des analyses (Prasad et al., 20 Il).

Quant à Murphy (2019), il étudie la qualité des données, du point de vue de l’ utilisateur. Plutôt que de corriger les données, il analyse l’importance des facteurs humains relatifs à la qualité des données saisies dans un système informatique. La variance dans la qualité des données est influencée grandement par l’utilisateur qui la saisit. Cela démontre la nécessité de développer une meilleure gestion des groupes de travailleurs qui les produisent. En se basant sur la théorie des comportements planifiés, il évalue l’impact de l’attitude, de la perception, et des intentions envers le processus de collecte de données. Il prend aussi en considération l’effet de la pression du temps et de la rétroaction du personnel-cadre auprès des opérateurs. En outre, il démontre l’importance de l’implication et de la valorisation du travail des opérateurs envers la saisie des données, dans le but d’en améliorer la qualité (Murphy, 2009). Berti-Équille (2018) présente les différentes approches, ainsi qu ‘une méthodologie afin de quantifier la qualité des données (diagnostique) et de gérer cette qualité (correction). L’article se divise en trois partie: la gestion et la mesure de la qualité des données, et la correction de ces données (Berti-Équille, 2018). La Figure 2.8 résume les approches de gestion de la qualité des données, tandis que la Figure 2.9 résume une démarche de gestion de la qualité et de la correction des données. De plus, l’auteure détermine plusieurs métriques afin de mesurer la qualité, selon les différents niveaux d’analyse des données.

Modélisation et régression avancées

Pour terminer, des modèles de régression seront appliqués. La revue de littérature a permis d’établir les méthodes existantes pour modéliser les covariables. Ces méthodes seront donc appliquées aux cas des transformateurs, afin de déterminer la ou les méthodes les plus appropriées pour décrire les variables affectant le taux de défaillance. Du même coup, les méthodes qui seront retenues serviront aussi à améliorer la connaissance des équipements et des facteurs qui en affecte la fiabilité. Tout comme les modèles de calcul du taux de défaillance, les modèles de régressions qui seront testés sont adaptés aux systèmes réparables. Les modèles retenus sont des extensions du modèle de Cox, soit les modèles Prentice-Williams-Peterson (PWP) et le modèle Anderson-Gill. Selon l’étude menée par Shwu-Tzy, Landers et Rhoads (2006), les modèles PWP offrent une bonne performance et sont généralement ceux qui sont le plus utilisés en fiabilité. De plus, l ‘hypothèse du modèle PWP est que le risque d’occurrence d’un événement est influencé par les événements qui l’ont précédé (Amorim & Cai, 2014). Cette hypothèse semble appropriée au contexte de la fiabilité des transformateurs. Comme le modèle AG et le modèle PWP-TT utilisent la même structure de données, il sera facile d’implémenter les deux modèles et de les comparer. Une fois que ceux-ci auront été appliqués, des tests statistiques permettront de déterminer si les modèles développés sont statistiquement valides et ainsi discriminer certaines méthodes. Les modèles valides seront alors analysés, afin de déterminer SI certaines variables ont un effet significatif sur le taux de défaillance observé.

REMERCIEMENTS |