Classification des textes et gestion du passage à l’échelle

Les collections de textes évoluent dans le temps et les thèmes qu’elles contiennent changent également : un thème majeur à un moment t peut devenir obso- lète au moment t + 1. Nous avons donc besoin d’une part d’un algorithme de classification qui intègre à la fois les thèmes majeurs et les thèmes qui sont susceptibles de l’être. D’autre part, le traitement d’une collection de textes qui évoluent dans le temps constitue un défi scientifique en raison du passage à l’échelle. Dans ce chapitre, nous proposons un algorithme de classification multicritères et une version distribuée de l’allocation latente de Dirichlet pour gérer le passage à l’échelle. Nous adressons dans ce chapitre, le problème de la classification des textes et celui de la gestion du passage à l’échelle. Notre contribution se résume en la proposi- tion d’une nouvelle méthode pour la classification des textes et une implémentation d’une version distribuée de l’allocation latente de Dirichlet.La méthode de la classification de textes que nous proposons est basée sur l’ana- lyse de la structure de l’espace sémantique avec la prétopologie (section 3.3.1). Chaque document dans cet espace est un vecteur de probabilités qui représente la distribution des thèmes présents dans le document. L’appartenance à une partition ou un groupe de documents est calculée avec deux critères : un critère sémantique et un critère quantitatif. Le critère sémantique est représenté par les thèmes majeurs dans chaque document. Le critère quantitatif est représenté par les distributions de probabilités des thèmes présents dans chaque document.

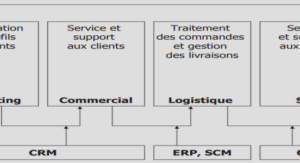

L’implémentation d’une version distribuée de l’allocation latente de Dirichlet (LDA) est basée sur la division d’un grand corpus de textes sur plusieurs unités de calculs ou plusieurs agents. Chaque agent exécute un calcul sur la portion de textes qu’il a reçu et fait remonter ses résultats à un seul superviseur. Ce dernier coordonne l’ensemble des résultats et fournit en sortie, avec la même précision qu’une version séquentielle de LDA, la distribution des thèmes dans les documents et la distribution des mots dans les thèmes.Ce chapitre est organisé comme suit. Dans la première section, nous présentons la méthode de classification multicritères. Dans la deuxième section, nous introduisons notre proposition pour la gestion de la problématique du passage à l’échelle.Dans cette partie, nous adressons la classification de textes avec une nouvelle méthode. Avec cette méthode nous souhaitons classifier des textes en tirant parti des thèmes majeurs (information qualitative) que partagent les textes et la distance entre deux distributions de probabilités qui sont contenues dans la représentation des textes. Cette approche est portée par notre motivation de suivre l’évolution des thèmes dans une collection de textes. Notre hypothèse est que ceci est possible si nous classifions les textes en tenant compte des thèmes majeurs à un temps t mais également des thèmes qui sont susceptibles de devenir importants à un thème t+1. Nous décrivons notre méthode qui consiste à classifier des documents en utilisantla prétopologie, la méthode de l’allocation latente de Dirichlet (LDA) et l’algorithme K-means. Nous rappelons que l’algorithme K-means est une méthode de classifica- tion non supervisée qui consiste à regrouper un ensemble de données en différents sous-ensembles. Les données au sein du même sous-ensemble doivent avoir une dis- tance minimale qui les sépare du centroïde et une distance maximale par rapport aux centroïdes des autres sous-ensembles.

Cette distance est appelée mesure de si- milarité. Malgré qu’il soit largement utilisé pour la classification des documents, l’algorithme K-means possède deux limitations qui consiste en l’initialisation du nombre de sous-ensembles k avant exécution de l’algorithme, et le choix aléatoire Dans cette sous-section, nous définissons deux façons d’associer les documents. La première est basée sur les thèmes possédant une forte probabilité que deux do- cuments partagent et la deuxième est basée sur la distance entre leur distribution de thèmes respective.si tous les thèmes qu’ils contiennent sont proches ou similaires. Nous pouvons utiliser la distance entre deux vecteurs de probabilités qui représente à chacun la distribution des thèmes dans un document. En considérant la distribution de probabilités d’un document comme un vecteur, nous avons le choix entre plusieurs distances, par exemple, la distance euclidienne, le coefficient de Jaccard, le coefficient de la corrélation de Pearson, etc. Néanmoins, et puisque nous travaillons avec des distributions de probabilités il est préférable de choisir des distances qui sont plus adaptées, comme la divergence de Kullback-Leibler, la distance de Bhattacharyya, la distance de Hellinger, etc. Nous avons choisi de travailler avec la distance de Hellinger, car c’est métrique qui est utilisée pour mesurer la déviation entre deux distributions de probabilité, elle est facile à calculer et elle est surtout définie dans [0; 1].