Premiers exemples de systèmes métamimétiques autour du dilemme du prisonnier

Le dilemme du prisonnier métamimétique spatialisé

Nous avons déjà donné au III.1.C.a une ébauche de ce que pourrait être la généralisation dans le cadre métamimétique du dilemme du prisonnier spatial que nous avons vu au I.2. Pour approcher ces systèmes dans le cadre d’une étude computationnelle, nous allons préciser le modèle du dilemme du prisonnier spatial métamimétique et en fournir un exemple particulier. Comme nous l’avons déjà évoqué au III.1.B.a, notre objectif n’étant pas à ce stade de proposer un modèle fidèle des processus de décision humains mais d’étudier tout particulièrement l’effet sur la dynamique globale d’une dynamique au niveau des buts des agents,. Dans cette perspective, certains aspects de l’agent, qui dans d’autres modèles sont fondamentaux, comme les processus d’inférence, les processus d’apprentissage ou les processus éductifs, feront l’objet d’hypothèses par défaut. Nous laisserons une modélisation plus réaliste de ces aspects pour de futurs travaux. Dans tout ce qui va suivre, nous allons nous placer dans le cadre des processus dynamiques en temps discret. III.2.A.a Description du jeu Nous reprenons ici l’essentiel du modèle de Nowak et May que nous avons présenté en I.2 pour l’étendre au cadre métamimétique. Nous allons cependant considérer comme matrice de jeu la matrice du dilemme du prisonnier, qui est bien plus problématique au regard de l’émergence de la coopération que le jeu étudié par Nowak et May. Une étude similaire réalisée à partir de leur matrice a révélé des résultats analogues à ceux présentés ici. Comme dans le modèle original, nous considérerons que les joueurs doivent avoir le même comportement envers tous leurs voisins. Comme nous l’avons vu en I.2., ceci est une manière générale de modéliser les interactions qui trouvent une médiation à travers l’environnement, comme par exemple les situations de partage de ressources renouvelables ou les problèmes de gestion de biens publics. Considérons N² d’agents disposés aux nœuds d’une grille torique bidimensionnelle, chacun jouant un dilemme du prisonnier avec chacun de ses huit voisins, en lui opposant l’un des deux comportements : coopérer (C) ou faire défection (D). Le comportement d’un agent est le même, à une période donnée, envers chacun de ses voisins, bien qu’il puisse en changer 198 Chavalarias D., Métadynamiques en Cognition Sociale d’une période sur l’autre. Le voisinage d’un agent est constitué des agents occupant les huit nœuds adjacents (appelé voisinage de Von Neumann). Lorsque deux agents jouent ensemble, ils reçoivent un gain de R si tous deux ont coopéré et de P si tous deux ont fait défection. Dans le cas où les comportements sont différents, celui qui a fait défection reçoit T, alors que l’autre reçoit S. Nous imposerons T>R>P>S et T+S<2.R de telle sorte que la matrice de jeux soit celle d’un dilemme du prisonnier. Lorsque cela ne sera pas précisé, les valeurs de ces paramètres seront celles utilisées dans Axelrod 1984, c’est-à-dire T = 5, R =3, P =1, S =0.

L’espace des règles d’imitation

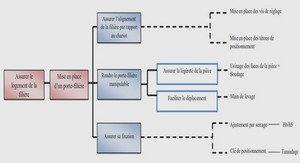

Définissons maintenant l’espace R des règles d’imitation. Ceci nécessite la donnée de trois ensembles : l’ensemble des fonctions de valuation, l’ensemble des fonctions de sélection et l’ensemble des fonctions de modification. Il nous faut donc spécifier les propriétés de chacun de ces trois ensembles. Fonction de valuation : Nous avons vu principalement trois types d’agents au cours des exemples donnés dans la partie I : des agents maximisateurs (Henrich et Richerson, Nowak et May, Orléan, Young), des agents conformistes (Orléan, Young, Henrich et Richerson) et des agents anticonformistes66 (Young). Nous allons proposer ici le plus petit espace de règle qui contienne ces trois formes, auquel nous ajouterons la règle dictant un comportement aléatoire. Pour ceci, nous allons suivre la méthode que nous avons proposée en III.1.C.e consistant à décrire cet espace en termes de calculs possibles sur l’espace des perceptions et d’algorithmes d’optimisation possibles sur le résultat de ces calculs. La fonction de valuation assigne à chaque agent un score et sélectionne l’agent de score maximal. Ainsi en ce qui concerne les scores, nous considérerons des agents capables de : o Calculer les densités sur un ensemble de traits à caractère discret. o Multiplier une valeur numérique par –1. En ce qui concerne le type d’optimisation que les agents sont capables de faire sur les scores, nous considérerons qu’ils sont capables : o De calculer le maximum de deux valeurs numériques o De choisir au hasard .Etant donné que les agents perçoivent les gains de leurs voisins, ceci nous donne un espace de cinq critères d’évaluation possibles : l’évaluation par les gains en termes de minimisation et maximisation, l’évaluation par la densité des traits en termes de densité maximale ou de densité minimale, l’évaluation au hasard.Fonction de sélection : une fois désignés le ou les meilleurs voisins par la fonction de valuation, l’agent doit sélectionner le trait qu’il va chercher à modifier en inférant le ou les traits susceptibles d’avoir participé à cette bonne évaluation. Plusieurs choix sont possibles pour la règle d’inférence utilisée, et il est tout à fait envisageable de considérer dans un même jeu plusieurs règles d’inférences qui définiraient des règles d’imitation différentes. Nous évoquerons ce point au III.3.A. Nous nous contenterons ici de considérer une seule règle d’inférence et donc une seule fonction de sélection. Nous adopterons comme règle par défaut la règle 1 proposée dans l’encart 11 : les agents choisissent de revoir leurs règles avec une probabilité α et revoient leur comportement soit parce qu’ils ont changé de règle, soit spontanément avec une probabilité θ (toujours à la condition qu’ils ne se considèrent pas déjà comme les meilleurs). Les situations telles que α=1, et θ=1 correspondront au cas de mise à jour parallèle synchrone des règles puis des comportements (règle 2). Lorsque l’un de ces deux paramètres sera inférieur à un, nous aurons des mises à jour parallèles asynchrones. Par ailleurs, nous supposerons qu’un agent qui ne se considère pas comme le meilleur mais dispose de plusieurs modèles équivalents, choisira d’imiter l’un d’eux au hasard. Par exemple, si un agent (D,maxi) a comme meilleur voisin un agent (C, conformiste), celui-ci attribuera le succès de ce voisin à son comportement coopérateur avec une probabilité (1-α).θ, et au fait qu’il est conformiste avec une probabilité α, ce qui l’amènera par la même occasion à revoir son comportement.