Structuration de l’information parlée

La chaîne de structuration Speeral

Le système de structuration de parole du LIA effectue la transcription du contenu parlé d’un document audio et génère une segmentation en locuteurs tout en étiquetant les zones de silence et de musique. La plupart des outils ont été développés au LIA et utilisent des techniques classiques d’apprentissage artificiel. La figure 3.2 détaille le fonctionnement de la chaîne étape par étape.

Paramétrisation acoustique

La parole est stockée sous la forme d’un signal numérique généralement quantifié sur 16 bits à une fréquence de 16000 échantillons par seconde. La plupart des tâches de structuration reposent sur une reconnaissance de forme dans cet espace. Pour rendre cette reconnaissance possible, les paramètres d’un modèle de production et/ou de perception sont représentés sous forme de vecteurs dans un « espace acoustique ». Les paramètres les plus répandus sont : Linear Predictive Cepstral Coefficient (LPCC, Rahim et Lee, 1996), Mel Frequency Ceptstrum Coefficents (MFCC, Davis et Mermelstein, 1980), ou encore Perceptual Linear Predictive (PLP) analysis (Hermansky, 1990). Dans la chaîne présentée, le signal de parole est découpé en vecteurs acoustiques (d’une portée de 25 ms, avec un décalage de 10 ms) représentant les fréquences caractéristiques de la parole, ainsi que leur dynamique. Les paramètres extraits prennent en compte à la fois la production et la perception de la parole (12 coefficients PLP et l’énergie, leurs dérivées et dérivées secondes, soit 39 dimensions pour la transcription (Lévy et al., 2004) ; les autres tâches reposent sur des jeux de paramètres similaires).

Segmentation en classes acoustiques

Un segmenteur en classes acoustiques permet de séparer les différents types de signaux (parole, silence, musique, bruit) et de classifier le type de parole (genre du locuteur, téléphone ou studio, parole sur musique) afin d’utiliser des modèles adaptés à l’environnement acoustique durant les phases suivantes. Cette approche est implémenMM) ergodique dont les états sont modélisés par des Gaussian Mixture Models (GMM, Fredouille et al., 2004). Ces densités de probabilités sont estimées par l’algorithme EstimationMaximisation (EM, Dempster et al., 1977) ; les probabilités de transition entre les états sont estimées par l’algorithme Baum-Welch (Baum et al., 1970). Cette approche est illustrée dans la figure 3.4. La séquence la plus probable est trouvée par programmation dynamique à l’aide de l’algorithme Viterbi (Viterbi, 1967).Ce type de modélisation a été étendu à d’autres tâches : Atrey et al. (2006) appliquent les techniques de modélisation GMM à la détection d’événements sonores (bruits de pas, course, pleurs, bruits de chute) pour la surveillance multimédia ; Dufaux et al. (2000) utilisent des techniques similaires, pour détecter des événements sonores dans un environnement bruité.

Indexation en locuteurs

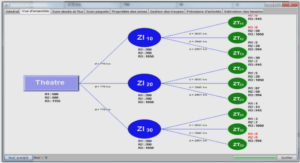

L’indexation en locuteurs consiste en une étape de segmentation en tours de parole, suivie du regroupement des tours de parole en locuteur et d’une identification des locuteurs connus (suivi de locuteur). Connaître l’identité des locuteurs permet l’emploi de modèles adaptés pour les locuteurs fréquents lors de la phase de transcription (comme, par exemple, les présentateurs d’émissions radiophoniques). Dans notre cas, la segmentation et le suivi de locuteur sont réalisés grâce aux outils LIA_SpkSeg et LIA_SpkDet, fondés sur Alize1 (Istrate et al., 2005). La segmentation est générée par un HMM dynamique auquel est ajouté un état à chaque fois qu’un nouveau locuteur prend la parole. Les locuteurs connus sont ensuite recherchés parmi les regroupements de tours de parole. La décision de classification provient du rapport de vraisemblance entre un modèle de locuteur et un modèle générique (UBM). Comme peu de données sont disponibles sur l’occupation de l’espace acoustique par un locuteur, le modèle de ce locuteur est estimé à l’aide d’une adaptation du modèle générique aux données observées (voir figure 3.5).

Transcription automatique

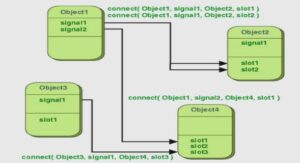

La transcription orthographique consiste en une reconnaissance de la séquence de mots prononcée dans un flux de parole. Les systèmes de transcription actuels sont indépendants du locuteurs, traitent de la parole continue et reconnaissent un vocabulaire étendu (Large Vocabulary Continuous Speech Recognition, LVCSR). Dans la chaîne de structuration présentée, la transcription automatique est effectuée en 2 passes, dont la première sert à générer rapidement une séquence de mots approximative. Celle-ci permet une adaptation en aveugle des modèles acoustiques. Les modèles ainsi adaptés sont utilisés en deuxième passe. Le système de transcription, Speeral (Nocéra et al., 2004), est un moteur de reconnaissance de la parole grand vocabulaire, multi-locuteurs utilisant une reconnaissance HMM des phonèmes, un lexique de phonétisation et des modèles linguistiques n-grammes. Le meilleur chemin dans le graphe d’hypothèses est déterminé grâce à une version modifiée d’A⋆ basée sur une estimation à moindre coût de la fin de la transcription (acoustique et prédiction linguistique) et une méthode d’élagage de l’arbre d’hypothèses. Des ouvrages comme (Huang et al., 2001), (De Mori, 1998), ou (Haton et al., 2006) expliquent plus en détail le fonctionnement d’un système de transcription de la parole.

Traitements de plus haut niveau

La segmentation en macro-classes acoustiques, l’indexation en locuteurs et la transcription orthographique représentent les éléments de structuration fournis par la chaîne au début des travaux présentés dans ce document. Nous y avons ajouté des traitements 61 Chapitre 3. Structuration de l’information parlée spécifiques au résumé automatique : une segmentation en phrases et une détection d’entités nommées. Ces modules sont décrits en détail dans les sections 4.1 et 4.2. Nous n’abordons pas la segmentation et le suivi de thèmes qui pourraient aussi être importants selon les traitements de haut niveau envisagés. Walls et al. (1999) proposent une détection de thème dans des émissions radiodiffusées. Shriberg et al. (2000) étudient des paramètres prosodiques pour une détection de frontières thématiques.