Supervision, surveillance et diagnostic

Dans les processus industriels, la majorité des pannes causant une baisse de la production est généralement due à des anomalies dans le procédé qui n’ont pas été corrigées à temps. En plus des contraintes de la qualité des produits et celles économiques, il y a plusieurs autres intérêts afin d’assurer un fonctionnement normal pour ces processus. La détection, ou même l’anticipation d’une défaillance au début de son apparition peut éviter de grands dommages et catastrophes. Par conséquent, la détection et le diagnostic des défaillances de processus représentent un intérêt capital. Pour les processus complexes ou ceux de type boites noires, il est souvent très compliqué voire impossible de leur établir des modèles mathématiques. Même si la réalisation de tels modèles est possible, les approches analytiques présentent toujours une vision insuffisante des fonctionnements des processus (Verron et al., 2008). Une connaissance profonde de la dynamique de ces processus est un atout primordial pour une interprétation fiable de leurs déréglages. Dans ce cadre, les approches qui permettent l’identification des états de fonctionnement en se basant sur l’analyse des informations extraites des données ou des mesures des processus peuvent apportées une aide avantageuse pour la détection et le diagnostic de défauts. Plus particulièrement, les approches statistiques sont parmi les techniques les plus exploitées dans ce contexte. La surveillance de processus en s’appuyant sur une analyse des mesures a pour but la détection des variations survenues dans les variables caractéristiques de tels processus. Pour prendre les actions correctives nécessaires afin d’améliorer le processus, un diagnostic doit être mené pour l’isolation des défauts causant ces variations. Le principe d’une telle analyse repose sur une maîtrise ou un contrôle statistique de processus. Une telle discipline est la traduction intégrale de celle en anglais statistical process control largement connue dans la littérature sous l’abréviation du SPC. Le contrôle statistique de processus a été initié par W.A. Shewhart en 1924 aux Etats-Unis. C’est en étudiant la variabilité des particules dans des fluides que Shewhart a inventé la célèbre carte de contrôle (Shewhart, 1931). Oubliée depuis, ce n’est qu’à partir des années soixante après la deuxième guerre mondiale qu’il y a eu réellement regain d’intérêt pour cette discipline, et c’est au Japon qu’elle a vite pris racine. La maîtrise statistique de processus a fortement contribué à l’amélioration de la qualité des produits japonais, ce qui explique entre autre le fabuleux succès industriel et économique qu’a connu ce pays. Son apparition en Europe débuta à partir de la fin des années 70, poussée par les effets de la mondialisation, des échanges et de l’accroissement de la concurrence internationale. Une telle maîtrise statistique reposait encore sur des techniques univariées. A cette époque, beaucoup d’améliorations ont été proposées mais peu de chercheurs s’intéressaient à ces méthodes statistiques. L’activité de recherche a connu une dynamique très importante à partir des années 80 (Za¨ıdi, 1989; Elbekkaye, 1993). De nos jours, ces méthodes statistiques sont utilisées dans de nombreux secteurs pour le contrôle des processus, la détection et la prévention de leurs défauts. Les cartes de contrôle uni et/ou multivariées sont les outils finaux d’une mise en œuvre d’un contrôle statistique de processus. Elles servent à visualiser l’évolution temporelle d’un processus et à détecter les changements susceptibles de modifier ses performances. En revanche, les corrélations entre les variables ont été une cause principale limitant l’efficacité de l’utilisation de la carte univariée en ouvrant ainsi les portes aux notions multivariées. La plus célèbre carte de contrôle multivariée est celle de la T2 de Hotelling (Hotelling, 1947). Le contrôle multivarié a la capacité de combiner des mesures multidimensionnelles en une seule mesure de performance. Néanmoins, la dimensionnalité des processus et les colinéarités qui peuvent exister entre les variables limitent également l’efficacité en termes de détection et d’isolation de défauts par l’interprétation directe de telle carte. La réduction de la dimension de l’espace des variables en utilisant les méthodes de projection comme l’analyse en composantes principales peut révéler des informations cachées mieux interprétables et exploitables. Ce chapitre tracera, dans la deuxième et la troisième section, les principaux concepts définissant la supervision et plus particulièrement la surveillance et le diagnostic de processus. La quatrième section présentera un sommaire des approches statistiques ainsi que leurs extensions et évolutions pour la détection et le diagnostic. L’objectif de cette section est de mettre en contexte l’intérêt de l’utilisation des méthodes de projection, en particulier l’analyse en composantes principales linéaire et ses extensions.

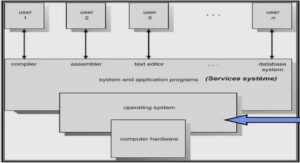

Supervision des processus

Dans un contexte économique de productivité et de flexibilité, la supervision a bénéficié d’une avancée technologique exceptionnelle née du besoin d’un outil de visualisation des processus industriels. A ses débuts, elle se composait d’un grand tableau mural représentant la vision des opérateurs du processus industriel. Avec l’essor informatique, les voyants ont été remplacés par des écrans et des claviers. Le but restait le même : contrôler et commander un processus industriel. La supervision établit l’état actuel du système pour pouvoir prendre des décisions et pouvoir maintenir ses critères de performance (qualité, rentabilité, sˆureté, etc.). Elle consiste à surveiller l’état de fonctionnement d’un procédé pour l’amener et le maintenir à son point de fonctionnement normal. En effet, la supervision a pour vocation première d’émettre des alarmes dont l’objectif est d’attirer l’attention de l’opérateur de supervision sur l’apparition d’un ou de plusieurs événements susceptibles d’affecter le bon fonctionnement du système. Compte tenu de la complexité des procédés, la génération d’alarmes est le moyen le plus employé pour avertir l’opérateur de l’occurrence d’un événement anormal. Les alarmes sont donc liées aux dysfonctionnements pouvant apparaître sur le processus. Pour cela, il est important de préciser le sens accordé aux termes employés pour évoquer les dysfonctionnements pouvant survenir dans le système.

Concepts associés à la supervision des processus

Après avoir décrire le rôle de la supervision, il reste alors à présenter ses principales étapes. Néanmoins, il est question de donner tout d’abord les différents concepts rencontrés dans la littérature concernant la supervision, la détection et le diagnostic de défauts, car de bons supervision, détection et diagnostic nécessitent une bonne compréhension des ces notions. En se référant à la littérature, on reconnaît immédiatement que la terminologie dans ce domaine n’est pas uniforme. En effet, les définitions peuvent présenter de différences provenant du fait que la supervision, la détection et le diagnostic de défauts peuvent être abordés de différentes manières selon l’origine et la formation des intervenants (Zwingelstein, 1995; Isermann et Ballé, 1997; Hern´andez-De-Le´on, 2006). • Un système est dans un état de fonctionnement normal si ses variables caractéristiques (variables d’état, variables de sortie, variables d’entrée, paramètres du système) demeurent au voisinage de leurs valeurs nominales. Le système est dit défaillant dans le cas contraire ; • Une anomalie représente une condition anormale diminuant ou supprimant l’aptitude d’un ensemble (de composants) à accomplir une fonction requise. Ce terme générique permet de décrire tout ce qui n’est pas conforme à une référence ; • Une défaillance est l’altération ou la cessation de l’aptitude d’un ensemble (de composants) à accomplir sa ou ses fonctions requises avec les performances définies dans les spécifications techniques. Après défaillance d’une entité, celle-ci est en état de panne. La défaillance est un passage d’un état à un autre, par opposition à une panne qui est un état ; • Une dégradation caractérise le processus qui amène à un état défaillant du procédé ; • Un défaut se définit comme une anomalie du comportement d’un système sans forcément remettre en cause sa fonction mais peut présager d’une défaillance à venir ; • Une panne caractérise l’inaptitude d’un dispositif à accomplir une fonction requise. Un système est généralement considéré en panne dès l’apparition d’une défaillance. Ainsi, la panne est la cause de l’apparition des symptômes ; • Un symptôme est l’événement qui révèle d’un dysfonctionnement. Il s’agit de l’effet conséquent d’un comportement anormal. Ainsi, il est le seul signe dont dispose le système de surveillance au moment de la détection d’une anomalie. Pour parvenir à déterminer et caractériser les anomalies d’un système, on fait nécessairement référence à des informations sur le comportement et/ou le fonctionnement du système considéré. Ces informations sont généralement extraites des observations de l’environnement du système ou de sa modélisation de connaissance. Pour cela, les définitions des termes observation, mesure et signe (Zwingelstein, 1995; Ploix, 1998; Vellemans, 2006) sembleraient également essentielles : • Une observation est une information obtenue à partir du comportement ou du fonctionnement réel du processus ; • Une mesure est une observation élémentaire du fait qu’elle reflète une et une seule grandeur physique. Elle est représentée par une variable dont le contenu est l’image d’une grandeur physique. Son obtention s’effectue par l’intermédiaire d’un système physique (capteur). Ainsi, les mesures peuvent être de différentes natures : ✓ qualitatives : représentées par un ensemble fini de modalités dont chacune est associée à un symbole ; ✓ quantitatives : dont les valeurs appartiennent à l’ensemble des réels ; ✓ logiques : valeurs tout ou rien {vrai, faux} souvent elles correspondent respectivement aux valeurs {0, 1} ; ✓ floues : représentées par des fonctions d’appartenance, dont les valeurs sont comprises dans l’intervalle .

Les étapes de la supervision

Le mot supervision est abondamment utilisé par la communauté des automaticiens. Bien qu’il n’est pas évident d’en donner une définition qui fait l’unanimité. La supervision est généralement présentée comme étant la commande et la surveillance de l’exécution d’une opération ou d’un travail accompli par d’autres agents (hommes ou machines). Notamment, elle regroupe l’ensemble des outils et méthodes qui permettent de conduire des installations industrielles tant en fonctionnement normal qu’en présence de défaillances ou de perturbations. Pour mener correctement la supervision d’un processus, il est nécessaire de définir l’ensemble des étapes que peut inclure. Dans ce cadre, la littérature a offert plusieurs propositions. Comme exemple, Breuker et Van De Velde (1994) ont fourni une large perspective en suggérant que les étapes d’une supervision se succèdent en une chaîne de planification, prédiction, surveillance, diagnostic et affectation des tˆaches pour le contrôle du processus et la manipulation des dispositifs. Néanmoins, il y a quelques tˆaches infaisables en ligne. Ainsi, Acosta et al. (2001) ont encore utilisé une représentation plus différente en proposant une supervision dite globale constituée de huit étapes fondamentales qui sont : la surveillance, le diagnostic, l’évaluation d’état, le mode de fonctionnement, le pronostic, la planification, l’interface HM et la validation des données. Malgré la diversité des propositions, le plus souvent la supervision prend en compte trois étapes principales, notamment la surveillance, le diagnostic et la reconfiguration (ou prise de décision). Ces étapes peuvent être assurées par des algorithmes (machines) comme par un ou plusieurs opérateurs humains. L’étape de la surveillance (ou monitoring) traite les données recueillies en ligne afin d’obtenir l’état de fonctionnement du processus. En présence des anomalies, le diagnostic consiste à estimer leurs causes afin que des actions de corrections soient prises (reconfiguration). Dans ce contexte, la figure 1.2 présente un schéma récapitulatif retra¸cant les principales étapes de la supervision d’un processus.