Avec l’évolution des processus technologiques permettant la démocratisation et la miniaturisation des systèmes d’acquisition et de traitement de l’information, la vision par ordinateur et l’imagerie numérique ont gagné de plus en plus d’importance dans le secteur industriel (automatisation et contrôle de qualité) comme dans la société civile (vidéo surveillance, reconnaissance de visages, cinéma, photographie numérique, imagerie médicale) et les structures militaires (véhicules autonomes, téléguidage, …), ainsi que dans la vie de tous les jours. Le nouvel enjeu maintenant est de pouvoir assembler les briques de base développées ces dernières années, pour construire des systèmes de vision complets, performants et robustes en se basant sur ce que les nouvelles technologies nous offrent de point de vue outils matériels ainsi que logiciels. Finalement, on arrive à un point où la théorie et les algorithmes de base sont bien connus et où le matériel est devenu performant et facilement disponible. Dans ce même contexte, la robotique mobile n’a pas cessé d’attirer l’attention, notamment pour remplacer l’homme dans des environnements à risques (zones radioactives, robots militaires) ou des zones qui lui sont inaccessibles (exploration planétaire ou sous-marine), ou à des échelles différentes (robot à l’intérieur d’une canalisation, voire robot chirurgical à l’intérieur du corps humain).

Dans ces travaux de thèse, on s’intéresse plus particulièrement à l’exploration d’environnements sous marins qui a émergé dans le cadre d’un projet regroupant plusieurs géologues, roboticiens et scientifiques. Elle est issue du besoin de mieux connaître, de caractériser les réseaux sous-marins, appelés des réseaux karstiques. Néanmoins, la présence de courants assez rapides et de configurations topologiques complexes empêche d’envoyer des plongeurs humains tout en restant dans des conditions de sécurité optimales. L’idée est donc d’envisager l’exploration de ces réseaux sous-marins à l’aide d’un robot muni de caméras. Celui-ci devra se déplacer le plus possible au centre du conduit et être capable d’enregistrer des données géologiques sur l’environnement sous-marin.

L’objectif de ces travaux de thèse est de mettre au point une application qui sera dédiée à la robotique mobile sous-marine basée sur la notion de la vision et l’approche de la reconstruction 3D permettant de restituer la structure d’un environnement inconnu sous-marin en se basant uniquement sur des données de perception. Afin d’atteindre cet objectif, on a été mené à développer un prototype d’essai nous permettant en premier lieu de proposer tout d’abord un système de vision générant une image compréhensible de l’environnement et de proposer un processus algorithmique permettant de restituer la structure 3D d’un milieu confiné aquatique tout en respectant d’une part les contraintes temps-réel exigées par l’application et d’autres part, les conditions physiques et optiques de l’environnement.

De point de vue système d’acquisition, il existe de nombreuses technologies permettant de fournir des mesures 3-D. Dans les travaux présentés dans ce mémoire, une étude a été consacrée aux systèmes de vision 3D à large champ. Cette étude permet de choisir judicieusement les éléments du système de vision et sa configuration afin de répondre au mieux au besoin de l’application tout en tenant en considération les contraintes de l’environnement qui sera exploré. La vision omnidirectionnelle est privilégiée car elle augmente le champ de vision des capteurs, notamment l’utilisation des capteurs catadioptriques (combinaison de miroir(s) + caméra(s)) qui représentent une solution simple et rapide pour atteindre une vue large satisfaisante. Une estimation des paramètres intrinsèques et extrinsèques de l’ensemble permet la modélisation géométrique du système de vision représentant au mieux son comportement physique et optique dans l’environnement exploité. Cette modélisation sera par la suite utilisée pour l’estimation de la structure tridimensionnelle de la scène en se basant sur l’approche de la triangulation stéréoscopique. Des données métriques seront aussi estimées et peuvent être utilisées pour le contrôle de la navigation de l’engin et lui assurant une navigation sans danger.

De point de vue algorithmique, plusieurs travaux ont été proposés dans la littérature considérant les contraintes liées aux conditions environnementales d’un milieu sous-marin. En effet, à cause des propriétés physiques de l’eau (les particules d’eau, l’absorption de la lumière et la diffusion) les méthodes standards de traitement d’images ne peuvent plus être utilisées. Les plus grandes longueurs d’onde sont les plus absorbées et par conséquent, les images sont faiblement contrastées et manquent de luminosité et de texture. D’autre part, le phénomène de diffusion de la lumière sous l’eau est différent de celui dans l’air et affecte principalement le comportement physique du capteur d’images. Par conséquent, les paramètres standards (données par le constructeur) caractérisant le capteur ne peuvent plus être utilisés dans ce cas.

Dans le cadre des travaux de cette thèse, nous proposons de développer un système 3D capable de fournir des informations utiles à analyser et en extraire la structure 3D d’un milieu aquatique de forme inconnue à l’aide d’une chaine de traitement d’image. L’objectif est de pouvoir s’approcher le plus possible des conditions d’expérimentations réelles. Notre contribution concerne différents aspects:

♦ Développement d’un système 3D permettant de répondre simultanément aux contraintes de l’environnement et au problème de reconstruction 3D de milieux sous-marins.

♦ Etalonnage du système stéréoscopique omnidirectionnel pour l’estimation de ses paramètres intrinsèques et extrinsèques représentant son comportement dans un environnement aquatique.

♦ Proposition d’un algorithme permettant d’estimer la structure 3D de l’environnement exploré et ses données métriques : la modélisation géométrique du système de vision permet de remonter à l’espace 3D tout en prenant en compte la nature physique et optique des phénomènes qui interfèrent lors de l’acquisition.

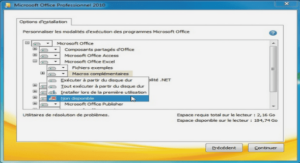

♦ Proposition d’une architecture matérielle synthétisable de l’algorithme proposé permettant d’assurer les performances nécessaires à notre système en termes de temps d’exécution, de précision et de ressources.

Au moyen-âge, le mathématicien perse Ibn al-Haytham (dit Alhazen) a expliqué le phénomène de la vision. Ce sont, en effet, des rayons lumineux émis par chaque point d’un objet, qui sont en mouvement en ligne droite et formant une image sur le cristallin de l’œil. En 1637, René Descartes a publié son livre « La Dioptrique » dans lequel il détaille quelques phénomènes en optique géométrique, notamment la réfraction. Il décrit aussi le fonctionnement de l’œil où l’image se forme sur la rétine. En 1704, Isaac newton, s’étant beaucoup intéressé aux couleurs, a publié son traité « Opticks » où il expose son explication sur la lumière mécaniquement. Il décrit les différents couleurs comme un flot de particules ou corpuscules dont la vitesse n’est pas la même. Il explique ainsi le phénomène de réfraction.

La physiologie de la perception visuelle et des couleurs en particulier a réellement progressé avec Thomas Young. Son apport au domaine de l’optique est sans doute son plus grand motif de célébrité, en particulier sa célèbre expérience de la double fente en 1801. Young, considéré comme le fondateur de l’optique physiologique, s’intéressait aussi aux récepteurs sensoriels de l’œil et découvrit les couleurs primaires : rouge, vert et bleu (RVB). Il proposa donc l’hypothèse, confirmée plus tard, que la vision humaine n’utilise que les trois capteurs RVB pour réaliser la synthèse de toutes les autres couleurs [1].

Au cours des années 1970, Samir Zeki, un physiologiste turc, a prouvé que le traitement de l’information visuelle dans le cerveau s’organise en différentes voies séparées et spécialisées:

– reconnaissance du mouvement, de la forme, de la séparation figure/fond, organisation de la scène dans l’espace,

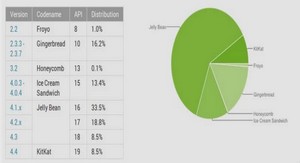

– reconnaissance des objets, des visages, et perception des couleurs. Au cours des années 2000, la puissance des ordinateurs devient considérable, il devient possible à de nombreux ordinateurs de traiter le son et la vidéo, l’apparition de la réalité augmentée, la synthèse d’images de scènes complexes, l’apparition des systèmes d’indexation et de recherche d’images, le développement des approches statistiques et les méthodes temps réel.

Il y a vingt ans, David Marr proposa une approche computationnelle de la représentation et de la manipulation des informations visuelles chez l’homme et pour la machine. Ses travaux présentent le plus bel exemple d’élaboration d’une « Théorie de la vision » en proposant un modèle pour le traitement et la représentation de l’information visuelle. C’est en effet la première méthodologie complète pour la vision par ordinateur, plus connue sous le nom de « Paradigme de Marr ». Ses recherches se sont principalement focalisées sur la reconstruction de scènes basées souvent sur les modèles mathématiques reposant sur des fonctions continues, la géométrie euclidienne, l’analyse différentielle [2]. Trois niveaux de représentations avaient été introduits par Marr :

♦ Traitement bas-niveau : la représentation des propriétés de l’image 2-D en termes de primitives. Ce premier niveau de représentation est appelé « première ébauche »,

♦ Traitement moyen-niveau : la représentation tridimensionnelle des surfaces visibles afin d’extraire une première représentation spatiale de la scène sans la reconstruire en 3D car les informations retrouvées restent insuffisantes pour décrire la localisation des objets dans l’espace tridimensionnel. Cette représentation est appelée « ébauche 2.5D »,

♦ Traitement haut-niveau : la représentation centrée objet de la structure tridimensionnelle en se basant sur les informations 3D de la scène issues de la caméra et la carte de profondeurs obtenue précédemment.

Introduction Générale |