La chaine d’acquisition : du photon à l’information numérique

Le rayonnement incident, émis ou réfléchi par un objet distant de la scène observée, est tout d’abord focalisé sur la surface photosensible à l’aide d’un système d’optique. Le capteur permet de transformer la lumière incidente en un signal électrique analogique. Un filtre de couleur appelé filtre de Bayer est placé en amont du capteur afin d’obtenir l’information de couleur de l’image. Chaque pixel produit un signal correspondant à une des trois couleurs (rouge, vert, bleu) en fonction de la couleur du filtre placé devant lui. Le signal analogique des pixels est lu puis numérisé grâce à un convertisseur. La couleur est ensuite reconstruite par interpolation spatiale dans l’unité de traitement aval. Pour des capteurs d’image destinés à produire des images agréables à l’œil, d’autres traitements relatifs à la qualité de l’image peuvent être effectués comme la balance des blancs, une correction de couleur ou la correction de défauts dû aux imperfections de l’optique et de l’imageur. Enfin, l’image est compressée puis stockée.

Architectures pixel

Le pixel est l’élément de base des capteurs d’images, il est composé d’une photodiode ainsi que de plusieurs transistors afin de permettre la lecture de l’intensité de la lumière reçue sur la photodiode. Deux méthodes se distinguent pour les méthodes conventionnelles de lecture CMOS, la lecture en tension et la lecture en courant la photodiode est polarisée en inverse et initialisée à une tension haute VDD, puis sa tension décroit linéairement avec la lumière incidente. Après un certain temps appelé temps d’intégration, la tension de la photodiode est lue.

les photons incidents pénétrant dans la zone de charge espace de la photodiode forment des paire électrons-trous. Les charges sont accumulées dans la photodiode et le courant résultant sera d’autant plus élevé que la lumière incidente sera forte. Cependant il est limité par la capacité de la photodiode. Après le temps d’intégration, les charges sont transférées à l’extérieur de la matrice de pixel.

Problématique du traitement d’images dans les capteurs de vision

L’information lumineuse peut être traitée de deux façons différentes, au niveau du signal analogique ou bien au niveau du signal digital, c’est-à-dire avant ou après l’ADC. On parle ici des traitements intégrés au capteur et non réalisés par une unité de traitement externe au circuit ou même un autre circuit. Le principal avantage des traitements analogiques est qu’ils consomment moins d’énergie comparés aux traitements digitaux, qui eux ont l’avantage d’être plus précis et plus facilement programmables [Ohta2008]. Ces traitements sont implémentés dans des « processing elements » (PE) qui peuvent être placés , au niveau du pixel [Massari2005], en pied de colonne [Elouardi2007] ou un PE pour toute la matrice [Panovic2016]. Usuellement, seuls des prétraitements sont effectués dans le capteur et des traitements plus complexes sont réalisés en dehors du capteur.

Les capteurs d’images événementiels

A l’inverse des capteurs conventionnels, l’information dans les capteurs événementiels n’est pas une tension ou un courant lu à la fin du temps d’intégration. L’information est représentée par le chronométrage ou le front d’impulsion d’un ou plusieurs signaux binaires générés, correspondant à la réalisation d’un événement.

Le domaine temporel : Dans le cas des capteurs d’image événementiels, l’événement le plus courant est le passage d’un seuil prédéfini par la tension de la photodiode. Pour ce faire dans chaque pixel se trouve un comparateur. La gestion de cet événement peut-être diverse. Les principales méthodes sont le pulse width modulation (PWM) et le pulse frequency modulation (PFM). Le PWM prend en compte le temps auquel le pixel a généré son signal et le convertit directement en intensité lumineuse, alors que le PFM définit l’intensité lumineuse incidente par la fréquence des signaux générés par le pixel. Cela permet au pixel de «choisir» son temps d’intégration optimal. Ainsi la dynamique n’est plus restreinte par le niveau de tension d’alimentation ce qui permet une intégration plus robuste en nœuds technologiques avancés, d’autant plus qu’un signal de type binaire est généré et propagé sur le bus colonne.

Lecture des événements : La lecture des évènements peut prendre deux formes différentes : la lecture synchrone et la lecture asynchrone. Lorsqu’un pixel génère un événement, on dit que ce pixel flashe. La lecture synchrone permet de lire tous les pixels successivement, elle est liée à une horloge. La lecture asynchrone .

Caractéristiques principales des capteurs

Taille du pixel : Plus la surface du pixel est petite et plus la matrice de pixels est petite. Cela permet de limiter les coûts de fabrication. Les pixels les plus petits sont de l’ordre du µm et la taille classique est de 3 à 5µm.

Résolution : La résolution du capteur peut être définie selon plusieurs critères. Tout d’abord par la résolution spatiale, la taille de la matrice de pixel (array size) est exprimée en nombre de lignes et colonnes de pixels. La résolution est également définie par la fréquence d’image dit « frame rate » définie en trames par seconde (frame per second : fps) c’est la résolution temporelle.

Dynamic range (Dynamique de sensibilité à la lumière) : La dynamique de fonctionnement (dynamic range : DR) permet de mesurer la qualité de l’image obtenue. En effet, elle détermine la capacité du pixel à détecter diverses luminosités sans perdre de détail. Elle sera déclinée en nombre de niveaux de gris disponibles et donc codée sur un nombre de bits définis. Pour les capteurs d’images, elle est définie, en décibels, comme le rapport entre le signal d’entrée maximal non saturé sur la plus petite valeur d’entrée détectable. Il sera noté que l’œil humain a une dynamique supérieure à 140dB.

Sensibilité et rapport signal/bruit : La sensibilité du capteur prend en compte plusieurs caractéristiques. L’efficacité quantique (quantum efficiency : QE) de la photodiode, correspondant au nombre d’électrons générés par photon reçu.

De plus, le bruit a une influence sur la sensibilité du capteur. Il existe plusieurs sortes de bruits dans un capteur d’images : le bruit temporel et le bruit spatial fixe (fixed pattern noise FPN). Le bruit temporel peut être lui décomposé en trois catégories : le bruit de scintillement (flicker noise ou bruit en 1/f), le bruit de grenaille (shot noise) et le bruit thermique. Le bruit en 1/f est causé par des impuretés dans le matériau, créant des puits de potentiel, ou au contraire des charges libre en plus. Le bruit de grenaille vient de la nature granulaire de l’électricité ce qui crée une fluctuation du nombre de porteurs en fonction du champ électrique, créant des perturbations de courant. Enfin, le bruit thermique correspond à l’agitation thermique des porteurs créant une variation de potentiel aux bornes du conducteur, créant une légère fluctuation de la tension. De même, le bruit spatial fixe peut être divisé en deux parties, celui prenant place dans le pixel et celui dans les transistors placés en pied de colonne. Ce bruit correspond aux dispersions technologiques (mismatch). Le bruit de courant d’obscurité (dark current) correspondant au courant généré par la photodiode alors qu’aucune lumière n’arrive sur le capteur est contenu dans le FPN du pixel. La sensibilité du capteur est mesurée avec le ratio signal sur bruit (signal to noise ratio SNR) en décibel.

Table des matières

Introduction

1 Chapitre I : Acquisition d’image

1.1 Introduction

1.2 Les capteurs d’images usuels : généralités

1.2.1 La chaine d’acquisition : du photon à l’information numérique

1.2.2 Caractéristiques principales des capteurs

1.2.3 Architectures pixel

1.2.4 Problématique du traitement d’images dans les capteurs de vision

1.2.5 Avantages et inconvénients des différentes architectures pixels usuelles

1.3 Les capteurs d’images événementiels

1.3.1 Le domaine temporel

1.3.2 Lecture des événements

1.3.3 Traitement des événements

I.3.1 Avantages et inconvénients des capteurs d’images évènementiels

I.4 Conclusion de l’état de l’art, positionnement et justification des contributions de la thèse

2 Chapitre II : Les technologies avancées pour l’imagerie

2.1 Introduction

2.2 Matériaux photosensibles

2.3 Collecte des électrons

2.4 Technologies avancées

2.4.1 Evolution de la taille de la lithographie et conséquences

2.4.2 Technologies avancées pour l’imagerie

2.5 FD-SOI 28nm

2.5.1 Principe et avantages

2.5.2 Fuites de courant et conséquences pour l’acquisition d’image

2.6 Technologies émergentes au LETI

2.6.1 Etendre les fonctionnalités des transistors FDSOI en les rendant sensibles à la lumière et exploiter ces nouvelles fonctionnalités

2.6.2 Implémentation 3D

2.7 Travaux de test réalisés pendant cette thèse

2.7.1 Vérification de la sensibilité à la lumière du FD-SOI 28nm

2.7.2 L’approche envisagée de l’architecture par rapport aux avantages et inconvénients technologiques et des acquisitions des imageurs

2.8 Conclusion

3 Chapitre III : Mécanismes d’acquisitions d’images pour technologie avancée

3.1 Architecture TTFS avec mécanisme d’inhibition: Time to first spike –Inhibition Mechanism: IM-TTFS

3.1.1 Le domaine temporel

3.1.2 Time to first spike et les problèmes associés

3.1.3 Mécanisme d’inhibition

3.2 Transmission de données lissée dans le temps et utilisation de bus multiples

3.2.1 Principe de fonctionnement

3.2.2 Réduction de donnée par voisin direct

3.2.3 Résultats de simulation

3.2.4 Architecture développée

3.2.5 Paramètres ajustables dans l’architecture et simulations MATLAB

3.3 Comparaison des deux architectures

3.4 Conclusion

4 Chapitre IV : Co-design acquisition et traitement

4.1 Descripteurs : principe et applications

4.1.1 Carte binaire

4.1.2 Histogramme des gradients orientés : HoG

4.2 Architecture

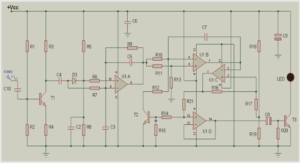

4.2.1 Pixel

4.2.2 Système d’inhibition

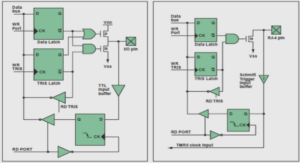

4.2.3 Système de lecture synchrone

4.2.4 Simulation Cadence et résultats

4.2.5 Discussions sur la consommation du système

4.3 Les apports de la solution

4.3.1 Par rapport à une solution non intégrée

4.3.2 Comparaison à l’état de l’art

4.4 Conclusion

Conclusion et perspectives

Références

A. Annexe 1 : Architecture IM-TTFS

Logigramme du pixel

Architecture du Handshake

Architecture de l’inhibition