Triangulation

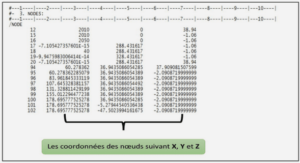

Cette technique est appelée triangulation puisque l’objet dont on veut mesurer la distance forme un triangle avec 2 parties du capteur. Si le capteur est constitué d’une partie réceptrice et d’une partie émettrice active (une source de lumière par exemple), le principe de mesure est appelé triangulation active. Si le capteur consiste seulement en l’utilisation de 2 récepteurs passifs, le principe est appelé triangulation passive. Ce dernier correspond en d’autres termes à la stéréoscopie, déjà expliquée auparavant (cf. 3.3.2 p. 41). Page | 52 Figure 16 : Principe de fonctionnement d’une triangulation passive (à gauche) et d’une triangulation active (à droite)

Triangulation passive

Elle repose sur le principe binoculaire de la vision humaine et se compose de 2 caméras qui observent une même zone de chevauchement (cf Figure 16 – gauche). Si un point p spécifique est dans le champ des deux récepteurs, il est possible de déterminer sa distance d par rapport au capteur. Par conséquent, chaque récepteur calcule l’angle entre la ligne formée par le centre du capteur et le point p et l’axe optique du récepteur. En combinant les angles avec la distance x entre les deux récepteurs, la distance au point p est calculée par : Équation 3 : Calcul de distance par triangulation passive Où α est l’angle que forme le récepteur A avec le point p et l’horizontale et β est l’angle que forme le récepteur B avec le point p et l’horizontale. Cette formule part du principe que les axes optiques des deux récepteurs sont parallèles. La partie la plus importante pour la triangulation passive est de trouver d’une part des points d’intérêts et d’autre part de trouver la correspondance dans les deux images à la fois pour pouvoir réaliser la triangulation. Chaque point de l’image du récepteur A doit être correctement identifié dans l’image du récepteur B. Si de mauvaises correspondances sont réalisées, cela conduit à des distances erronées (May et al., 2007). Comme nous l’avons expliqué précédemment, la stéréoscopie peut être réalisée en temps réel, cependant les cartes de distances obtenues ne sont pas très précises (peu de niveaux possibles) et la triangulation est très difficile si les images sont faiblement texturées ou comportent peu de points d’intérêts. De plus, la rectification des images, la recherche des points d’intérêt, la mise en correspondance entre ces deux images et le calcul de la triangulation est très gourmant en temps et en ressources.

Triangulation active

La Figure 16 (droite) représente la configuration d’un capteur utilisé pour la triangulation active. Une source lumineuse projette un point sur l’objet et la réflexion du point lumineux est mesurée par la partie réceptrice du capteur. Ce récepteur est un capteur qui peut déterminer l’endroit exact où la lumière réfléchie l’a frappé. En connaissant la position de la lentille du capteur, la distance entre l’émetteur et le récepteur x, leur distance à l’optique h et le point d’impact de la lumière réfléchie x’, il est possible de calculer la distance d de l’objet par la formule (May et al., 2007) : Équation 4 : Calcul de distance par triangulation active Une configuration comme celle-ci avec un capteur aussi simple ne permet de mesurer la distance que d’un seul point. Pour déterminer la forme d’un objet, il est alors nécessaire de prendre plusieurs mesures et de faire tourner soit l’objet soit le dispositif autour de celui-ci. Des systèmes de triangulation plus sophistiqués utilisent des sources de lumière ainsi que des récepteurs, tous deux, à 2 dimensions. Ils projettent un motif lumineux sur l’objet qui est reçu par un capteur de caméra 2D par exemple. Un tel système fournit directement des informations de la forme 3D des objets mesurés. On appelle ça des systèmes à lumière structurée. Un système à lumière structurée peut être de n’importe quelle forme du moment que le motif projeté est connu. Dans de nombreux cas, des successions de lignes noires et blanches dans le spectre visible sont utilisées. La déformation des lignes permet de connaître la forme de l’objet et d’en déduire les distances pour chaque pixel. Cependant, même si les résultats sont très bons et que la forme peut être obtenue en temps réel (Zhang et al., 2006), la projection d’un motif sur la personne peut être gênant en particulier si la source de lumière est dirigée vers les yeux. L’inconvénient majeur de l’utilisation de ces lignes noires et blanches est qu’il est nécessaire d’avoir un projecteur puissant et la plupart du temps le système fonctionne dans le noir et non en plein jour. Pour remédier à ce problème, il est possible de projeter sur la personne un motif infrarouge (Guan et al., 2007). Cette méthode est justement utilisée dans la caméra 3D développée par la société PrimeSence (Freedman et al., 2010) ou encore dans la Kinect de Microsoft sortie en novembre 2010 (qui utilise la technologie PrimeSense). Une matrice de points infrarouges (dont la répartition est connue) est projetée sur la scène et le capteur récupère une image dans laquelle tous les points apparaissent (grâce à un filtre qui ne laisse passer que l’infrarouge). Puisque les objets dans la scène déforment la matrice de référence et que cette matrice est connue par la Kinect, les décalages de position de chaque point permettent de déduire, par triangulation, la distance qui les sépare de la Kinect. Celle-ci permet d’obtenir des informations de distance à peu près aussi précises que les caméras 3D à temps de vol pulsé ou à décalage de phase. De plus la résolution du capteur de profondeur utilisé dans la Kinect (640×480) est très supérieure à celles de ces caméras et le taux de rafraîchissement est de 30 fps, ce qui rend ce périphérique très intéressant pour réaliser de la capture de mouvements des mains en temps réel.