Considérations architecturales pour l’autoréparation

Bien que l’un des objectifs principal dans la réalisation de tout système informatique ai toujours été l’automatisation de celui-ci, force est de constater qu’aujourd’hui la situation est telle qu’il est urgent de passer à la vitesse supérieur. En effet, l’évolution fulgurante des systèmes informatiques et des systèmes de télécommunications lors de ces vingt dernières années a abouti à des systèmes tellement complexes que leur gestion est devenue un vrai cauchemar. Pour remédier à ce problème, le concept de système autonome, se gérant soi-même, est maintenant exploré par une partie de la communauté de recherche depuis une dizaine d’années [Hor01]. Les réseaux de télécommunications, en bien des points similaires aux systèmes informatiques, envisagent aussi une gestion autonome, afin notamment, de réduire les coûts de gestion en constante progression. Dans cet objectif de gestion autonome des réseaux, la gestion des pannes, où chaque secondeest comptée, n’échappe pas à la règle, puisque l’efficacité et la rapidité des actions que pourrait entreprendre un système autonome permettraient des performances bien meilleures que ce que pourrait entreprendre un opérateur humain.

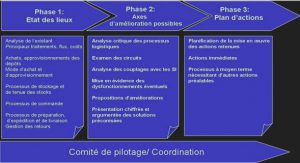

Dans cette optique, la définition d’une architecture fonctionnelle, incluant la gestion des pannes est un prérequis indispensable, afin de fédérer, et donner une certaine cohérence aux multiples fonctions autonomes qui pourraient être introduitesLa vue d’ensemble des réseaux de télécommunications ressemble à un agglomérat complexe où des réseaux multicouches et multi-technologies sont interconnectés ensembles. La complexité des réseaux de télécommunications est une réalité mais certainement pas un avantage, obligeant les fournisseurs de réseaux à dépenser beaucoup d’énergie dans le seul but de maîtriser les coûts opérationnels dûs à la gestion de leur réseau. Le problème général de la complexité des réseaux ne cesse de croitre, à cause notamment, de leur hétérogénéité, de la nature incrémentale des tech- nologies en jeu, avec l’entassement de couches multiples et de l’interconnexion de dizaines de protocoles différents.

Bien que le modèle multicouche soit à l’origine du fondement de l’Internet, l’hétérogénéité des technologies impliquées aboutie sur de nombreux problèmes de compatibilité et d’interconnexion. Ceci est illustré par le nombre de protocoles qui régissent l’Internet avec notamment plus de 6000 IETFLa taille est aussi un élément critique, puisqu’avec de plus en plus d’utilisateurs connectés, la taille des réseaux explose, complexifiant encore plus la donne, au point de dépasser la capacité de gestion humaine. Malheureusement, la gestion actuelle centralisée, telle que celle définie par l’architecture TMN [TMN96], qui centralise toutes les fonctionnalités de gestion au sein du Net- work Management System (NMS), accentue les difficultés, car dans un environnement, toujours plus partitionné composé de différents niveaux tels que les domaines, les aires, les systèmes au- tonomes, une gestion globale cohérente est devenue impossible. Le risque est donc de perpétuer un système de gestion, plus que complexe et sous-optimal.nécessitent des traitements spécifiques de gestion de qualité deservice, mais il est de plus en plus difficile, au sein des éléments de réseaux, de différencier ces trafics et de déterminer la manière de les gérer.

Quand la complexité de la gestion du trafic, des différentes technologies, et les problèmes de taille des réseaux s’additionnent, la gestion deLa gestion de réseau est aujourd’hui opérée par des opérateurs humains, qui, bien qu’extrê- mement qualifiés, sont bien plus lents, coûteux et sujets aux erreurs que ne pourrait l’être une machine. Une étude intéressante [Sur02] relevait en 2002 que 62% du temps d’arrêt des réseaux d’entreprise résultait d’erreurs humaines. De plus, le temps de réaction peut être un facteur cri- tique dans la gestion de réseau, tout particulièrement lorsqu’un évènement inattendu survient, tel qu’une panne, car un délai de réaction trop lent peut annihiler le bénéfice des actions de correction, voire même les rendre contre-productives. Il ne fait aucun doute que la gestion de réseau devient trop complexe pour être effectuée efficacement par des opérateurs humains et né- cessiterait une gestion automatique, qui serait largement distribuée, plus sûre, plus réactive, et donc plus efficace. Parallèlement, le déploiement de nouveaux services nécessite aujourd’hui une flexibilité et une rapidité bien plus importante, mettant en exergue le problème de la complexité comme un frein à l’évolution de l’infrastructure réseau et des services associés. De plus, la com- plexité augmentant, les besoins d’expertise augmentent aussi, entrainant un accroissement des coûts d’OPEX et une grande difficulté pour trouver du personnel possédant le niveau d’expertise demandé.