La détection des gerbes atmosphériques

En 1938, le français Pierre Auger étudie les rayonscosmiques à l’aide de compteurs Geiger.

Ce détecteur, imaginé par Geiger en 1913 et construit par le même en 1923, est une évolution de la chambre d’ionisation fonctionnant sous régime de saturation : il est sensible à toute particule ionisante, mais il ne donne aucune information lié à l’énergie ou à la nature de la particule.

Auger travaille donc avec des compteurs Geiger en coïncidence avec comme objectif d’améliorer la résolution temporelle des détecteurs afin de réduire le taux d’évènements fortuits, dus notamment à la radioactivité du sol. Malgré ses efforts pour réduire le taux de coïncidences, il observe toujours un taux de fortuits supérieur à celui normalement attendu. Installant alors un compteur Geiger à 200 mètres deson laboratoire, Auger met en évidence des coïncidences entre ses deux détecteurs, prouvant que les particules arrivent simultanément. Il vient de découvrir le phénomène de gerbe atmosphérique (10) similaire aux cascades de particules déjà observé dans la matière, notamment par Bethe dès 1934.

Principe

Quand un rayon cosmique, que l’on appellera particule primaire, atteint l’atmosphère terrestre, elle interagit avec le milieu en créant une cascade de particules secondaires. La collision entre les noyaux des molécules d’air de l’atmosphère et la particule primaire crée de nombreux éléments, répartissant ainsi l’énergie initiale du rayon cosmiques entre des fragments de noyaux, des pions et des kaons (11). Ces éléments, lors de leur propagation dans l’atmosphère, vont à leur tour interagir dans l’atmosphère et créer la cascade de particules secondaires, formé de plusieurs composantes.

Détection par fluorescence

Une seconde technique de détection de gerbes atmosphériques fut développée vers la fin des années 1970. Cette technique repose sur la détection de la lumière UV émise par la désexcitation des molécules d’azote de l’atmosphère ionisées par le passage du front de particules.

Les télescopes de fluorescence sont constitués d’un miroir qui renvoie la lumière UV induite par le passage d’une gerbe cosmique vers des caméras œil-de-mouche réalisé en juxtaposant un grand nombre de photomultiplicateurs. La lumière enregistrée est une représentation du développement de la gerbe à travers l’atmosphère, c’est-à-dire à son profil longitudinal (Figure 12). Les télescopes de fluorescence ne sont sensibles qu’à la composante électronique de la gerbe.

Par la suite, l’expérience Fly’s Eye en 1981, puis son amélioration HiRes (High Resolution Fly’s Eye) en 1997 prouvèrent définitivement l’intérêt de l’utilisation des télescopes de fluorescence dans la détection des gerbes atmosphériques en réalisant, comme AGASA, des mesures permettant de connaître le spectre des rayons cosmiques à ultra-haute énergie. Comme nous le verrons par la suite, les spectres obtenus par AGASA et HiRes sont incompatibles, le premier n’observant pas la chute du flux au-delà de ~5.10 19eV mesurée par le second. Cette contradiction, connue sous le nom de paradoxe GZK, n’a pu être levée que par l’utilisation d’un nouveau type de détecteur combinant les deux méthodes : le détecteur hybride.

Astronomie et particules cosmiques

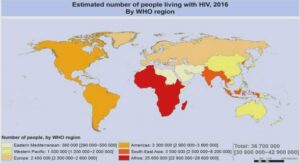

Comme nous le verrons par la suite, la détermination des sources des particules chargées du rayonnement cosmique n’est possible que pour des énergies extrêmes où la trajectoire de la particule n’est que très peu influencée par les champs magnétiques galactiques et extragalactiques. Pour des énergies plus faibles, la particule va subir des déviations successives durant son parcours jusqu’à la Terre, rendant impossible la détermination de son point d’émission d’origine. Le flux de particules d’ultra-haute énergie étant extrêmement faible, ce domaine de physique semble n’avoir que peu d’intérêt, pour le moment, dans le cadre de l’astronomie, bien que l’Observatoire Auger soit aujourd’hui capable d’identifier des candidats sources dans cette gamme d’énergie. Mais d’autres particules cosmiques, comme les photons et les neutrinos émis par des sources stellaires, sont insensibles aux champs magnétiques et leurs directions d’arrivée pointent directement vers leurs sources.

Dans le cas des photons, la méthode de détection diffère en fonction de leurs gammes de fréquence. Outre le domaine optique pour lequel la détection se fait aujourd’hui aisément à l’aide de télescopes optiques, science dont l’origine remonte à plus de deux millénaires, nous allons nous intéresser à deux autres domaines pour lesquels les techniques de détection sont relativement récentes et s’intègrent parfaitement dans le cadre de cette thèse: le domaine radio et le domaine gamma. La détection de photons dans d’autres domaines de fréquence, comme l’astronomie X par exemple, est bien évidemment possible.

L’étude des photons cosmiques dans le domaine radio, ou radioastronomie, existe depuis les années 1930, quand Jansky détecte le premier signalradio extra-terrestre. Ce n’est qu’après la Seconde Guerre Mondiale, en recyclant le matériel militaire comme les radars, que la radioastronomie prit réellement son essor. Ses découvertes les plus marquantes sont la détection de la raie 21 cm de l’hydrogène en 1951, la première mesure (accidentelle !) du fond cosmologique diffus à 3 K° et l’identification du premier pulsar en 1967. L’étude des sources radio dans l’Univers nécessite des instruments de taille de plus en plus grande pour améliorer la précision de la détection, comme le radiotélescope d’Arecibo (Porto Rico) d’un diamètre de 305 mètres, ou, en France, le radiotélescope de Nançay (Figure 16).

Les résultats actuels

Composition

Pour des énergies inférieures à 10 eV, où la détection des rayons cosmiques de manière directe par ballons ou satellites est possible, l’identification de la nature des particules est relativement aisée. On estime aujourd’hui la composition du flux de rayons cosmiques à 90% de protons et 10% de noyaux allant de l’hélium jusqu’au fer.

Pour des énergies supérieures à 10 eV, la particule primaire n’est plus détectable directement, seule la gerbe de particules résultantde son interaction avec l’atmosphère peut être mesurée. En théorie, la nature du rayon cosmique peut être déduite des caractéristiques physiques de la gerbe, et principalement par la position du maximum de développement de la gerbe X max, un proton interagissant plus loin dans l’atmosphère qu’une particule plus lourde.

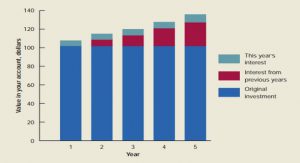

Toutefois, l’estimation de la position du Xmaxrepose sur l’utilisation de modèles soumis aux fluctuations gerbes à gerbes et nécessitant une grande statistique. La position du X maxet donc la nature de la particule primaire n’est donc pas utilisable évènement par évènement. On définit alors le taux d’élongation, soit la position moyenne du X max en fonction de l’énergie.

En comparant le taux d’élongation obtenu expérimentalement avec celui prévu par des simulations de gerbes à haute énergie pour un flux de particules primaires composé uniquement de protons et de fer, la composition globale du flux de rayons cosmiques peut être estimée.

Le domaine d’énergie compris entre 10 eV et 10 eV est activement étudié par l’expérience de détection au sol KASCADE-GRANDE. Essentiellement composé de protons à 10 eV, la composition du rayonnement cosmique s’alourdit progressivement à mesure que les particules les plus légères atteignent l’énergie nécessaire pour échapper au confinement magnétique galactique. Ce phénomène explique l’existence, dansle flux de rayons cosmiques, du genou, composé en fait de plusieurs genoux successifs correspondant à la fuite galactique de particules de masse croissante. L’existence d’un second genou correspondant à la fuite du fer est activement recherchée.

Dans le domaine des ultra hautes énergies, les résultats obtenus par l’expérience HiRes, présentés Figure 24, semblent montre un allègement progressif de la composition du rayonnement cosmique jusqu’à une énergie de l’ordrede 10 eV. L’existence, dans le spectre des rayons cosmiques, de la cheville étant interprétée comme une transition entre des particules galactiques et extragalactiques, cet allégement de la composition est effectivement attendu. Au-delà de 10 eV, le taux d’élongation mesuré par HiRes est compatible avec un flux de rayons cosmiques principalement composé de protons (27).

Intérêt de la radiodétection

Nous avons vu dans le Chapitre 1 comment la détection de gerbes atmosphériques, grâce à des techniques telles que les réseaux au sol de détecteurs de particules ou par les télescopes à fluorescence, permettait d’étudier les rayons cosmiques, et tout particulièrement dans le domaine des ultra-hautes énergies. Nous venons de voir dans ce Chapitre 2 qu’une gerbe atmosphérique peut aussi être détectée et étudiée grâce au champ électrique créée au cours de son développement. Une question se pose alors : quelles sont les avantages de la radiodétection sur les techniques de détection usuelles ?

Une sensibilité au développement de la gerbe

Les réseaux de surface de détecteurs de particules ne sont sensibles qu’à la galette de particules atteignant le sol : les caractéristiques de la gerbe sont alors obtenues à l’aide de simulations soumises à de grandes incertitudes, notamment en raison des fluctuations statistiques gerbe à gerbe. Par contre, le champ électrique induit par une gerbe atmosphérique est le reflet de la contribution de toutes les particules chargées (principalement les électrons et les positrons) créées pendant l’intégralité du développement de la cascade.

Tout comme la technique de fluorescence, la radiodétection permet à priori d’étudier une gerbe atmosphérique, c’est-à-dire notamment de connaître l’énergie du primaire ou la position du maximum de développement de la gerbe X max, sans avoir recours à une extrapolation quelquonque. Théoriquement, l’information sur le développement de la gerbe est contenue dans la forme du signal tandis que l’énergie du primaire est corrélée avec le maximum de l’impulsion mesurée.

Un cycle utile proche de 100%

De plus, contrairement cette fois à la technique de fluorescence qui ne fonctionne que pour les nuits sans nuages et sans lune, soit un cycle utilede ~10%, la détection d’un signal radio est par définition complètement indépendante des conditions de luminosité. La radiodétection va par contre être sensible à plusieurs autres phénomènes :

Des augmentations du bruit de fond radio dues à des phénomènes météorologiques (orages) voir à des phénomènes cosmiques (éruption solaire…) peuvent rendre la radiodétection temporairement délicate

Des phénomènes temporaires comme le passage d’avions ou la présence d’appareillage capable d’émettre des impulsions rapides peuvent périodiquement augmenter le taux d’évènements fortuits détectés par une expérience de radiodétection.

L’utilisation d’un trigger particules permet de trier efficacement les évènements, mais dans le cadre d’un réseau d’antennes autonome, une recherche et une élimination de ces fortuites devra être effectuée

Malgré ces dernières contraintes, on peut considérer que le cycle utile de la radiodétection est proche de 100%.

La radiodétection est donc en théorie la fusion desavantages des deux techniques de détection usuelle des gerbes atmosphériques, à savoir le cycle utile de 100% des réseaux de surface et la sensibilité à l’intégralité du développement de la gerbe de la technique de fluorescence. De plus, le détecteur en lui-même, une antenne, est un objet relativement simple et de taille réduite : le déploiement d’un réseau géant d’antennes, ainsi que l’entretien, devrait donc être relativement peu contraignant et coûteux. Pour ces raisons, la radiodétection est potentiellement une technique capable de rivaliser avec ses deux « aînées ». Bien que l’idée et les premières tentatives de détection du champ électrique induit par une gerbe atmosphérique datent des années 1960, l’étude de la radiodétection avec des statistiques suffisantes n’a réellement commencée que depuis les années 2000. Nous allons donc nous intéresser maintenant à une des principales expériences de radiodétection au monde : l’expérience CODALEMA.

L’expérience CODALEMA

Fonctionnement général

La détection d’un signal radio induit par le passage d’une gerbe atmosphérique a été effectuée pour la première fois dans les années 70. Malheureusement, les moyens techniques de l’époque n’étaient pas adaptés aux caractéristiques de l’impulsion recherchée. En effet, sa durée (de l’ordre de la centaine de nanosecondes) nécessite, pour une détection optimale, une électronique rapide qui n’était pas disponible à l’époque. Devant les performances des réseaux de détecteurs de particules et l’émergence des techniques de détection par fluorescence, la radiodétection fut ainsi laissée dans l’oubli.

Aujourd’hui, les performances des moyens techniquesmis à notre disposition, principalement une électronique rapide permettant d’échantillonnerdes signaux à la fréquence de plusieurs centaines de MHz, donnent la possibilité à la radiodétection de devenir une technique efficace de détection et d’étude des gerbes atmosphériques. C’est ainsi qu’en 2003, la reprise de travaux théoriques sur le sujet par Gohram (46), ainsi que le déploiement de deux expériences de radiodétection, LOPES en Allemagne et CODALEMA en France, relance l’intérêt de la communauté des astroparticules pour la radiodétection. L’objectif premier était de tester la faisabilité et l’efficacité d’un réseau d’antennes dans l’étude des rayons cosmiques, puis d’étudier les possibilités offertes par cette technique complémentaire de celles actuellement utilisées.

Après avoir expliqué le principe général de l’expérience CODALEMA, le premier setup expérimental utilisé sera rapidement présenté, ainsi que les résultats obtenus (voir thèse d’Arnaud Belletoile). La nouvelle configuration, comprenant un changement complet, que ce soit du type d’antennes, de trigger ou d’acquisition, sera ensuite détaillée et discutée.

Principes fondateurs

Comme expliqué dans le chapitre 2, une gerbe atmosphérique créée par une particule cosmique primaire induit un champ électrique détectable par des antennes sous la forme d’une impulsion rapide (de l’ordre de quelques centaines de nanosecondes) et de faible amplitude (de l’ordre de quelques millivolts par mètre). La composante fréquentielle de cette impulsion dépend principalement de la distance entre l’axe de la gerbe et la position du détecteur. Globalement, on peut considérer que la majorité du signal est comprise dans la bande de fréquence 1-100 MHz. Dans le concept général d’une expérience de radiodétection, il est nécessaire de trouver un équilibre entre les objectifs physiques et les contraintes expérimentales. Ainsi, pour reconstruire de façon optimale la forme de l’impulsion électrique induite, il faut obligatoirement utiliser la plus grande bande passante possible, tout en s’assurant que l’amplitude de l’impulsion sera détectable. Cela suppose de se placer dans un environnement radio calme et peu bruité, conditions extrêmement difficiles à obtenir en général, et tout particulièrement dans nos régions où l’on peut trouver toutes sortes d’émetteurs.

Deux postulats de base ont ainsi conditionnés la phase initiale de développement de l’expérience CODALEMA :

Utilisation d’une antenne à large bande passante capable de détecter des signaux électriques de faible amplitude

Installation de l’expérience dans un lieu où la bande de fréquence 1-100MHZ est la plus propre possible, c’est-à-dire avec une présence réduite d’émetteurs parasites

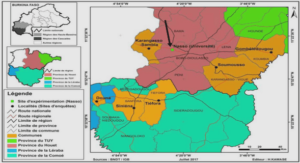

On peut noter que l’expérience de radiodétection LOPES a été conçue sur des postulats radicalement différents. En effet, LOPES a été installé sur le site de l’expérience de détection au sol KASCADE-GRANDE, profitant ainsi du réseau desurface pour obtenir un trigger très efficace et une statistique, comme nous le verrons, supérieure à celle de l’expérience CODALEMA. Toutefois, ce choix n’est pas sans conséquence puisque les conditions de bruit radio sur le site de Karlsrühe sont très mauvaises. Les antennes utilisées, ainsi que les techniques de traitement du signal, sont logiquement très différentes de celles de l’expérience CODALEMA. Nous reviendrons sur ce point dans le Chapitre 6.

Table des matières

Introduction

Chapitre 1 – Les rayons cosmiques

I. Historique des rayons cosmiques

1. La découverte

a. Caractérisation du rayonnement cosmique

b. Naissance de la physique des particules

2. La détection des gerbes atmosphériques

a. Principe

b. Détection par réseau de surface

c. Détection par fluorescence

d. Détecteurs hybrides

e. Astronomie et particules cosmiques

II. Etat des lieux des connaissances

1. Le spectre des rayons cosmiques

a. Le genou

b. La cheville

2. La coupure GZK

3. Les résultats actuels

a. Composition

b. Sources potentielles

Chapitre 2 – Principes théoriques de la radiodétection

I. Les premiers pas de la radiodétection

II. Modèles théoriques actuels

1. Modèle microscopique

2. Modèle macroscopique

III. Applications expérimentales

1. Caractéristiques du signal attendu

2. Intérêt de la radiodétection

Chapitre 3 – L’expérience CODALEMA

I. Fonctionnement général

1. Principes fondateurs

2. Localisation

II. Configuration originale de l’expérience CODALEMA

1. Description du setup

a. Antennes log-périodiques

b. Trigger scintillateurs LAL

c. Acquisition

2. Résultats obtenus et conclusions

a. Estimation du seuil radio en énergie

b. Premiers profils latéraux de distribution du champ électrique

c. Répercussions sur l’évolution de l’expérience CODALEMA

III. Nouvelle configuration de l’expérience CODALEMA

1. Le détecteur radio : antenne dipôle active

a. Contraintes sur le développement de la nouvelle antenne

b. Fonctionnement et caractéristiques intrinsèques

i. Dimensionnement de l’antenne

ii. Gain et directivité

iii. Réponse en fréquence de l’antenne

iv. Caractéristiques de l’amplificateur

c. Sensibilité au bruit galactique

2. Trigger particule : le réseau de scintillateurs

a. Fonctionnement et caractéristiques

b. Estimation de l’énergie de la particule primaire

3. Acquisition

4. Configurations de l’expérience CODALEMA

a. Phase hybride

b. Configuration actuelle

IV. Traitement des données brutes

a. Correction de l’atténuation du signal dans les câbles et filtrage numérique en fréquence

i. Correction de l’atténuation du signal

ii. Filtrage numérique en fréquence

b. Recherche et marquage des impulsions

i. Méthode par seuil

ii. Méthode LPC

c. Reconstruction de la direction d’arrivée de l’onde radio

d. Sélection des candidats radio correspondant à une gerbe atmosphérique

Chapitre 4 – Analyse des données

I. Echantillon statistique

II. Energie des rayons cosmiques

a. Distribution en énergie

b. Efficacité de détection

III. Distributions angulaires

a. Données du réseau de scintillateurs

b. Données du réseau d’antennes

i. Distribution en angle zénithal

ii. Distribution en angle azimutal

iii. Comparaison avec les antennes log-périodiques

Chapitre 5- Résultats

I. Asymétrie Nord-Sud

1. Signature d’un effet géomagnétique

2. Modèle géomagnétique simplifié

3. Comparaison avec les résultats expérimentaux

II. Distribution latérale du champ électrique induit

1. Elaboration des profils de champ induit

a. Calcul de la distance à l’axe de la gerbe

b. Calcul du champ électrique mesuré

c. Ajustement du profil

2. Analyse des distributions latérales de champ électrique induit

a. Comportement observé de la décroissance des profilslongitudinaux

i. Erreur de l’ajustement sur le paramètre d0

ii. Profils avec une décroissance d0 « finie »

iii. Profils avec une décroissance d0 « infinie »

b. Conséquences sur la caractérisation de l’observableradio sur l’énergie du primaire

III. Relations entre le champ électrique induit et l’énergie du rayon cosmique primaire

1. Corrélation en énergie

a. Corrélation pour l’ensemble des évènements

b. Corrélation pour les évènements avec un profil longitudinal correctement estimé

c. Corrélation pour l’ensemble des évènements en utilisant l’observable E moy

2. Extrapolations

a. Estimation de l’énergie des évènements externes parla radio

b. Extension du champ électrique à ultra-haute énergie

CONCLUSION