Fouille de données textuelles

Généralités sur l’exploration de données

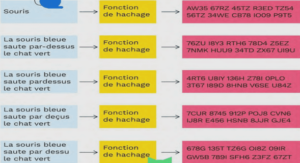

L’exploration (ou fouille) de données englobe un ensemble de techniques ayant pour objectif d’analyser de grands volumes de données [Han et Kamber, 2005]. Ces techniques ont pris leur essor avec la disponibilité croissante de données dans divers domaines d’application. Dès lors que l’automatisation de la collecte des données (capteurs, codes-barres, reconnaissance automatique de textes, généralisation des dispositifs de saisie) a donné lieu à la constitution de grandes bases de données de diverses natures, lorsqu’il s’agit d’analyser ces données, il devient évidemment très coûteux de les examiner une à une, manuellement. Une tâche d’analyse peut suivre un ojectif précis, lorsque l’on sait quel objet d’étude l’on souhaite modéliser et prédire. Dans d’autres cas, il s’agit de décrire exhaustivement, sans a priori, des corrélations, des associations, de manière plus générale de faire émerger des connaissances à partir des données. Ces besoins ont rendu pertinent la mise au point des méthodes objectives qui permettent d’explorer les données, afin d’en extraire des connaissances, dans des délais raisonnables et selon des critères liés à l’intérêt que, potentiellement, ces connaissances peuvent présenter. La fouille de données propose un ensemble de méthodes qui analysent systématiquement les données et vise à extraire, à partir de faits, un modèle de connaissances (par exemple par généralisation), des motifs (en anglais patterns), qui deviendront exploitables par l’humain ou par un système de plus haut niveau. De notre point de vue, nous considérons que la problématique peut-être interprétée comme une réorganisation des données, qui met de côté les informations non-pertinentes (bruit) et utilise les données pertinentes pour construire des structures appropriées (motifs). De manière générale, même s’il n’y a pas réellement consensus sur le sujet, les processus d’exploration des données tiennent compte des éléments suivants : – Alphabet des items : symboles atomiques pour représenter les données. – Base de données : données numérisées et stockées, sous-ensemble du langage des items, généralement segmentées sous forme de multi-ensemble, les transactions. – Alphabet des motifs : symboles atomiques pour représenter les motifs (il peut avoir une intersection avec l’alphabet des données). – Motifs : algèbre formée par le langage des motifs muni d’opérateurs (dont généralement une relation d’ordre et pour des motifs séquentiels la concaténation). – Mesures : opérateurs permettant de quantifier les motifs au regard des données (en particulier, mesures d’intérêt). La fouille de données a été appliquée à la recherche de solutions pour de nombreuses problématiques. Ces méthodes ont prouvé leur efficacité dans des domaines très divers comme par exemple l’achat en librairies [Srikant et Agrawal, 1996], l’analyse de séquences ADN [Zhu et al., 2007], l’analyse de logs web [Wang et Han, 2004] ou encore le traitement du langage. Nous nous focalisons sur ce dernier domaine d’application, dans le cadre de l’élaboration des ressources à utiliser pour la reconnaissance d’entités nommées, dont les lexiques et les transducteurs.

Fouille de documents textuels pour enrichir les lexiques

Les premières utilisation de méthodes de fouille de données pour améliorer la reconnaissance des entités nommées a essentiellement porté sur l’enrichissement de lexiques. Les premières tentatives en ce sens ne disposaient pas de ressources externes structurées (Web, Wikipedia) et ne pouvaient exploiter que des bases de documents purement textuelles. La problématique était alors d’y détecter des noms propres afin de les ajouter à des lexiques. Ceci a été expérimenté par utilisation d’algorithmes itératifs (bootstrapping) qui extraient alternativement des noms propres et les motifs contextuels corrélés à ces noms propres [Riloff et Jones, 1999,Dredze et al., 2010]. Un tel système est initialisé avec des noms propres courants de la classe à extraire. Puis un algorithme détermine les contextes qui discriminent ces noms propres dans les textes. Ces contextes permettent alors de détecter de nouveaux noms propres, qui sont à leur tour utilisés pour extraire de nouveaux contextes, etc. Ainsi, le lexique est enrichi itérativement. Cette approche, faiblement supervisée, est difficile à contrôler (problème de dérive sémantique, en anglais semantic drift) : la couverture et la qualité des lexiques obtenus dépend fortement des paramètres (noms propres initiaux, critères d’arrêt). D’autre approches se sont popularisées, qui s’appuient sur le Web comme une vaste ressource afin d’en extraire des noms propres [Etzioni et al., 2005, Nadeau, 2007, Mooney et Bunescu, 2005,Béchet et Roche, 2010,Roche, 2010,Downey et al., 2007]. Ces méthodes utilisent généralement les moteurs de recherche qui, par indexation des données, fournissent un matériau partiellement filtré. Le système interroge l’index, parfois à l’aide de patrons sémantiques simples (par exemple, le motif ‘ »la ville de »’, avec guillemets, est supposé être suivi de noms de villes dans les documents), et récupèrent les pages retournées par le moteur pour y détecter le ou les items lexicaux d’intérêt. Une analogie est parfois faite avec un écosystème biologique [Etzioni et al., 2005], dans lequel des systèmes dits herbivores traitent la donnée brute (moteurs de recherche) et d’autres systèmes, dits carnivores, manipulent cette donnée déjà partiellement analysée (utilisation de motifs). Ces systèmes exploitent à la fois les volumes de données disponibles (ce qui justifie une approche de type fouille), des patrons sémantiques (pour interroger les moteurs), mais également, de plus en plus, les listes structurées accessibles sur le Web (tableaux, listes, énumérations, liens, etc.). Faiblement supervisées, ils fournissent des résultats très satisfaisants. Dans cette méthode, la fouille apparaît cependant réalisée en grande partie par le moteur de recherche : la marge de progression est alors fortement dépendante du moteur utilisé et de la forme des motifs qu’il autorise (il est rare que les requêtes puissent formuler des requêtes s’appuyant sur la morpho-syntaxe, la sémantique, etc.). Par le volume de données disponible sur le Web, Ces approches parviennent à exploiter avantageusement une connaissance, in fine, saisie par l’humain (les pages Web partiellement structurées). Dans la même ordre d’idées, les encyclopédies en ligne (Wikipedia) sont aujourd’hui devenus une source incontournable d’information qu’il est également possible de fouiller. En effet, elles présentent trois caractéristiques qui les rendent très intéressantes à cet effet. Premièrement, elles couvrent aujourd’hui assez exhaustivement de vastes domaines de connaissances, et sont de surcroît très régulièrement mises à jour. En second lieu, elles sont fortement structurées (au sein des pages autant que par liens qualifiés entre pages), ce qui permet d’explorer ces ressources en profondeur. Enfin, elles ont l’avantage d’être validées par un grand nombre d’utilisateurs, donc de résulter en partie de consensus. Ces encyclopédies sont l’objet de nombreux travaux, pour construire des ontologies mais aussi pour en extraire des entrées lexicales ou des contextes discriminants pour les homonymes [Bunescu et Pasca, 2006,Charton et Torres-Moreno, 2009,Charton, 2009]. Nous disposons déjà de ressources lexicales assez couvrantes, constituées semi-automatiquement, que nous décrivons en section 7.2.2. Si nous n’abordons pas dans ce travail les problématiques d’enrichissement de ces ressources, nous présenterons quelques résultats visant à déterminer leur influence pour la reconnaissance des entités nommées. Signalons dès à présent que nous établirons une distinction nette entre la catégorisation sémantique à l’aide de ressources lexicales et l’utilisation de ces catégories sémantiques au sein de motifs. Il nous paraît en effet que les motifs n’ont pas vocation a remplacer les lexiques, mais à s’appuyer sur eux afin de faire abstraction des items lexicaux eux-même.

Extraction automatique de motifs linguistiques

Si la fouille de données s’abstrait de l’automate pour considérer les données, rien ne l’empêche cependant d’explorer les données afin d’y découvrir des structures apparentées à des automates [Hingston, 2002]. Nous retrouvons ici la vue faite en section 1.3 des transducteurs comme ressources : il est possible, en fouillant les données, d’en extraire des automates, des grammaires et peut-être, ce sera notre hypothèse, des motifs corrélés aux instructions sous-jacentes au langage. Cette tâche est nommée induction : elle consiste à extraire des connaissances sous forme d’automates à partir de données observées. De nombreux travaux ont été réalisés sur l’induction de grammaires qui décrivent (génèrent, reconnaissent) le langage naturel [Parekh et Honavar, 2000,Mendes et Antunes, 2009]. Cependant, les travaux ne permettent pas véritablement, à ce jour, de circonscrire précisément une forme de motifs plus appropriée pour traiter tout le langage naturel et uniquement le langage naturel. Cet objectif ambitieux a donc laissé place à l’extraction de motifs pour des phénomènes linguistiques particuliers et pour des tâches spécifiques [Besançon et al., 2006,Sun et Grishman, 2010,Ezzat, 2010,Charton et al., 2011]. Les motifs sont généralement formulés à l’aide de ressources que l’on suppose être utiles à la problématique considérée. La forme des motifs peut être assez variable et s’appuyer sur des formalismes très divers : logiques, séquentiels, hiérarchiques, relationnels, etc. Pour le langage naturel, la nécessité de tenir compte de la séquentialité des données est souvent incontournable (concaténation de phonèmes, mots, énoncés, prises de paroles, etc.). C’est donc un sous-domaine de la fouille de données auquel il sera fait appel, qui doit examiner des séquences plutôt que des ensembles, ce qui augmente par ailleurs la combinatoire des motifs à considérer. Certains travaux ont exploré la possibilité d’assouplir partiellement cette contrainte lorsqu’il s’agit de prendre en compte un contexte plus large autours des éléments à reconnaître [Plantevit et al., 2009,Cellier et Charnois, 2010,Charnois et al., 2009]. Pour notre problématique, nous postulons que le contexte à prendre en compte est essentiellement local et requérons que tous les éléments d’un motif soient contigus. Concernant la problématique spécifique des entités nommées, des travaux ont été menés afin d’extraire des motifs se focalisant sur ces objets linguistiques [Kushmerick et al., 1997, Califf et Mooney, 1999, Freitag et Kushmerick, 2000, Girault, 2008]. Généralement, ces approches supervisées extraient, à partir d’un corpus annoté, des motifs généralisant les contextes dans lesquels apparaissent les entités nommées. Ces motifs peuvent être généralisés à l’aide d’indices morphologiques simples exprimés sous forme d’automates. A notre connaissance, ces méthodes se focalisent sur l’extraction de motifs, et non sur leur utilisation automatique pour réaliser la reconnaissance des entités nommées. Ces motifs sont donc supposés déterministes : ceci amène souvent à privilégier des motifs précis et à écarter les motifs qui ne fournissent que des indices partiels. De plus, l’approche que nous avons développée [Nouvel et al., 2010b,Nouvel et Soulet, 2011,Nouvel et al., 2011a] est à notre connaissance la seule à réaliser la fouille de données qui se focalise sur les marqueurs d’annotation. Comme indiqué en section 1, nous nous situons dans une approche qui s’attache à considérer les annotations, et plus particulièrement les marqueurs (balises) qui forment l’annotation (c.f. 3.3). Comme nous le verrons, le cadre théorique que propose la fouille de données est approprié pour décomposer la problématique de reconnaissance des entités nommées comme recherche de motifs qui insèrent des marqueurs dans les textes. Par ailleurs, nous ne nous contraignons pas à extraire des connaissances exactes : de simples indices, même lorsqu’ils apportent une information partielle, peuvent être d’intérêt. De ce fait, l’ambiguïté naturellement présente dans les ressources (pour grande partie, dans les lexiques) peut-être conservée jusqu’à l’extraction des motifs. La résolution des cas ambigus sera reportée en fin de processus, lorsqu’il s’agira d’utiliser ces motifs pour reconnaître les entités nommées.