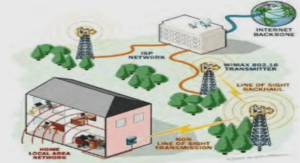

Se préparer au multimédia

Les flux multimédias

L’objectif de ce court chapitre est de présenter les caractéristiques des flux multimédias (essentiellement la voix et la vidéo), afin de montrer comment leurs particularités influent sur un réseau de paquet tel que TCP/IP. Vous découvrirez ainsi : • comment sont transportés le son et l’image sous forme numérique ; • ce qu’est un codec ; • les problèmes posés par les délais de transit et la gigue ; • quels débits ces types de flux engendrent sur votre réseau. © Éditions Eyrolles Préparer son réseau au multimédia 248 Les caractéristiques des flux multimédias Initialement, un réseau IP, tel que l’Internet, était conçu pour véhiculer des données entre deux machines : transfert de fichiers, connexion web, messagerie, etc. Depuis, la voix et l’image ont fait leur apparition et ont étendu le champ d’utilisations du réseau : téléphonie, diffusion de films à la demande et conférences à plusieurs. Dans ce dernier domaine, on distingue l’audioconférence (voix uniquement), la visioconférence (voix + vidéo) et, d’une manière générale, la téléconférence (voix + vidéo + données). Ces flux multimédias induisent un certain nombre de contraintes nouvelles : • Les signaux audio et vidéo doivent être numérisés, ce qui veut dire convertir les signaux analogiques en bits numériques. • La voix nécessite une bonne synchronisation entre l’émetteur et le récepteur. • La vidéo engendre une augmentation du volume des données transférées. • La téléconférence nécessite de diffuser un flux entre un émetteur et plusieurs récepteurs qui peuvent devenir, à leur tour, émetteurs. La numérisation des signaux nécessite d’échantillonner la voix, de la quantifier, de la coder et, de plus en plus souvent, de la compresser : • L’échantillonnage consiste à prélever des échantillons du signal à intervalles réguliers, à l’instar du cinéma qui utilise 24 images par seconde pour traduire le mouvement. L’amplitude des échantillons prélevés peut varier de façon illimitée, mais doit pouvoir être représentée par un nombre fini de valeurs binaires. La plupart du temps, l’échantillon porte sur 8 bits, alors que, pour la haute fidélité (requise, par exemple, pour un Compact Disc), l’échantillon porte sur 16 bits. • La quantification fait correspondre une valeur à l’amplitude d’un échantillon par rapport à des valeurs-étalons appelées niveaux de quantification. La valeur sur un octet sera celle du niveau de quantification le plus proche. • Le codage consiste à transmettre un flux d’informations binaires correspondant à l’échantillon représenté par un octet. • De plus en plus souvent, le codage est associé à un algorithme de compression. Par exemple, la voix génère des signaux à une fréquence oscillant entre 300 Hz et 3 300 Hz, valeur arrondie à 4 000 Hz par les équipements numériques. Un chercheur, appelé Shannon, a montré que la fréquence d’échantillonnage devait être égale au double de la fréquence du signal à numériser. Un signal analogique de 4 000 Hz nécessite donc 8 000 échantillons par seconde, qui sont représentés sur 8 bits, soit un débit de 64 Kbit/s pour coder la voix. Cette unité, appelée DS0 (Digital Signaling 0), a longtemps été la référence et continue encore de l’être pour les liaisons d’accès E1/T1 proposées par les opérateurs, aussi bien pour la voix que pour les données. Les quatre opérations constituant la numérisation d’un signal analogique (audio ou vidéo) sont réalisées par des processeurs spécialisés appelés DSP (Digital Signaling Processing). Les algorithmes qui définissent la manière de réaliser ces opérations sont appelés Codec (codeur/décodeur).

Les codec audio

Par exemple, le codec utilisé sur les liaisons E1/T1 ainsi que sur le RTC répond à la norme G.711. Le codage est de type PCM (Pulse Code Modulation) ; il n’utilise aucun algorithme de compression. En France, la norme est appelée MIC (Modulation par impulsions codées), d’où le nom des liaisons à 2 Mbit/s proposées par France Télécom (32 canaux DS0, dont 2 pour la signalisation). Le codec G.711 existe en deux variantes de codage : A-law (Europe) et µ-law (Amérique du Nord et Japon). Codec (standard ITU) Algorithme de codage Échantillonnage Débit réseau nécessaire Délai de traitement du codec Durée de l’échantillon Taille de l’échantillon G.711 PCM (A-law / µ-law) 8 kHz 64 kbit/s 0,75 ms G.722 ADPCM 7 kHz 64 kbit/s 1 ms 1 octet G.723 MP-MLQ et ACELP 8 kHz 5,3 et 6,3 kbit/s 7,5 ms 30 ms 20 et 24 octets G.726 ADPCM 8 kHz 16, 24, 32 et 40 kbit/s 2 à 3,5 ms G.728 LD-CELP 3,1 kHz 16 kbit/s 3 à 5 ms 3,1 ms 5 octets G.729 CS-ACELP 4 kHz 8 kbit/s 15 ms 10 ms 10 octets Au délai de traitement du codec, il faut ajouter le temps mis pour remplir une trame. Par exemple, le codec G.723 génère une trame contenant 30 ms de voix. Elle comporte 240 échantillons compressés à 189 bits (24 octets) ou à 158 bits (20 octets), les deux premiers bits indiquant respectivement le type de codec et la taille de la trame. Les significations des sigles désignant les différents algorithmes de codage qui viennent d’être cités sont les suivantes : • ADPCM (Adaptive Differential Pulse Code Modulation) ; • CELP (Code Excited Linear Prediction) ; • LD-CELP (Low-Delay Code-Excited Linear-Prediction) ; • CS-ACELP (Conjugate-Structure Algebraic Code-Excited Linear-Prediction) ; • MP-MLQ (MultiPulse Maximum Likelihood Quantization). La qualité d’un codec dépend essentiellement de l’échantillonnage et du taux de compression : plus ce dernier est élevé, plus la voix apparaît métallique à celui qui l’écoute. © Éditions Eyrolles Préparer son réseau au multimédia 250 Sans compression, le codec G.711 sert de référence pour la qualité de la voix sur le téléphone, référence qui est appelée toll quality. La perception de la qualité de la voix est subjective. C’est pour cela qu’elle est mesurée à travers un indice moyen de satisfaction appelé MOS (Mean Opinion Score), sur une échelle allant de 0 (très mauvais) à 5 (très bon). Codec MOS Application G.711 4,1 RTC, RNIS G.722 G.723 3,65 IP G.726 3,85 G.728 3,81 G.729 3,92 Frame-Relay Les voix ayant une sonorité métallique obtiennent un MOS inférieur à 3 ; celles acceptables pour une communication téléphonique, un MOS compris entre 3 et 4. Au-delà de 4, la qualité est excellente. Le choix d’un codec résulte donc d’un compromis qualité/débit sur le réseau utilisé. Ainsi, le programme Netmeeting permet-il de sélectionner le plus approprié à votre contexte (menu “Outil→Options→Audio→Avancé”). Rappel des caractéristiques du codec Codec.

Les codec vidéo

Une image vidéo affichée sur un écran de PC représente 640 × 480 points en 16,7 millions de couleurs (24 bits) × 25 images par seconde, ce qui correspond à un débit de 23 Mbit/s (640 × 480 × 3 × 25). Afin de diminuer le débit généré sur le réseau, une première solution consiste à diminuer le nombre d’images par seconde. La meilleure solution consiste cependant à compresser les images, à l’instar de la voix. Pour les données, aucun bit ne doit être altéré dans les phases de compression et de décompression : la décompression d’un fichier doit reproduire exactement le fichier original. Les taux de compression sont, en moyenne, de 1 pour 2, voire plus pour les images bitmap. © Éditions Eyrolles Les flux multimédias CHAPITRE 12 251 Mais, pour la vidéo, l’image décompressée peut être différente de la même image avant compression. Ainsi, une légère variation de couleur ou la suppression d’un pixel n’est pas perceptible lorsqu’ils affectent 1 image sur 25 par seconde. Ce principe permet d’atteindre des ratios de compression de 1 pour 100, voire 1 pour 300. Une perte de qualité est acceptable à partir du moment où elle est à peine perceptible. La compression peut être spatiale (c’est-à-dire porter sur une image — mode intraframe) ou temporelle (c’est-à-dire porter sur plusieurs images dans le temps — mode interframe). Dans le mode interframe, seule la différence entre deux images est transportée à partir d’une image de référence (key frame) ou à partir de l’image précédente. Une technique de compensation de mouvement est, de plus, utilisée : le delta est calculé non pas pixel par pixel mais par bloc de pixels en mouvement. Dans le mode intraframe, l’image est divisée en blocs de 8×8 pixels : les pixels et leurs couleurs associées sont convertis en fréquence de changement de couleurs et amplitude des variations de couleurs. La moyenne est calculée sur le résultat, de manière que la perte d’information qui en résulte ne soit pas perceptible par l’œil. Les données sont ensuite compressées par un algorithme de type RLE (Run Length Encoding). Par exemple, M-JPEG (Motion JPEG) utilise un algorithme spatial (série d’images JPEG), alors que MPEG utilise une combinaison des deux, et notamment l’algorithme DCT (Discrete Cosine Transform) pour le mode intraframe