Stratégies de décision

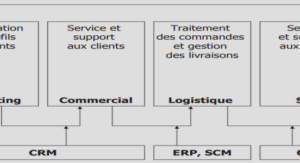

Dans une application de dialogue, la compréhension d’un message est réalisée par l’analyse de la transcription issue du module de reconnaissance. En ce qui concernele service 3000, l’interprétation de cette transcription passe par une succession d’étapes contrôlées par des sources de connaissance imparfaites (les règles d’allumage de concepts, les règles d’interprétation) qui traitent des données qui peuvent être incorrectes (les hypothèses de reconnaissance). Pour cette raison il est important dans ce type d’ap- plication de réduire la probabilité d’apparition des erreurs le plus tôt possible dans le déroulement du processus.Pour des systèmes de dialogue en langage naturel, tel que le service 3000, déployé auprès du grand public, une analyse des données nous a montré qu’il existe diffé- rents types de messages, comme les énoncés non-parole, les segments de parole Hors- Domaine et la parole Dans-le-Domaine. Comme nous l’avons expliqué dans la section 4.1,les segments Hors-Domaine peuvent générer une interprétation et orienter le système dans une mauvaise direction pour la suite du dialogue. De plus la génération des CNs pour ces énoncés, mais aussi pour les énoncés non-parole, est très coûteuse en termesde temps de calcul car les graphes correspondant sont très bruités et donc très « volu- mineux ». Le traitement de données réelles implique donc de devoir prendre en compte et de pouvoir traiter certains types d’énoncés qui, du point de vue du système, sont à rejeter. Pour pallier cela nous proposons de rejeter ces énoncés dès la première passe de reconnaissance. Les CNs sont générés sur les énoncés considérés valides. Concernant le processus d’interprétation, il est, dans un premier temps, appliqué sur la meilleure so- lution du CN pour tous les CNs générés. Au delà de cette approche séquentielle, nous proposons également une stratégie qui permet l’utilisation de la recherche intégrée sur le graphe de mots et sur les CNs, décrite dans la section 3.3.3, dans le processus d’in- terprétation.Le chapitre est organisé en trois parties. Dans la section 7.1, nous présentons les chan- gements apportés au protocole expérimental du fait de la prise en compte des spécifici- tés liées au traitement des données réelles. Une évaluation détaillée du comportement de l’algorithme du pivot topologique sur les différents types d’énoncés est aussi présen- tée. Dans la section 7.2, nous présentons une stratégie de décision à plusieurs niveaux (Minescu et Damnati, 2008) qui vise à rejeter les énoncés non-valides (bruits, commen- taires) dès la première passe de reconnaissance et à construire les CNs seulement sur les énoncés valides. L’approche séquentielle (analyse en concepts suivie de l’analyse sé- mantique) du processus d’interprétation est appliquée sur la consensus hypothesis pour tous les CNs générés. Dans la section 7.3, nous présentons une stratégie de décision ba- sée sur une approche intégrée du processus d’interprétation. Cette approche introduit un niveau de décision supplémentaire de rejet des énoncés valides mais qui ne sont pas couverts par le modèle sémantique de l’application (aucune interprétation n’est trou- vée).

Dans les évaluations présentées dans les chapitres précédents, nous n’avions pas pris en compte la variabilité des données réelles utilisées. Par exemple, le sous-modèle de langage de détection des commentaire n’a pas été utilisé par la première passe de reconnaissance. Ainsi, les énoncés Hors-Domaine n’ont pas été traités différemment des autres énoncés et, par conséquence, les annotations des commentaires réalisées dans les transcriptions manuelles des énonces ont été ignorées. Les mots composant les com- mentaires ont été comptabilisés comme tous les autres mots de l’application.Le tableau 7.1 présente deux énoncés Hors-Domaine avec la transcription manuelle an- notée. Lorsque aucun traitement particulier n’est appliqué aux énoncés Hors-Domaine (on ne détecte pas les commentaires) la référence est constituée des mots présents dans la transcription manuelle (les annotations sont ignorées). En revanche, lorsqu’on sou- haite appliquer des traitement spécifiques pour les énoncés Hors-Domaine (on détecte les commentaires), dans la référence de l’énoncé on remplace la séquence de mots, an- notée comme étant un commentaire dans la transcription manuelle, par un symbole unique <COMMENTAIRE>. Afin de pouvoir réaliser une évaluation du WER qui soit pertinente dans le contexte du système de dialogue, nous utilisons la méthode de nor- malisation Methode 4, décrite dans la section 4.4.1. Les énoncés ne contenant que des Le changement de la référence au niveau mot à aussi des répercussions au niveau in- terprétation. Ainsi, comme le montre le tableau 7.2, lorsqu’on souhaite appliquer des traitement spécifiques pour les énoncés Hors-Domaine (on détecte les commentaires), les énoncés étiquetés comme étant des commentaires deviennent des énoncés à reje- ter. Dans le cas contraire, les mots de la référence peuvent produire une interprétation, comme pour l’exemple 2. Sur le corpus Test_II on observe ainsi une augmentation du nombre d’énoncés à rejeter de 2% (soit 114 énoncés) du nombre total d’énoncés dans le corpus. Ce pourcentage représente le nombre d’énoncés couverts par l’analyse sé- mantique (qui donnent lieu à une interprétation) si aucun traitement spécifique n’est appliqué aux énoncés Hors-Domaine (la première passe de reconnaissance ne détecte pas les commentaires). L’exemple 2 dans le tableau 7.2 illustre bien cette situation.