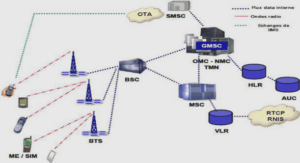

Architecture général du système de reconnaissance

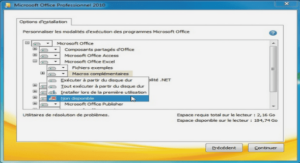

Dans nos expérimentations nous évaluons la performance des modèles audio-visuels HMM appris en utilisant les GA par rapport à l’apprentissage standard des HMM en utilisant une estimation du maximum de vraisemblance (EM). Comme l’a fait remarquer (Alpaydin 2004), nous devons toujours garder à l’esprit que les conclusions que nous tirons de l’analyse est conditionnée par l’ensemble de données. Ainsi, nous ne comparons pas les modèles et les algorithmes d’apprentissage d’une manière indépendante de domaine. Tout résultat nous présentons n’est valable que pour l’application particulière de AVASR et pour l’ensemble de données utilisé. Comme indiqué dans le Non déjeuner théorème de gratuit (Wolpert and Macready 1997) il n’y a pas une telle chose comme le « meilleur » algorithme d’apprentissage en général. Pour n’importe quel algorithme d’apprentissage, il y aura un ensemble de données où il est très précis et une autre ou il est très faible. Ainsi, nos résultats ne sont valables que pour l’application particulière d’AVASR et en particulier pour les corpus de données que nous avons choisis. Ces corpus de données sont discutés par la suite. Dans notre travail nous allons appliquer l’algorithme de clustering K-means sur les BDD audiovisuelles CUAVE et notre propre BDD arabe (AVARB), les résultats de cette opération seront en suite introduits au HMM pour faire l’apprentissage. Afin d’augmenter la performance du système de reconnaissance proposé, nous avons utilisé une nouvelle méthode basée sur l’hybridation des deux paradigmes HMM et GA. Chapitre 6. Réalisation 116 Pour réaliser ce système de reconnaissance, il fallait : Détection de visage et Localisation des lèvres dans les scènes vidéo en utilisant la méthode Viola-Jones. Extraction de paramètres acoustiques avec la méthode RASTA-PLP. Extraction de paramètres visuels avec la méthode DCT. Réaliser une quantification vectorielle et dégager des classes, en utilisant l’approche suivante : K-means. Phase d’apprentissage en utilisant les modèles HMM, et GA/HMM. Comparaison des taux de reconnaissance obtenus pour tirer la méthode la plus performante de reconnaissance.

Base de données utilisée

Les bases de données audiovisuelle arabe Dans notre travail nous avons utilisé notre propre base de données audiovisuelle de parole arabe : cette base de données multi-locuteurs a été enregistrée dans un milieu réel (une salle de cours très bruyante), Nous visons de plus la diversité des données pour un apprentissage bien amélioré, les vidéos sont capturées La à une distance moyenne égale à 16.5 cm avec une résolution de 690×450 pixel et à 30 trames/sec et avec des variations de pose (vue de profil, de face) pour un ensemble de 18 locuteurs (16 garçon et 2 filles) sauvegardées avec l’extension « .avi », alors que les fichiers audio sont sauvegardé avec l’extension « .wav », l’échantillonnage standard après des testes réalisés au sein de notre laboratoire est 16 KHz MONO (à un canal unique) car il est optimal de calculer les coefficients issus d’un signal acoustique à paramètres unique. Notre base AVARB contient 2 corpus, le premier corpus contient des prononciations des chiffres arabes isolés (de zéro (0) à neuf (9)), alors que le deuxième corpus contient un ensemble commandes en arabe (25 mots)

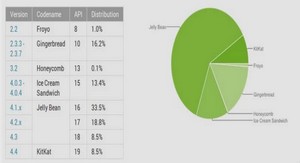

La base de données CUAVE

Elle se compose de 36 locuteurs, 19 hommes et 17 femmes, poussant chiffres isolés et continue. Les vidéos des orateurs sont enregistrées en profil frontal, et pendant le mouvement. La base de données CUAVE contient environ 3 heures de parole enregistrées par une caméra Mini DV. La Vidéo a ensuite été compressée en MPEG-2 fichiers (audio stéréo à un taux d’échantillonnage 44 kHz, 16-bit). Il comprend également des fichiers audio vérifiés pour la synchronisation (taux de mono de 16 kHz, 16-bit) et des fichiers d’annotation (Patterson et al. 2002).