Description du système proposé

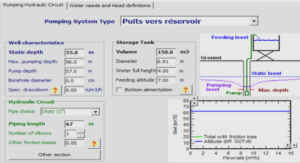

La spécification d’un système d’intelligence artificielle utilisant des HMM peut s’effectuer en trois phases distinctes, mais interagissantes entre elles (voir figure 5.1). La première phase, que nous nommerons prétraitement par la suite, consiste en l’ensemble des actions nécessaires à la transformation des données en séquences temporelles. La deuxième phase, dite d’apprentissage, consiste en la transformation de certaines des séquences construites en HMM, grâce à un algorithme d’apprentissage, tel que ceux décrits au chapitre précédent. La dernière phase, dite de post-traitement, consiste en l’utilisation des HMM produits en deuxième phase et de séquences produites par la première phase pour effectuer le traitement. Les traitements pouvant être réalisés par un tel système sont très variés : classification, segmentation, analyse, décision,…

La phase d’apprentissage joue un rôle central au sein d’un tel système mais, en pratique, peu d’attention lui est accordée dans le cas des HMM. Dans de nombreuses applications des modèles sous optimaux sont utilisés avec succès. Cependant, ces applications s’appuient sur des principes théoriques qui ne sont valables que lorsque les modèles sont optimaux. Par conséquent, il est communément admis que des modèles optimaux permettraient, du moins en théorie, d’améliorer les performances du système d’intelligence artificielle.

La RAP s’applique à ce jour sur de nombreux signaux de qualité différente (fréquence d’échantillonnage, quantification, codage, conditions d’enregistrement). Nous rappelons que la parole est l’un des moyens les plus naturels par lequel des personnes communiquent. La RAP a pour objet la transformation du signal acoustique en une séquence de mots qui,idéalement, correspond à la phrase prononcée par un locuteur. Les systèmes de reconnaissance qui utilisent comme entrée uniquement le signal acoustique atteignent leurs limites surtout dans des cas de situations environnementales bruités donc réelles. Dans ces cas, l’intégration de l’information visuelle dans le système de reconnaissance peut constituer une voie de solution (Rogozan 1999). A cet effet nous nous intéressons à la mise en oeuvre d’un système de reconnaissance intégrant conjointement les deux informations acoustique et visuelle de la parole se sont focalisés sur une interaction sensorielle de type fusion ou intégration. A ce niveau, reste posée la question du ou et comment cette fusion des modalités acoustique et visuelle se passe-t-elle chez l’homme. Pour répondre à cette question, il existe plusieurs modèles cognitifs qui diffèrent de par leur lieu d’intégration des informations en vue de leur intégration. La RAP audiovisuelle est née de l’idée que si l’homme exploite les informations provenant du visage du locuteur pour améliorer l’intelligibilité, la machine peut en faire autant, si d’une part le principe d’intégration des deux modalités est suffisamment bien connu, et si d’autre part les informations visuelles sont exploitées d’une façon optimale (Adjoudani and Benoît 1995).

Architecture de système de reconnaissance par fusion audiovisuelle

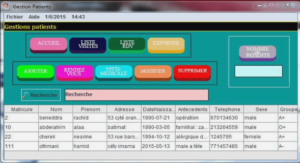

Le système AVASR comprend trois modules qui sont: le module de reconnaissance acoustique, le module de reconnaissance visuelle et le module de fusion. Le module de reconnaissance acoustique utilise l’approche stochastique basée sur les modèles de Markov cachées (HMM) qui sont un type particulier des réseaux bayésiens. On processus générique est basé sur trois phases qui sont : la para métrisation du signal acoustique utilisant dans notre cas l’analyse log RASTA-PLP (RelAtive SpecTral Analysis- Perceptual Linear Predictive), l’apprentissage des modèles repose sur une recherche génétique d’un bon modèle parmi une population hétérogène des HMM (contenant différentes architectures) et une optimisation par un algorithme de gradient (Baum-Welch) et leur décodage sur l’algorithme de viterbi. Le module de reconnaissance visuelle utilise la même approche stochastique, il diffère uniquement par la phase de para métrisation basée elle sur la DCT (Discrete Cosine Transform).

Nous savons que les lèvres véhiculent la majeure partie de l’information visuelle utile pour la compréhension de la parole. Les êtres humains emploient l’information visuelle de façon subconsciente afin de comprendre les paroles, particulièrement dans des environnements bruyants, mais également quand les conditions acoustiques sont bonnes. Le mouvement des lèvres du locuteur apporte une série d’information importante. L’effet McGurk (McGurk and MacDonald 1976) apporte la preuve en montrant que le cerveau, soumis à des stimuli auditifs et visuels inconsistants, perçoit un son différent de celui qui a été dit.La détection des visages pose le problème de la localisation des visages présents dans une image d’entrée. Idéalement, la détection fourni aussi leurs dimensions pour un éventuel traitement ultérieur.