Étude comparative de solutions d’allocation de ressources dans un système hiérarchisé (IoT-Edge-Cloud)

Deux solutions prometteuses d’allocation de ressource sont présentées et comparées avec une autre solution pour la validation de leurs performances. La première solution est basée sur l’énumération d’algorithme et le second sur le Clustering-heuristic. L’objectif est de résoudre le problème de minimiser le temps de réponse moyen de services par l’allocation des ressources de bord optimale pour les applications. intelligentes basées sur l’IoT, les services ont des contraintes de latence strictes, par conséquent, le temps de réponse sera critique pour l’utilisation de ces services. Nous présentons plusieurs analyses sur le service moyen de minimisation du temps de réponse en allouant de manière optimale les ressources de périphérie pour plusieurs applications.

Fonctionnement de l’architecture et les solutions

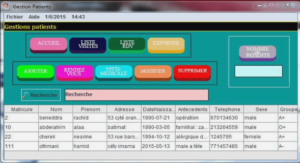

Nous considérons un scénario où les serveurs allouent des ressources à plusieurs applications pour prendre en charge les appareils IoT exécutant divers services de ville intelligente. Un nombre croissant de villes De la Figure 26, il peut être observé clairement que le temps de réponse du service se compose principalement de trois parties: le délai de transmission des données dans les réseaux périphériques, le délai de traitement des services dans les réseaux périphériques et le retard du réseau vers le nuage central pour les demandes excédentaires. Lorsque toutes les demandes de service des appareils IoT arrivent aux serveurs périphériques les plus proches hébergeant les applications correspondantes, les serveurs affectent les ressources informatiques à chaque requête. La capacité limitée de chacun des serveurs Edge pour traiter les demandes de service est également pris en considération. Un serveur Edge comprend un nombre de machines physiques interconnectées pour traiter les demandes de service entrantes, nous considérons chaque serveur de périphérie comme une unité abstraite à gérer les demandes attribuées. Par conséquent, il convient de modéliser le traitement des demandes de service dans chaque serveur Edge comme modèle de mise en file d’attente. Lorsque les serveurs de périphérie sont surchargés, le service de mode d’allocation passera au Cloud informatique traditionnel. Par la suite, les demandes de services excédentaires sera acheminé vers le Cloud central via le noyau réseau et Internet. En se basant sur les informations initiales des ressources (vCPU, Stockage et RAM) demandés par les applications au serveur en périphérique.

Une solution de dénombrement optimale pour SRTM principalement contient trois étapes. Tout d’abord, il énumère tous les possibles combinaisons d’allocation de ressources de bord pour plusieurs applications en utilisant les algorithmes standard d’ordonnancement. Ensuite, il calcule le service moyen temps de réponse de chaque cas d’allocation de ressources. Enfin, une combinaison optimale d’allocation de ressources pour plusieurs applications peut facilement être trouvée en comparant les résultats calculés. Pour chaque cas d’allocation de ressources, nous considérons l’affectation de demandes de service de périphériques IoT à serveurs de bord de manière équilibrée. Cette procédure délivre ces requêtes au serveur Edge le plus proche héberger les applications corrélatives et posséder des ressources inoccupées. En même temps, ça prend également en compte l’équilibrage de charge entre les serveurs de bord réalisables en affectant les demandes aux serveurs périphériques disponibles à leur tour.

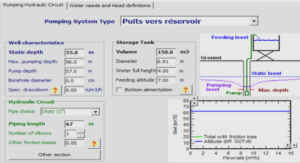

Présentation de la deuxième solution

Cette solution propose une programmation à trois(3) phases afin d’atteindre l’équilibrage de charge et de réduire le temps d’exécution de chaque nœuds dans l’environnement du Cloud. Dans la première phase, la programmation BTO (Best Task Order) détermine l’ordre d’exécution pour chaque demande de tâche. Dans la deuxième phase, la programmation EOLB (Enhanced Opportunistic Load-Balancing) assigne les taches à un gestionnaire de service approprié pour l’attribution du noeud de service. Dans la troisième phase, l’EMM (Enhanced Min-Min) garantit la planification qu’un nœud de service approprié sera affecté à exécuter la tâche dans le temps d’exécution minimum. En raison des propriétés du Cloud computing, la figure27 montre une topologie hiérarchique à trois niveaux. Le troisième niveau est le nœud de service qui sert à exécuter les sous-tâches. Le deuxième niveau est le gestionnaire de services qui sert à diviser la tâche en quelques sous-tâches indépendantes logiques. Le premier niveau est le gestionnaire de requêtes qui permet de confier la tâche à un gestionnaire de services approprié.

Dans la première phase, le meilleur ordre d’exécution sera organisé par la programmation BTO, après les tâches sont entrées dans l’environnement de Cloud computing et celles qui attendent l’exécution. Lorsque toutes les tâches sont entrées dans le Cloud computing avec la topologie hiérarchique, le gestionnaire de requêtes (nœud racine) rassemble les tâches nécessitant l’exécution et les stocke dans une file d’attente de travail donnant l’ordre d’exécution pour chaque tâche en fonction des caractéristiques de la tâche. En utilisant la programmation BTO le plus approprié. L’ordonnancement est obtenu selon la demande d’emploi et la priorité de service de chaque tâche. Ainsi, le système peut choisir l’ordre d’ordonnancement les plus Dans la troisième phase, un EMM (Enhanced Min Min) est proposé qui combine une programmation Min- Min et un seuil de nœud de service qui garantira la tâche se voit attribuer à un noeud approprié pour procéder à l’exécution minimum de temps. EMM peut choisir le meilleur nœud de service et utilise ensuite le seuil de noeud de service pour garantir que le nœud exécute la tâche dans les plus brefs délais. Ainsi, le travail peut être réparti de manière efficace et la meilleure allocation des ressources fournie.