« Kali », synthèse vocale à partir du texte

Nos recherches en synthèse vocale ont été initiées en 1981 avec la mise au point et la commercialisation d’un appareil portable à clavier phonémique destiné au handicap vocal [MOR 81]. En 1986, Synthé 3, système de synthèse par diphones doté d’un module de transcription graphème-phonème, lui succédait pour devenir en France, jusqu’au début des années 90, une référence à la fois dans le domaine du handicap vocal et dans celui du handicap visuel. Dans la continuité de ces travaux, le projet de recherche appliquée Kali démarrait en 1995, réunissant deux laboratoires universitaires et deux partenaires privés . Motivé par des besoins applicatifs précis mais également conduit dans le cadre de la recherche et de l’enseignement en phonétique-phonologie des langues, le programme Kali devait répondre à un triple objectif : disposer à terme d’une synthèse multilingue et, pour chaque langue, d’une voix non seulement intelligible, mais également acceptable pour l’utilisateur, enfin mettre en place une plate-forme de travail pour nos recherches en parole. L’action menée conjointement dans le domaine de la linguistique et de l’informatique a conduit au développement d’outils informatiques pour le traitement des données linguistiques (dictionnaires et règles pour l’analyse syntaxique et le calcul de la prosodie, règles de transcription graphème-phonème, outils d’écriture et de maintenance des règles) et la génération du signal de parole (analyse du signal vocal, mise au point de bases de diphones) .

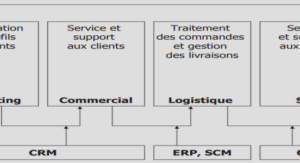

Doté de deux voix masculines et d’une voix féminine, pour l’heure, Kali fonctionne en langue française . Utilisable par la plupart des logiciels spécialisés pour déficients visuels , il peut également être intégré dans les matériels dédiés utilisés pour le handicap vocal. Cet article fournit une présentation critique de l’architecture du système dans son ensemble, c’est-à-dire des différents modules appelés en vue de la génération du signal de parole, des traitements symboliques à l’analyse acoustico-phonétique. En nous appuyant sur divers exemples linguistiques, nous précisons les principes fondamentaux qui régissent l’organisation interne des modules présentés et la façon dont l’information circule d’un module à un autre.Les quatre premiers modules reposent sur une exploitation déclarative des connaissances, la base de diphones, contenue dans le dernier module, est générée par un logiciel interactif de développement. L’objectif à court terme d’une synthèse bilingue (français-anglais) explique ce choix : une présentation déclarative des ressources linguistiques permet de passer rapidement d’une langue à une autre, seules les données, les dictionnaires et les règles changent, les outils de traitement restant les mêmes. Par ailleurs, une telle architecture facilite indéniablement la lisibilité, le traçage, la mise à jour et la correction des règles développées au sein de chaque module, donc la maintenance générale du système. Nos règles déclaratives et contextuelles, qui opèrent sur des unités de différents niveaux (chaîne graphémique, mot, constituant syntaxique ou prosodique, phrase, paragraphe), se composent classiquement de deux parties, la première correspond aux conditions d’application de la règle et la seconde spécifie la structure à engendrer lorsque ces conditions sont réunies.

Afin d’illustrer ce fonctionnement modulaire et les critères utilisés pour constituer les ressources associées aux différents modules, nous nous proposons de suivre séquentiellement le cheminement d’une phrase exemple, depuis le prétraitement jusqu’au module acoustico-phonétique.En premier lieu, cette opération a pour objet de nettoyer le texte, c’est-à-dire de réduire le jeu de caractères à manipuler afin de faciliter le travail des modules subséquents. Elle est fondamentalement liée au problème de resyllabation et s’effectue par la consultation d’un dictionnaire qui compte 430 entrées. Un deuxième dictionnaire est ensuite activable de façon fa¬cultative par l’utilisateur afin de transcrire correctement les mots pour lesquels la transcription graphème-phonème par règles, trop généralisante, ne peut s’appliquer. Le problème de resyllabation se pose essentiellement pour les sigles, les abréviations, les chiffres romains et les symboles, qui nécessitent une expansion préalable nécessaire au traitement prosodique pour que celui-ci puisse positionner correctement les accents : par exemple, le sigle ADN sans prétraitement serait considéré comme un mot d’une syllabe et donnerait lieu à une accentuation erronée sur la première voyelle. Certes, ce problème ne se rencontre pas dans les architectures où la transcription graphème-phonème précède la génération de la prosodie. Cette stratégie souvent utilisée [HAM 89] [AUB 91] [BOU 97] présente un avantage indéniable pour la syllabation. Encore faut-il conserver un alignement mot à mot du texte alphabétique et du texte phonémique pendant le calcul de la prosodie, tout en disposant intégralement du marquage syntaxique. Bref, aucune solution n’est parfaite et, compte tenu de cet inconvénient, nous avons opté pour l’architecture actuelle au prix d’un prétraitement plus lourd.