La reconnaissance visuelle de la parole

Approches statistiques

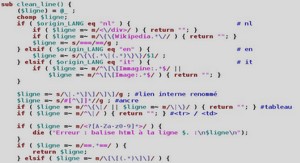

Pour les approches statistiques, comme nous l’avons déjà évoqué dans la section 2.3.2.1, l’espace de représentation (couleur) idéal pour séparer les lèvres du reste du visage sera déterminé statistiquement à partir d’exemples, au lieu d’être déterminé a priori. Pour la localisation de la bouche dans le visage, (Rao and Mersereau 1995) proposent d’utiliser la même approche statistique que celle qu’ils adoptent pour localiser le visage dans une scène complète (voir section 2.3.1.2). Le modèle de la bouche est constitué de deux arcs de parabole contenus dans un rectangle. Les modèles statistiques d’apparence de la bouche et du fond sont appris sur une seule image étiquetée manuellement. Les résultats préliminaires obtenus sur une séquence d’un locuteur unique semblent corrects, voir figure 2.9. On peut notamment remarquer sur cette illustration que l’intérieur de la bouche ouverte est correctement reconnu, mais aucun résultat où les dents sont visibles n’est présenté, ce qui limite l’évaluation d’une telle approche. Enfin, les auteurs indiquent que le contour interne pourrait également être détecté par cette méthode en considérant comme « objet », l’intérieur de la bouche et comme « fond », les lèvres. Pour la localisation précise du contour externe des lèvres, (Chan et al. 1998) utilise une transformation linéaire des composantes (R, V, B) de chaque pixel i : 𝐶𝑖 = 𝛼. 𝑅𝑖 + 𝛽. 𝑉𝑖 + 𝛾.𝐵𝑖 . (2.7) Les coefficients de pondération α, β et γ sont choisis statistiquement, comme dans (Kaucic and Blake 1998), pour maximiser la différence entre les pixels de bouche et de peau du locuteur, sur des images représentatives du problème à traiter, étiquetées manuellement. Images initiales (b) Segmentations finales obtenues Figure. 2.9 – Détection des lèvres d’après (Rao and Mersereau 1995). À partir de l’image composite C (voir figure 2.10c), le contour externe des lèvres est recherché en utilisant un modèle de forme spécifique au locuteur, la multi-résolution (des sous-échantillonnages successifs de l’image) et le gradient spatial. Revéret (1999), ainsi que (Nefian et al. 2002), utilisent également une image composite C. Les coefficients α, β et γ sont obtenus par analyse discriminante linéaire utilisant des images du visage et de la bouche segmentées manuellement. Une image binaire des lèvres est ensuite obtenue par seuillage et permet la détection du contour externe des lèvres. (Wojdel and Rothkrantz 2001a; Wojdel and Rothkrantz 2001b) repèrent les lèvres en utilisant soit l’approche couleur proposée par (Coianiz et al. 1996), soit une approche statistique basée sur l’utilisation d’un réseau de neurones d’architecture très simple R3,5,1. Les auteurs indiquent que dans certaines conditions, l’approche de Coianiz ne permet pas de segmenter efficacement les lèvres du reste de l’image et proposent deux alternatives. La première réside dans l’utilisation conjointe de la teinte filtrée et de l’intensité filtrée, dans les deux cas à l’aide d’un filtre parabolique qu’il est préférable d’adapter aux images à traiter. La position centrale (équivalent du paramètre H0 de l’eq. 2.5) et la sélectivité du filtre (w) doivent alors être réglées et il faudra choisir comment utiliser conjointement les informations de teinte et d’intensité filtrées. Les auteurs proposent d’effectuer de manière automatique les réglages en demandant aux utilisateurs de leur système de désigner (à l’aide de la souris) leurs lèvres sur la première image acquise de leur visage. La seconde alternative réside dans l’utilisation de la zone marquée par l’utilisateur pour étiqueter l’image et entraîner un réseau de neurones à la tâche de classification entre les classes « lèvres » et « non-lèvres ». Le perceptron multicouches utilisé contient trois entrées pour les valeurs R, V et B de chaque pixel, une couche cachée de cinq nœuds et une sortie comprise dans l’intervalle [0,1] indiquant si le pixel couleur en entrée appartient plutôt aux lèvres (valeurs proches de 0) ou au reste (valeurs proches de 1). Les résultats de classification obtenus à l’aide du modèle neuronal sont, d’après les auteurs, légèrement supérieurs à ceux obtenus avec la teinte (qui est plus bruitée), comme l’illustre la figure 2.10. (a) Image initiale (b) Teinte filtrée (c) Sortie du réseau de neurones Figure 2.10 – Détection des lèvres d’après (Wojdel and Rothkrantz 2001a; Wojdel and Rothkrantz 2001b). Enfin, (Luettin et al. 1996a; 1996b ; 1996c; 1996e; 1996f; Luettin and Thacker 1997) détectent précisément les contours interne et externe des lèvres à l’aide de modèles de la forme et de l’apparence des lèvres appris statistiquement à partir d’images étiquetées manuellement sur le corpus Tulips1 (Movellan 1995). Il utilise des images en niveaux de gris et extrait, à partir des contours matérialisés par des polygones, le profil en niveaux de gris perpendiculaire au contour, pour chacun des sommets de ses polygones. Les profils correspondants à tous les points de contour sont alors concaténés et les vecteurs globaux ainsi obtenus pour de nombreuses images, sont analysés par l’Analyse en Composantes Principales (ACP) pour obtenir l’apparence moyenne de la bouche ainsi que ses principales variations d’apparence. La localisation de la bouche se fait par minimisation du modèle de la forme et de l’apparence des lèvres. Signalons également que cette même approche est utilisé sur le corpus M2VTS (Pigeon and Vandendorpe 1997) dans (Luettin 1997a; 1997b; Luettin and Dupont 1998; 2000). Les images couleurs de ce corpus sont converties en niveaux de gris pour être utilisées.

Approche par corrélation avec des patrons

Nous avons rencontré une approche où, à l’instar des travaux de (Brunelli and Poggio 1993) qui repèrent différents éléments du visage en recherchant le point de meilleure mise en correspondance d’imagettes de ces éléments sur l’image, la bouche était localisée de façon relativement précise par une approche « template matching ». (Shdaifat et al. 2001) localisent directement la bouche sur une image présentant un visage complet avec un fond non-uniforme, en utilisant la corrélation entre une image de « bouche moyenne » et l’image à analyser. Dans un premier temps, les auteurs constituent par inspection visuelle, des classes des différentes formes de bouche susceptibles d’être rencontrées (visèmes). Puis des images représentatives de ces cinq visèmes sont moyennées pour obtenir une image de « bouche moyenne » utilisée pour localiser la bouche sur l’image. Les auteurs reconnaissent que des éléments du visage autres que la bouche peuvent être détectés à tort (yeux notamment) et proposent de raffiner la recherche en calculant la corrélation entre des imagettes des commissures droite et gauche de la bouche, du même locuteur, et les zones de l’image à analyser où le coefficient de corrélation dépasse un seuil. Les commissures sont ainsi localisées et leur position sert de référence pour normaliser l’image en rotation et en échelle. L’image de la zone de la bouche normalisée est finalement comparée aux images des cinq visèmes pour sa classification. Des expérimentations de cette méthode ont été effectuées pour quatre locuteurs, et les taux de classification correcte obtenus varient de façon très importante selon le locuteur et la généralisation de ces travaux monolocuteur à un cadre multi-locuteurs ne nous semble pas évidente.

Approches mouvement

(Leroy and Herlin 1995; Leroy et al. 1996a), dont nous avons déjà évoqué les travaux dans la section sur la localisation de visage (section 2.3.1), propose d’utiliser le gradient spatiotemporel (voir figure 2.10), calculé sur une trentaine d’images, pour détecter la position de la bouche. Plus précisément, la bouche est définie dans l’approche de Leroy comme la zone de fort gradient spatio-temporel la plus basse située le long de la médiatrice du segment des yeux. Selon l’auteur, la localisation de la bouche n’est pas très précise et dépend du mouvement qu’elle a eu pendant la séquence d’images étudiées. Broun et al. (2002) utilisent également la différence inter-images combinée à la couleur pour localiser la bouche d’un sujet en train de parler. Ils se distinguent de (Liévin and Luthon 1999), en utilisant l’accumulation des différences inter-images sur une séquence de 30 images. Les différences inter-images sont calculées pixel à pixel sur la composante rouge, puis elles sont sommées et seuillées pour obtenir une image binaire faisant ressortir les zones en mouvement. Cette observation de mouvement est combinée (opérateur ET), avec une image Chapitre 2. La reconnaissance visuelle de la parole 47 obtenue à l’aide de seuils haut et bas de la teinte et de la saturation. L’image-produit obtenue fait ressortir les zones en mouvement dont la teinte et la saturation correspondent à celles des lèvres. Enfin, signalons que (Mase 1991 ; Pentland and Mase 1989) effectuent un calcul de flot optique sur des images contenant les lèvres d’un locuteur. L’information de mouvement ne sert pas, dans ces travaux, à localiser les lèvres, mais bien à étudier leurs mouvements, ou plus exactement à mesurer le mouvement dans quatre fenêtres : les deux premières contiennent les moitiés haute et basse de la bouche, c’est-à-dire les lèvres supérieures et inférieure et les deux restantes les moitiés gauche et droite de la bouche. (Gray et al. 1997b) compare d’ailleurs cette approche par flot optique à d’autres approches dynamiques pour la reconnaissance de parole visuelle.