Analyse de contenu des entretiens

L’analyse de contenu est une méthode empirique ayant pour but de traiter l’information contenue dans les messages par des « procédures systématiques et objectives de description du contenu » (Bardin, 1993, p.39). Elle s’effectue en exerçant une « vigilance critique » (Ibid., p.31) à l’égard de l’objet d’analyse par la construction de grilles d’analyse, afin de lutter contre l’évidence d’un savoir intuitif, donc subjectif. L’analyse des entretiens a débuté par la transcription des données recueillies sur le terrain. Les variables indépendantes liées à la situation singulière de chaque personne interviewée (âge, sexe) n’ont pas été prises en compte au-delà de leur caractère informatif, puisque l’analyse porte davantage sur la « restitution de situations vécues » (Ibid.) par les C.P.E. interviewés que sur les conditions mêmes de déroulement de ce vécu. Nous ne cherchons pas à mettre en évidence des liens de causalité entre des caractéristiques du contexte et les faits exprimés par les participants, mais à comprendre comment ceux-ci agissent.

Transcription des entretiens

Les entretiens, d’une durée moyenne de 48 minutes, ont été intégralement enregistrés et retranscrits manuellement par traitement de texte. Consciente du dilemme qui peut surgir entre fidélité au discours et lisibilité dans la transcription (Bourdieu cité par Guéranger, 2006, p.9), nous avons opté pour une transcription littérale la plus fidèle possible des styles employés par les personnes interviewées, sans transformer les tournures de phrases en fonction des normes d’écriture littéraire. En revanche il a été nécessaire d’introduire des éléments de ponctuation pour rythmer le discours. Une numérotation intégrale des lignes du verbatim nous permettra de faire référence aux extraits de texte pertinents dans une première étape d’analyse. Les modalités de retranscription ont donc été fixées de manière à minimiser les tensions inhérentes à l’écriture d’entretiens, entre le souci de rendre compte en décrivant, de communiquer des informations et enfin d’expliquer des situations (Guéranger, 2006, p.5). Les questions de l’interviewer figurent en italiques, pour en faciliter le détachement du reste du texte. Les entretiens étant anonymés, les C.P.E. interviewés sont différenciés par leur prénom d’emprunt dans les transcriptions. Les indications relatives au contexte dans lequel se déroule l’entretien et audibles à l’enregistrement ont été conservées à la retranscription, pour renseigner sur l’état d’esprit des personnes et enrichir l’analyse du contenu grâce aux éventuels changements de ton, hésitations, exclamations, répétitions de termes. Cependant, les informations sur les comportements individuels imperceptibles dans l’enregistrement n’ont pas été notées durant les entretiens, pour nous permettre de rester disponible dans l’écoute et d’effectuer des relances dans la discussion.

Analyse des discours

A partir des corpus d’entretiens retranscrits, l’analyse de discours procède, à partir d’une lecture attentive au propos de l’interviewé, par déconstruction de l’agencement chronologique du texte afin de dévoiler des significations qui passent inaperçues durant l’entretien lui-même. Cette analyse effectuée entretien par entretien, selon un mode de découpage propre à chacun d’entre eux, est assez proche du résumé de discours (Blanchet et Gotman, 2013, p.90). Le produit de cette lecture analytique est une synthèse de chaque entretien par laquelle nous proposons de rendre compte de la cohérence du discours des C.P.E..

Analyse qualitative de contenu thématique

A partir de chaque corpus d’entretien retranscrit intégralement, la technique d’analyse de contenu (Bardin, 1993) a consisté en une première analyse empirique (Andreani et Conchon, 2005, p.5), dans une démarche inductive d’abstraction des données recueillies : c’est à travers l’imprégnation des discours des interviewés et selon un processus non linéaire de construction de sens que des thèmes ont émergé. Cette pré-analyse intuitive (Henry et Moscovici, 1968, p.40) a conduit à un premier agencement des fragments de discours en fonction de catégories thématiques. Elle s’est 145 enrichie au cours de son élaboration dans un mouvement de va-et-vient entre une lecture exploratoire des verbatim et des références aux hypothèses d’investigation posées grâce à l’éclairage théorique. Ces différentes classes thématiques ont dû ensuite être affinées en répondant aux critères retenus par Berelson pour la catégorisation (1952, in Bardin, 1997, pp.153-154), en particulier le principe d’exclusion mutuelle qui oblige à ne pas affecter d’éléments du discours dans deux catégories différentes. Nous avons classé les différents fragments de texte correspondant aux idées clés énoncées par les interviewés selon une grille par unités sémantiques de contenu qui s’est construite au fil de l’analyse, et stabilisée à partir du moment où le principe d’exclusivité a été satisfait. Pour le vérifier, nous avons surligné dans le corpus d’entretiens chaque extrait classé d’une couleur différente par thème.

Traitement automatisé du langage

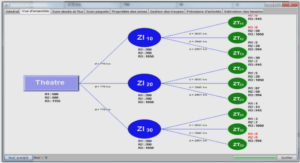

En complément de l’analyse qualitative de contenu, une analyse textuelle automatisée a été effectuée à l’aide du logiciel libre Iramuteq, développé par Pierre Ratinaud . Ce logiciel requiert au préalable l’installation du logiciel R de calcul statistique 2.6.1. pour la constitution des bibliothèques. L’utilisation d’Iramuteq nécessite une préparation minutieuse du corpus de textes : un corpus unique a été généré à partir des 10 entretiens qui constituent autant de modalités d’une même variable pour le logiciel. Chaque modalité correspond au nom du CPE (codification en mots étoilés séparateurs des verbatim : **** *e_prenomCPE, où « e » signifie entretien). En repérant le vocabulaire dans les différentes unités de contexte que constituent les différents entretiens, Iramuteq effectue une analyse lexicale qui permet de comptabiliser et de comparer les formes et les occurrences repérées dans les discours. Le logiciel néglige la syntaxe et l’organisation du discours, il ne prend pas en compte le sens du propos. Les résultats du traitement automatisé visent donc uniquement à confirmer ou infirmer des tendances constatées avec l’analyse manuelle linéaire, qui est globale et tient compte de l’organisation du propos.

Analyse de questionnaire

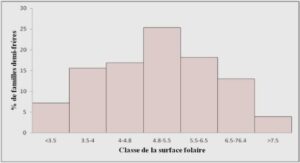

Traitement quantitatif

Le traitement quantitatif du questionnaire nécessite de coder108 les réponses recueillies puis d’effectuer des opérations de tri des informations obtenues. Le logiciel Sphinx effectue automatiquement les opérations de codage dès lors que nous avons paramétré les questions lors de la conception du questionnaire. Nous avons ensuite utilisé deux fonctions principales de tri pour obtenir les tableaux statistiques des réponses aux différentes questions fermées : – le tri à plat permet de calculer pour chaque variable le taux de réponses obtenues en fonction de chaque item. Les réponses obtenues pour chaque question sont présentées sous forme de tableau et de graphique. – Le tri croisé permet de croiser les réponses obtenues de deux variables différentes pour mettre en évidence la relation entre elles.