Le personnel

La société est composée de Chef de projet, ingénieurs, rédacteurs/journalistes, experts comptables, juristes, secrétaire, graphistes.Et pour la réalisation du projet, il y a le manager de Magiquemedia qui s’est chargé de nous encadrer et il y a aussi les rédactrices pour la documentation puis de nous-même pour le développement et la mise en locale et en ligne de l’outil.

Ressources matérielles

Le parc informatique de la société Magiquemedia se compose actuellement :

1 serveur dédié (Pentium 4 ayant un CPU à 3 GHz et une mémoire vive de 2 Go et dont la plate-forme est Windows 2003 Server) faisant fonctionner IIS et SQL Server 2005.

Des ordinateurs de bureau et des ordinateurs portables pour la conception et le développement de l’outil SEO.

Des ordinateurs de bureau aussi pour la rédaction des contenus et aussi pour effectuer des recherches sur Internet.

Tous les logiciels nécessaires pour le codage et pour le traitement des images.

Ressources matérielles

De manière schématique, un moteur de recherche se divise en quatre parties :

Un robot (araignées) qui cherche des sites web sur Internet ;

Un indexeur qui analyse les pages trouvées ;

Une base de données dans laquelle sont stockés les pages résultat de l’analyse ;

Un site sur lequel les internautes peuvent consulter la base de données à partir d’un mot clé.

Importance de contenu pour le SEO

Dans le monde du Web, tout est relatif. On peut avoir un bon contenu sur le site, mais une mauvaise navigation est ce qui découragera le plus le visiteur, et viceversa. Pour comprendre comment fonctionne SEO pour l’écriture, concentronsnous sur les caractéristiques de base du SEO.

Un site web est créé pour diffuser des informations à un public ciblé, client, visiteur, et les utilisateurs en général.

En tous les cas, le site ne doit pas juste avoir un bon sens mais aussi créer un impact positif sur l’auditoire.

L’audience d’un site web peut varier, mais le but est de présenter ces informations de manière simple et compréhensible.

Le sujet de base d’un site doit mettre en évidence le type de mots clés qu’on doit utiliser dans un site Web.

Cependant, il y a certains sites dont le contenu a été optimisé à un tel point, que le contenu n’est plus pertinent.

Maintenant, obtenir des visiteurs sur le site n’est pas le seul but de l’optimisation.

Le visiteur doit trouver ce qu’il cherche, et comment fera-t-il à moins de le guider.

Il a besoin de lire des termes clairs qui l’informeront sur les produits, les services et les tâches comparables.

SEO a certains aspects de base, vous devez comprendre que tout bon site web répondra aux conditions ci-dessous :

Une bonne conception d’un site Web.

Une navigation facile.

Information: contenu pertinent et concis.

Lien populaire.

Échange de liens.

Les gens se demandent souvent: «Comment un bon contenu pourrait aider » ?

Si on entasse toutes les informations et attendez que le lecteur sache ce qu’il veut grâce à un tas de pages, le site ne va pas marcher. Le contenu doit être court et concis. Si vous étiez le lecteur, comment disposeriez-vous des informations sur le site ? De manière à être facile à comprendre et rapide à lire. Donc, on utilise des bulles pour les informations cruciales et on les garde courtes et compréhensibles.

Le visiteur décidera sans doute s’il veut passer du temps sur le site dès les premiers instants. C’est une question de secondes avant de perdre un visiteurprécieux, un client potentiel et ainsi de suite.

Présentation du projet

Voici les stratégies de référencement efficaces qui constituent un excellent moyen d’atteindre un niveau élevé dans les classements des moteurs de recherche.

Le marketing en ligne grâce à des annonces Internet est un moyen rentable de promouvoir votre entreprise. Les stratégies efficaces d’optimisation des moteurs de recherche devraient être suivies pour atteindre un niveau élevé dans les classements.

C’est le but de la plupart des entreprises pour atteindre une position dans les dix premières pages des moteurs de recherche principaux. Un certain nombre d’éléments devraient être considérés lorsque vous envisagez de développer un site web professionnel.

Pour générer davantage de trafic vers un site Web, un contenu bien écrit est un facteur important. Le contenu qui est riche en mots clés, et en même temps, informatif et créatif, peut permettre à votre site d’obtenir un meilleur classement dans les moteurs de recherche. En même temps les titres devraient être bien étayés. Les liens intermédiaires doivent être indiqués dans tels contenus ou tels articles. Les liens spécifiques aux mots-clés peuvent effectivement augmenter la popularité d’un site Web. Le choix des mots clés est important, et doit se faire soigneusement car il faut inclure des termes et des expressions qui sont communément recherchées.

Un site conçu et développé d’une façon attrayante attire naturellement plus de trafic. Les dessins doivent être faits de manière aussi bien attrayante au niveau visuel et esthétique que significative. Le contenu doit être riche en mots clés et suffisamment intéressant pour retenir les visiteurs. Les mots clés doivent être placés dans les URL de page, les balises de titre, les titres principaux et les sous-rubriques. Les Meta-tags et les descriptions devraient aussi être efficacement établis pour que votre site web obtienne un meilleur rang dans les principaux moteurs de recherche.

L’obtention de services professionnels pour aider à la réussite de la commercialisation des produits en ligne n’est pas si difficile si vous pouviez trouver un fournisseur expérimenté et fiable de services dans le domaine concerné. Il faut pouvoir facilement atteindre les objectifs d’affaires spécifiques grâce à un tel fournisseur de services. La plupart des fournisseurs de services d’optimisation de moteur de recherche combinent des méthodes appropriées pour l’optimisation d’une part, mais aussi l’analyse des mots, l’analyse du fonctionnement, de la navigation sonore, de la maintenance des sites web, les mesures de site et les mesures pour suivre la performance, la promotion et l’accessibilité du maquillage, des rapports de classement des moteurs de recherche, avec le développement du contenu et la conception des services web.

METHODOLOGIE

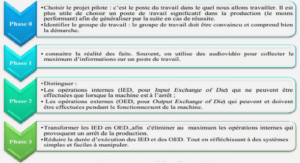

Etude préalable

Etude

Au début, nous nous sommes intégré au sein de la société pour participer à la vie de cette dernière. Une réunion à laquelle participions le Manager de Magiquemedia, Madame Bija Harilanto Rakotoniaina, et nous a été faite pour déterminer les travaux à faire pour la mise en place d’un outil de référencement et de duplication d’un site web pour la société Magiquemedia. L’objectif a donc été fixé pour la mise en œuvre du projet. Nous avons dressé une liste de rubriques.

Un peu d’histoire

Le plagiat existe depuis l’antiquité et il désignait ceux qui vendaient les hommes libres en tant qu’esclaves. A l’origine, cette notion n’a donc rien à voir avec celle que l’on lui donne aujourd’hui : « Copier (un auteur) en s’attribuant indûment des passages de son œuvre » (Petit Robert 2009). Le phénomène est de plus en plus présent aujourd’hui et notamment grâce à l’avènement d’Internet.

Les méthodes

Dans le but d’augmenter les chances de détection de plagiat par l’outil SeoPlagiarism, celui-ci fait évidemment ses recherches sur Internet. L’outil SeoPlagiarism est capable d’effectuer ses recherches directement sur deux des moteurs de recherche le plus utilisée Google et Live Search. A partir de là, des sites comme Wikipédia et autres sites de documentation, particulièrement prises des étudiants, des rédactrices, deviennent accessibles à la procédure de détection.

Mais avant de se lancer dans la comparaison de texte, il faut pouvoir l’analyser correctement. Le texte est tout d’abord découpé en paragraphes puis en phrases. Chaque phrase est représentée par une chaîne de caractère. Il est évident que comparer juste des mots pris au hasard ne sert à rien. Il faut les comparer dans leur contexte, c’est à dire la phrase.

Les besoins et leur analyse

Les besoins sont importants pour notre projet car ils déterminent l’architecture et les contraintes de notre outil SeoPlagiarism.

Comment extraire les textes

L’outil à concevoir doit être simple. Les utilisateurs ne doivent pas avoir beaucoup de difficulté. Pour pouvoir fonctionner, l’outil doit évidemment prendre comme argument un texte. En l’occurrence, l’outil en entrée un texte ou un url contenant les différents textes à analyser. L’outil doit donc veiller à ce que le dossier passé en paramètre existe, ensuite nous allons faire seulement copie coller du texte

Analyse du texte

Une fois les textes extraits dans une chaîne de caractères, il traite les textes un par un, en le découpant en paragraphes puis en phrases et en effectuant des travaux d’analyse de longueur des phrases, puis finalement en comparant ces analyses.

Rechercher l’existence et les correspondances du texte via Internet

Allant une fois traiter chaque texte un par un et le découper en partie de texte c’est-à-dire en paragraphe ou en phrase puis appeler les recherche existants (en l’occurrence, au minimum un Google Ajax Search qui prend en paramètre une partie de texte qu’il recherche suivant les directives qu’on lui a imposé et qui renvoie un tableau de résultat qui sont récupérés. Une fois le tableau de résultat renvoyé par le Google Ajax Search par exemple qui correspond, les résultats sont traités en comparaison avec la partie de textes correspondants et les similitudes sont notées (sous forme de soulignement des parties correspondantes dans les résultats).

Une fois que toutes les parties d’un texte extrait ou d’url sont traitées, un résultat global est créé (Nombre de caractère, temps d’exécution et soulignement global des parties en correspondances en gras).

L’environnement de la base de données

SQL Server 2005

SQL Server 2005 est le nouveau SGBDR (Système de gestion de bases de Données Relationnelles) de la plateforme Microsoft. Basé sur les points forts de son prédécesseur (SQL Server 2000), il y est inclus beaucoup de nouvelles fonctionnalités qui nous permettront de devenir plus productifs.

Par exemple :

1. Partager des données entre diverses plateformes, applications et systèmes pour faciliter la connexion, tant interne qu’externes.

2. Interopérabilité : Grâce à une prise en charge étendue des standards, des services Web et de Microsoft .NET Framework, SQL Server 2005 assure l’interopérabilité entre plateformes, application et systèmes

SQL Server 2005 Express Edition

SQL Server Express est une édition gratuite de Microsoft SQL Server, il permet d’utiliser des bases de données SQL sans aucun additionnel. SQL Server 100% compatible.

Les caractéristiques de SQL Server 2005 Express Edition

Aisance aux développeurs les adaptations des applications sous SQL Serveur.

Avec toutes ses fonctionnalités : transactions, procédures stockées ?

Conception et développement compatibles pour les clients qui travaillent avec SQL Server.

Utilitaire d’administration et de consultations SQL Server Management Studio Express.

Supporte jusqu’à 1 processeur et 1 Go de mémoire RAM.

Base de données limitées à taille 4 Go.

SQL Server Express Edition est une édition de SQL Server qui permettra de faire, à tout moment, la migration vers une édition supérieure. Cela veut dire que, suivant la croissance du projet, si nous avons besoin de plus de puissance et de capacité pour la base de données, nous bénéficierons des avantages suivants.

Indexation de l’outil

Pourquoi ?

Il est très efficace en termes de rapidité et d’abondance de résultat en implémentant dans notre site le plus récent nouveauté. Facile à intégrer dans le site et très organisant en utilisant AJAX.

Google est le premier rang mondial de moteur de recherche le plus utilisé.

L’indexation est donc très efficace, et l’abondance de résultat serait un grand atout de Google.

Google Ajax Search API est le successeur de Google Search SOAP API.

Ce dernier ne plus disponible de clé d’activation depuis l’année 2006, c’est pourquoi nous utilisons ce fameux Google AJAX Search API la nouveauté du Web.

Enregistrer une clé de Google AJAX Search et de Live Search

Il faut avoir un compte de Google pour obtenir une clef de Google Search Ajax api, et la clé d’api est attachée directement à votre compte de Google. On peut produire des clefs multiples d’api pour votre compte si on a des sites Web multiples.

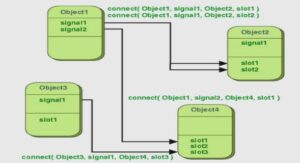

Indexation par Google AJAX Search

Nous avons utilisé le newtonsoft.json.dll et le newtonsoft.json.xml tel que Google Ajax Search Api intègre. Nous abordons le but en utilisant le langage C# pour créer la classe GoogleSearch.cs. Cette classe nous permet de faciliter la manipulation de résultats.

Indexation par Live Search

Nous avons créé une classe LiveSearch.cs permettant d’ajouter et de paramétrer les clés, ma recherche, le nombre page de résultat de Live Search API.

Le paramétrage de la référence de Live Search doit ajouter dans la référence du projet SeoPlagiarism. C’est-à-dire un url dans le référence du projet [14]

Table des matières

SOMMAIRE

REMERCIEMENTS

LISTE DES ABREVIATIONS

TABLE DES FIGURES

INTRODUCTION

Partie I : CONTEXTE GENERAL

I. Stage au sein de Magiquemedia

I.1. Les moteurs de recherches

I.2. Promotion de site web et internet marketing avec Magiquemedia

I.2.1. Présentation générale

I.2.2. Le personnel

I.2.3. Ressources matérielles

I.2.4. Ressources matérielles

I.3. Importance de contenu pour le SEO

II. Présentation du projet

II.1. Introduction au domaine

II.2. Introduction au projet

Partie II : METHODOLOGIE

I. Etude préalable

I.1: Etude

I.1.1. Un peu d’histoire

I.1.2. Les méthodes

I.2 : Les besoins et leur analyse

I.2.1. Comment extraire les textes

I.2.2. Analyse du texte

I.2.3. Rechercher l’existence et les correspondances du texte via Internet

I.3. Rapport sur la détection

II. Les outils et les technologies nouvelles

II.1. Préparation de l’environnement

II.1.1. Microsoft Visual Studio 2005

I.1.2. L’ASP.NET

I.1.2.1. Pourquoi ASP.NET ?

I.1.2.2. ASP.NET 2.0

I.1.2.3. Configuration SQL Server et ASP.NET

I.1.2.4. Connexion à la source de données

II.1.3 L’environnement de la base de données

II.1.3.1. SQL Server 2005

II.1.3.2. SQL Server 2005 Express Edition

II.1.3.3. Les caractéristiques de SQL Server 2005 Express Edition

II.1.3.4. La base du données du projet SeoPlagiarism

II.1.4 Configuration d’ASP.NET 2.0 et AJAX dans le Microsoft VS 2005

II.1.4.1. Introduction à AJAX

II.1.4.2. Installation d’AJAX dans Microsoft Visual Studio

II.2. La nouvelle technologie appliquée au développement de l’Outil

II.2.1. L’ASP.NET 2.0 AJAX

II.2.2. Les commandes de serveur d’ASP.NET 2.0 AJAX

II.2.2.1. ScriptManager

II.2.2.2. UpdatePanel

II.2.2.3. UpdateProgress

II.2.2.4. Timer

II.3. Indexation de l’outil

II.3.1. Pourquoi ?

II.3.2. Enregistrer une clé de Google AJAX Search et de Live Search

II.3.3. Indexation par Google AJAX Search

II.3.4. Indexation par Live Search

III. Le développement de l’outil

III.1. L’architecture de développement

III.2. Comparaison de l’architecture MVC et 3-tiers

III.3. Langage

III.4. Exemple d’utilisation des contrôles AJAX dans l’outil

III.5. Plan du site

III.6. Réparation du fichier pour le design

Partie III : RESULTATS

I. Les modules de l’outil

I.1. Modules de vérification de duplication

I.1.1. Accueil (Page de vérification de contenu d’un url)

I.1.2. Recherche par paragraphe ou phrase

I.1.3. Vérification contenu d’un url

I.2. Module d’enregistrement

I.3. Module Forum

I.4. Module Blog

I.5. Module Connexion

II. Limites et contraintes

II.1. Le faux positif

II.2. Quid des résultats de recherche

II.2.1. Moteur de recherche

II.2.2. Limites de Google

II.2.3. Connexion

II.2.4. Technologie liés

CONCLUSION