CONTRIBUTION A LA MISE EN ŒUVRE D’UNE VISION ROBOTIQUE

Capteurs visuels et configurations

Différents capteurs utilisables Ce sont surtout des capteurs qui permettent la perception non invasive, notamment par l’utilisation des ondes électromagnétiques. On distingue : – Les dispositifs à ondes RADAR C’est un système de détection et de télémétrie par ondes radio. C’est un appareil émettant et recevant des ondes électromagnétiques. Il est utilisé, souvent, pour localiser un objet dans l’espace et déterminer sa distance, sa taille, sa forme ainsi que sa vitesse et sa direction. – Les dispositifs à balayage LASER – Les Caméras vidéo

La caméra vidéo

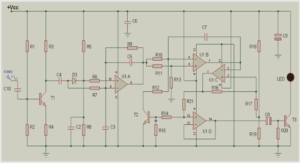

C’est le plus développé et le plus utilisé du fait de son rapport qualité-prix relativement élevé. Actuellement, on n’utilise plus les caméras à tubes mais plutôt les caméras CMOS ou CCD. a. Principes de fonctionnement La puce est, en général, une matrice de capteurs photosensibles convertissant l’énergie lumineuse en charges électriques. L’optique sert à faire converger les rayons issus d’un point de l’espace vers un point du plan focal (où se trouve le capteur optique). b. Caractéristiques Dans le choix d’une caméra de vision, il faut notamment considérer le type de capteur (monochrome ou couleur, linéaire ou matricielle), la dynamique – nombre de bits sur lesquels est codé le niveau de gris. La plupart des caméras offre une dynamique de 8 bits. Notons que les modèles utilisés dans l’industrie électronique Ŕcontrôle des waferoffre une dynamique de 16 bits -, la résolution et la vitesse d’acquisition. Le choix, comme toujours, est dicté par l’application. Mais suivant les cas d’utilisation, on privilégie alors leur robustesse, leur résolution ou encore leur sensibilité.

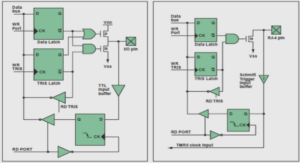

Acquisition par une caméra On s’intéresse ici à l’interfaçage des caméras avec les systèmes informatiques. Actuellement, les interfaces matérielle et logicielle sont normalisés. On retient 2 standards de périphériques systématiquement intégrés sur les PC et les Mac. – USB 2.0 : C’est une interface entrée-sortie beaucoup plus rapide que les ports série standards. – IEEE1394 : norme communément proposé avec les caméras numérique. Les produits portent souvent le label FireWire (Apple) ou i.Link (Sony). Les protocoles numériques actuels sont en effet limités en termes de distances : 5m pour l’USB et 10m pour l’IEEE 1394a. L’IEEE 1394 est très populaire dans les systèmes industriels de vision par une machine. C’est une interface dédiée aux applications professionnelles grâce à ses nombreux paramètres de contrôle et à son taux de transfert des données adapté au transfert d’images. Il s’avère plus rapide que l’USB 2.0 mais plus lent que l’USB 3.0. L’analogique est privilégié dans le cas où la caméra est très éloigné du système de traitement. Une autre alternative, plus récent, est le Gigabit Ethernet (l’interface est native sur certains caméras numérique) : Les données sont transmises avec un débit de 1 Gb/s à des distances allant jusqu’à 100 mètres, et elles arrivent dans le PC à travers une simple carte réseau. Au niveau logiciel, on a DirectShow pour Windows, QuickTime pour Mac OSX et Video4Linux pour Linux. d. Modèle d’une caméra Cette modélisation consiste à décrire le modèle, souvent géométrique, associé au processus de saisie d’image à l’aide d’une caméra. Le modèle géométrique d’une caméra peut être caractérisé par 2 transformations : Une projection qui transforme un point de l’espace (3D) en un point image (2D) Une transformation d’un repère métrique lié à la caméra à un repère lié à l’image. (matrice) 9 Le centre de projection F peut être placé devant ou derrière le plan image. Considérons un repère attaché à la caméra (figure) : Soient x, y, z les coordonnées de B. Figure I.4 : Modèle géométrique d’une caméra Les coordonnées de b, projection de B dans le plan image sont : x’= , y’= , z’=f (I.1) Les points images sont mesurés en pixels dans un repère bidimensionnel u-v associé à l’image. Soient , les coordonnées de F dans le repère image (mesurées en pixels), le facteur d’échelle verticale (pixels/mm) et le facteur d’échelle horizontal. On a : De ces 2 systèmes d’équations, nous pouvons écrire les équations du modèle géométrique de la caméra, soit la relation entre les coordonnées caméra (x, y, z) du point observé et les coordonnées images (u, v) du même point : : sont les 4 paramètres du modèle, intrinsèque à la caméra, qui vont être estimés par calibrage. Notons que la situation d’une caméra est définie par la position de son centre optique C et l’orientation de son axe optique, ce qui nous donne son paramètre extrinsèque. (I.2) 10 e. Informations visuelles ~ images L’image, telle qu’on la voit, est une représentation d’objets réels, un ensemble structuré d’informations qui, après interprétation, a une signification. Mais formellement, C’est une fonction d’intensité 2D f(x, y) ou x, y sont les coordonnées spatiales et la valeur de f est proportionnelle au niveau de gris. L’image est numérique si elle est manipulée sous forme binaire, c’est-à-dire représentée par un signal échantillonné. [2] Elle est représentée par une matrice I (m, n) ou la ligne et la colonne identifie un point dans l’image et la valeur de chaque élément donne l’intensité lumineuse perçue par le capteur sur ce pixel. Une image numérique est caractérisée essentiellement par : – Sa définition : nombre de pixels – Sa résolution : nombre de pixels par unité de longueur – Sa profondeur : nombre de couleurs ou de niveau de gris Figure I.5: Représentation matricielle d’une image A un niveau plus élevé, on peut considérer une image comme étant constituée de plusieurs zones homogènes représentant des objets. Un flux d’images ou un signal vidéo peut donc nous donner les interactions entre ces objets dans le temps. Notons que l’histogramme est un graphique statistique permettant de représenter la distribution des intensités des pixels d’une image. 11 L’histogramme H de l’image I est défini pour i Є | | : ( ) [ ] où pour chaque pixel dans l’image, ( ) ( ) donne la probabilité que la couleur du pixel soit ci . L’histogramme complet consiste donc à compter les pixels de même couleur sur une image.

Configuration de la caméra

Eclairage Certaine situation nécessite l’utilisation d’un éclairage (à lumière visible ou à infrarouge). Il peut être embarqué ou déporté selon la nécessité.

Position – Caméra embarqué : ou « Eye-in-Hand »

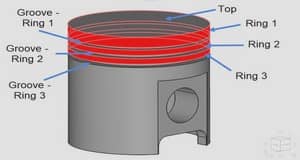

La caméra est placée sur l’organe terminal du bras manipulateur – Caméra déportée ou « Stand-Alone ». La caméra est fixée ailleurs et regarde la scène, appelé aussi « Hand-to-eye » Figure I.6 : Différents configurations de caméra : embarqué, déporté c. Nombre On peut utiliser une ou plusieurs caméras selon le degré de perception requis, soit : Une caméra monoculaire qui permet seulement une perception 2D Une caméra binoculaire : 2 caméras forment une paire stéréo offrant le nécessaire sur la perception 3D. Un système multi-caméra : plus complexe et gourmand en ressources mais offre une grande possibilité.

REMERCIEMENTS |