La recherche d’information

Le paradoxe de la RI

Ce qui est paradoxal dans la RI c’est qu’elle peut traduire : – Un besoin de références bibliographiques pour structurer et étayer sa connaissance et ses idées ; – Directement un besoin de connaissances, c’est-à-dire combler une lacune. Cependant dans ce dernier cas, la prise de conscience de ce besoin, ou manque informatif, découle d’une expérience du domaine 1 . Pour comprendre son besoin d’informations, il faut avoir déjà effectué un panorama du champ de connaissances (Boubée et al., 2005). Si nous explicitons différemment les choses, pour comprendre son ignorance, il faut déjà avoir commencé à chercher. Y. F. Le Coadic définissait cet état de connaissance : « nous en savons assez pour savoir que nous avons un besoin d’information, mais nous n’en savons pas assez pour pouvoir poser les bonnes questions (Le Coadic, 2008) ». Cette réflexion peut être illustrée par la citation de l’en-tête de chapitre attribuée à Socrate :Tout ce que je sais, c’est que je ne sais rien. L’une des premières difficultés pour les usagers est d’identifier les sources pertinentes et d’avoir une vision claire des contenus. Nous allons dans cette première partie étudier dans le détail les différents aspects de la recherche d’information dans les systèmes numériques. Nous étudierons les interfaces de recherche d’information et les mécanismes qui y sont associés. 1. Nous voyons le détail du besoin d’information et les aspects psyscho-cognitifs qui y sont liés dans le chapitre 5 « Les écoles de pensées en RI : Processus et Cognition ».

Concepts, modèles et méthodes en RI

Concepts, modèles et méthodes en RI Internet offre une vaste collection de documents, et son utilisation comme source d’informations est évidente et est devenue très populaire. Comme l’ont souligné et analysé Dennis et al. (2002), il y a pléthore de technologies de recherche d’information en ligne, qui peuvent principalement être classées en quatre catégories : 1. Recherche par mots clés, sans aide. Un ou plusieurs termes de recherche sont entrés et le moteur de recherche renvoie une liste classée des résumés de documents hyperliés. 2. Recherche assistée. Le moteur de recherche produit des suggestions ou recommandations basées sur la requête initiale de l’utilisateur. 3. Recherche par classification. L’espace d’information est divisé en une hiérarchie de catégories, où l’utilisateur navigue du générique vers le spécifique. 4. Requête par l’exemple. L’utilisateur sélectionne un élément intéressant d’un hypertexte, qui est ensuite utilisé comme base d’une nouvelle requête. Nous ajouterons à cela une cinquième catégorie, la recommandation qui propose de l’information potentiellement intéressante en fonction de l’usager et/ou du contexte de recherche. Les outils de recherche d’information se divisent en deux catégories radicalement distinctes. Les portails de recherche, ou annuaires web sont des sites Internet qui proposent des liens vers un florilège de sites repérés par des experts d’un domaine pour leur qualité. Les moteurs de recherches sont des systèmes complexes permettant de trouver des ressources dans un corpus numérique. Ce corpus peut être l’Internet dans sa globalité, une base de connaissances ou un seul site web.

LA RECHERCHE D’INFORMATION

Portails de connaissance

Un portail de connaissance est un site de référence dans un domaine précis ou une page hypertexte dédiée à une communauté particulière. Ce site se présente sous la forme d’un ensemble de pages web hyperliées. Un portail peut être perçu comme un point d’entrée sur un panel de ressources autour d’un thème commun. Souvent, ces portails offrent une vingtaine de catégories pour le premier niveau de la classification. Le type des documents référencés et agrégés importe moins que leur spécificité commune : la thématique. Le plus souvent, ces indexations procèdent d’une intervention humaine. C’est le cas des portails spécialisés de Wikipédia . En effet, l’encyclopédie participative en ligne possède un portail d’accès pour chaque grande thématique. Ces thématiques sont animées par des groupes d’intérêt, qui compilent des hyperliens vers les articles au sein des portails. Un autre exemple de portait particulièrement intéressant, parce que géré manuellement, était l’annuaire Google dédié à l’informatique. Une hiérarchie de sujets prédéfinis comme l’informatique, le sport, l’art ou la musique est maintenue et enrichie de manière manuelle. D’après Eissen et Stein (2002), ces hiérarchies statiques ne sont pas satisfaisantes à deux égards : 1. elles nécessitent un effort de maintenance humaine considérable ; 2. pour des sujets particulièrement spécifiques, les catégories de navigation génériques, ou points d’entrée, sont inutiles et allongent considérablement le processus de recherche. Ces deux points sont indéniables. À moins de justifier le recours à un comité d’experts par sa préexistence (certains sites internet sont créés par un comité d’experts, c’est le cas d’IEEE ou d’ACM), cette méthode est onéreuse et chronophage. De plus, l’accès à l’information pointue est ralenti, voire rendu malaisé si la classification n’est pas triviale. Ce dernier point peut contrevenir avec l’immuable règle des trois clics (Scapin et Bastien, 1997) qui situe le seuil de tolérance d’un usager de système d’informations à un maximum de trois clics pour trouver l’information désirée dans un hypertexte (Sottet et al., 2005).

Moteurs de recherche

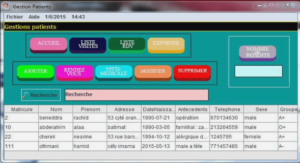

Un moteur de recherche est un outil dont l’interface permet de localiser une information dans une base de données à partir d’une requête. Originellement, les moteurs de recherche étaient des programmes installés localement sur les ordinateurs et ils consultaient, soit des bases locales, soit des bases distantes à travers des protocoles tels le FTP ou Gopher. Avec l’émergence du protocole HTTP, de nouveaux types de moteurs de recherches apparurent. Il s’agit d’une base de données indexant le contenu des pages référençables sur le web visible. Cette base est alimentée par un robot qui parcourt en permanence l’Internet. Modèle fonctionnel Curt Franklin expliquait qu’un moteur de recherche est composé de quatre parties principales (cf. figure 3.3 1 ) qui sont détaillées ci-dessous (Franklin, 2000) : 1. Un robot collecteur (web crawler) qui parcoure l’Internet de page en page. Un robot d’indexation est également appelé crawler ou spider. Il s’agit d’une analogie à une araignée qui parcourt inlassablement la toile, se déplace dans le web de site en site pour en collecter le contenu. Le contenu et les URL sont intégrés à une base de connaissances pour être traités. 2. Un indexeur chargé d’archiver les pages et d’en extraire les termes clés. Les URL des pages et les mots clés seront ensuite intégrés dans une base de données associative. L’indexation des pages repose sur les métadonnées collectées et celles calculées (mots clés calculés par traitement automatique du langage). Le système confronte les mots clés proposés par le webmestre éditorial et les termes émergeant de calcul statistiques. Un système de pondération permettra de faire l’équilibre entre ces données et de proposer des termes représentatifs du contenu de la page. 3. Un index inversé qui est une deuxième entrée sur la base de connaissance qui associe à chaque concept l’ensemble des URL des documents qui sont pertinents.