Cours les approches basées sur les techniques de Bootstrappin, tutoriel & guide de travaux pratiques en pdf.

Méthodologies pour la génération de scénarios économiques

Si nous nous plaçons dans le même cadre d’analyse que celui de la sous-section précédente, nous pouvons dire que cette partie vise à répondre à la question suivante: comment pouvonsnous déterminer la valeur d’un nœud. Pour cela, différentes méthodologies, ayant pour finalité la génération de scénarios économiques, peuvent être trouvées dans la littérature (cf. Kaut et Wallace [2003] et Mitra [2006]). Il est proposé dans cette sous-section de les classer en quatre groupes: les approches basées sur l’échantillonnage, les approches basées sur le matching des propriétés statistiques, les approches basées sur les techniques de Bootstrapping et les approches basées sur l’Analyse en Composantes Principales. Ce dernier groupe n’est pas indépendant des autres comme nous allons le voir dans ce qui suit.

Les approches basées sur l’échantillonnage

Ces approches peuvent être classées en deux sous catégories : l’échantillonnage pur univarié (ou traditionnel) et l’échantillonnage à partir de marginales et de corrélations spécifiées. Cette dernière a le mérite de générer des scénarios dans lesquels la corrélation entre les variables converge vers celle ciblée par le modélisateur.

L’échantillonnage pur est la méthode de génération de scénarios la plus connue. A chaque nœud de l’arbre de scénarios, différentes valeurs sont tirés de façon aléatoire à partir du processus stochastique{ } t ξ . Cela se fait soit par un tirage direct à partir de la distribution de{ } t ξ , soit par l’évolution du processus selon une formule explicite: ( ) ttt ,z εξ ξ =+ 1.

Dans ce cadre, la dynamique de plusieurs variables financières peut être supposée suivre un processus stochastique de type mouvement brownien géométrique, ou bien l’une de ses variantes. Les scénarios d’évolution de ces variables sont ainsi simulés à partir des hypothèses sur la discrétisation d’un processus brownien géométrique définit.

Il est ainsi possible de simuler des processus stochastiques sur un intervalle de temps donné, en attribuant des valeurs aléatoires au mouvement brownien et en calculant par la suite ( ) tS.

Les méthodes traditionnelles d’échantillonnage d’une variable aléatoire permettent de constituer des échantillons seulement à partir d’une variable aléatoire univariée ; lorsque nous voulons tirer un vecteur aléatoire (correspondant à différentes variables), on aura besoin de tirer chaque composante marginale (chaque variable) de façon séparée pour les rassembler ensuite. Le résultant obtenu sera un vecteur de variables aléatoires indépendantes.

Concernant la convergence vers les moments statistiques souhaités (moyenne, variance, etc.), il existe différentes méthodes pour améliorer l’algorithme de l’échantillonnage pur. Nous pouvons par exemple utiliser les méthodes de quadrature pour l’intégration ou les suites à discrépance faible (cf. Pennanen et al. [2002]). Pour les distributions symétriques il est possible d’utiliser les échantillonnages antithétiques. Une autre méthode pour améliorer la méthode d’échantillonnage pur est d’ajuster l’arbre obtenu de façon à avoir les valeurs cibles de la moyenne et de la variance (cf. Cariňo et al. [1994]).

Les approches basées sur le matching des propriétés statistiques

Dans les situations où il n’y a pas d’hypothèses sur la distribution marginale du processus de génération de scénarios, les approches basées sur le matching des propriétés statistiques, en particulier les moments, sont les plus adaptées. Un processus de génération des scénarios par le matching des moments s’intéresse souvent aux trois ou aux quatre premiers moments de chacune des variables projetées (moyenne, variance, skewness, kurtosis) ainsi qu’à la matrice de corrélation.

Ces méthodes peuvent être étendues à d’autre propriétés statistiques (tel que les quantiles, etc.). Le générateur de scénarios par le matching des moments va ensuite construire une distribution discrète satisfaisant les propriétés statistiques sélectionnées. Par exemple, Hoyland et al. [2003] commencent par spécifier le nombre minimal de scénarios qu’il faut générer pour ensuite obtenir l’arbre de scénarios par une optimisation non linéaire, où l’objectif est de minimiser l’erreur entre les moments théoriques de la variable et ceux fournis par l’arbre.

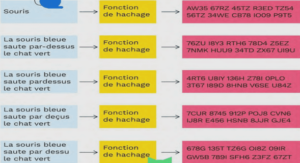

Les approches basées sur les techniques de Bootstrappin

g Il s’agit des approches les plus simples pour générer des scénarios en utilisant seulement les données historiques disponibles sans aucune modélisation a priori de la dynamique d’évolution des variables du GSE (cf. Albeanu et al. [2008]). Le Bootstrapping se base essentiellement sur la constitution d’échantillons à partir des données observées. Dans ce cadre, les valeurs de chaque scénario représentent un échantillon de rendements d’actifs obtenu par un tirage aléatoire de certains rendements observés déjà dans le passé.

Par exemple, afin de générer des scénarios de rendement sur les dix prochaines années, un échantillon de 120 rendements mensuels tirés aléatoirement sur les 120 rendements des dix dernières années est utilisé. Ce processus est répété un certain nombre de fois afin de générer plusieurs scénarios possibles dans le futur. Autrement, dans le cas où nous avons k actifs à projeter, et en supposant qu’un historique de p périodes est disponible, nous tirons avec remise un entier entre 1 et p et nous prenons toutes les valeurs des k actifs à cette même date de façon à tenir compte de la corrélation historique entre ces derniers.

L’utilisation de l’Analyse en Composantes Principales

L’Analyse en Composantes Principales (ACP) est une méthode générique d’analyse de données ayant plusieurs dimensions (cf. Bouroche et al. [1980]). Elle permet l’identification des facteurs clés régissant les tendances de ces données et de réduire leur dimension tout en conservant le plus d’information possible.

Pour cela, l’ACP se base sur l’identification des vecteurs propres, des valeurs propres et des covariances. En effet, il s’agit d’une méthode descriptive qui dépend d’un modèle géométrique plutôt que d’un modèle probabiliste. L’ACP propose de réduire la dimension d’un ensemble des données (échantillon) en trouvant un nouvel ensemble de variables plus petit que l’ensemble original des variables, qui néanmoins contient la plupart de l’information de l’échantillon.

Autrement dit, pour un ensemble de données dans un espace à N dimensions, nous recherchons un sous-espace à k dimensions (défini par k variables) tel que la projection des données dans ce sous-espace minimise la perte d’information. Ces k variables seront appelés composantes principales et les axes qu’elles déterminent axes principaux. L’implémentation numérique de la méthode ACP est ainsi accessible. En pratique, l’ACP a pour objet de réduire le nombre des variables de départ du modèle pour ensuite appliquer une approche traditionnelle de génération de scénarios (parmi celles proposées ci-dessus) pour les composantes principales.