Télécharger le fichier original (Mémoire de fin d’études)

Indexation globale des images

Introduction

L’image est une représentation visuelle ou mentale de quelque chose, objet, être vivant ou con-cept. Concrétement, une image en Vision est une représentation spatiale de l’énergie réfléchie par des objets physiques présents dans le champ de vue du capteur (oeil pour l’Homme, caméra pour un Robot).

Des traitements comme la transformée de Fourier permettent de représenter les pixels de l’image selon des modèles périodiques qui sont caractérisés par leurs fréquences et leurs directions. Ces éléments sont souvent exploités en indexation pour représenter l’objet dans des structures de données sous forme d’arbres à titre d’exemple.

Le calcul des descripteurs d’images par apparence, nécessite de déterminer les caractéris-tiques utiles dans l’image sur lesquelles les futures opérations vont être appliquées.

Nous présentons une nouvelle méthode d’indexation d’image en utilisant des caractéris-tiques globales qui decrivent la couleur et la texture (RBD07).

Récupération d’images par leur contenu

La thématique appelée Content Based Image Retrieval (CBIR) traite du problème de sélec-tionner dans une base d’images, celles qui répondent à une requête, par exemple “Sortir les images d’environnement routier”. Les méthodes de CBIR se fondent sur l’extraction des carac-téristiques importantes des images. Ces caractéristiques peuvent être soit locales soit globales. Dans la suite de ce mémoire, nous allons appliquer ces informations pour la localisation et la navigation d’un robot. Mais avant, nous allons décrire notre méthode pour extraire des caractéristiques globales à partir d’images couleur. Les images en couleur texturées sont por-teuses d’informations riches et leurs contenus peuvent les décrire entièrement. Nous rappelons qu’avant que le concept de CBIR ne soit mis en oeuvre en 1992 par T. Kato (Wik), la recherche dans les bases de données images utilisait des propriétés textuelles. Les techniques et les out-ils de CBIR sont inspirés des domaines de la statistique, de la reconnaissance de formes, du traitement de signal et de la vision par ordinateur. De plus, en CBIR , les mesures statistiques de similarité entre les représentations sont corrélées avec la similarité subjective visuelle.

Le processus de CBIR peut être modélisé par un modèle en 4 couches, comme le montre la figure 1.1. Les étapes sont: l’indexation par le contenu, l’extraction des caractéristiques, la compilation et la recherche par requête. Les invariants peuvent être extraits en utilisant soit les conditions extrinsèques soit les propriétés intrinsèques ce qui est plus pratique.

Pour mesurer la couleur et la texture, nous avons choisi l’approche physique. Dans cette approche, la luminance de l’image est représentée comme une onde électromagnétique. Le processus d’observation est une intégration de la densité de l’énergie de cette onde dans les dimensions spatio-spectrales. Dans la théorie des espaces d’échelles, les sondes ou caractéris-tiques doivent avoir une forme gaussienne pour éviter les détails extérieurs lorsque l’échelle est plus grossière. On trouve dans la littérature plusieurs espaces d’échelle, tels que: Poisson, Bessel et Relativiste. L’espace d’échelle gaussien est cependant linéaire et lié au processus de diffusion linéaire.

Attribut couleur

La luminance ou les valeurs du tri-stimuli peuvent être utilisées directement ou via quelques transformations dans d’autres espaces de couleur pour extraire des informations sur le contenu de l’image.

La couleur peut être définie comme le résultat perceptuel de la lumière lorsqu’elle pénètre dans la rétine. Cette lumière a une longueur d’onde comprise entre 400 et 700 nm. Concernant la vision humaine, l’analyse de la couleur est basée sur la colorimétrie ou l’analyse du contenu spectral du stimulus trichromatique détecté par l’oeil; c’est le système XYZ qui décrit des couleurs conformes à ce que perçoit l’Homme. Par ailleurs, dans l’approche physique de la mesure de couleur, la luminance de l’image est représentée par une onde electromagnétique E(x; y; ).

Attribut texture

Dans une image, plusieurs régions sont caractérisées par des structures régulières comparables aux textures qui figurent dans certains vêtements que l’on voit au quotidien. Des chercheurs ont tenté de définir qualitativement la texture dans l’image. Par exemple Pickett considère que la texture est utilisée pour décrire des tableaux de variations de deux dimensions((Pic70)). Les éléments et les règles d’espacement ou d’arrangement peuvent être manipulés arbitrairement en gardant un indicateur de répétitivité. Pour sa part, Hawkins ((Haw70)) estime que la notion de texture dépend de trois ingrédients:

• un modèle local répété sur une large région par rapport à sa taille ;

• ce modèle consiste en un arrangement non aléatoire de parties élémentaires ;

• les parties sont des entités uniformes ayant appromativement la même dimension partout à l’intérieur de la texture.

Aussi, la texture est souvent caractérisée par la résolution des détails perceptibles dans l’image, qui peuvent être grossière ou fine; on peut parler de taux de grossièreté (coarseness). Par exemple, une pièce de vêtement en laine est plus grossière qu’une pièce de soie sous les mêmes conditions de visualisation. Le caractère plus ou moins grossier de la texture est relié à la période de répétitivité spatiale de la structure locale. Une période grande implique une texture grossière alors qu’une période plus petite implique une texture fine. Toutefois, cette mesure de grossièreté est insuffisante pour mesurer qualitativement la texture. Elle peut orienter les mesures de sorte que l’on puisse prendre les mesures élevées comme une référence à une texture grossière et vice versa.

En outre, la texture est une propriété de voisinage. Sa mesure est donc étroitement liée au voisinage d’observation.

Enfin, la texture artificielle consiste en un arrangement de symboles voire des segments de ligne, des points, des étoiles ou autres, placés sur un arrière plan neutre.

Etat de l’art sur les CBIR

Dans ((HHSH93)), l’ image est segmentée en 8 regions de couleurs homogènes et réduites à 24*24 pixels. Ces pixels sont directement utilisés dans l’appariemment. Pour faire le matching, premièrement une correspondance entre les régions dans la requête et la cible est trouvée. Les régions similaires dans l’autre image sont fusionnées. La similarité de la forme entre deux régions est basée sur le nombre de pixels qui sont superposés. La similarité de couleur entre deux régions est la distance dans l’espace HLS (Hue, Luminosité, Saturation) entre les régions à comparer. Dans l’approche proposée dans ((CO96)), les couleurs de chaque image sont quantifiées en 13 bins de couleurs. Six valeurs sont associées à chaque bin de couleur Une autre méthode ((CO96)) consiste à utiliser les attributs couleur et texture, la position et la forme des régions (blobs) et l’arrière plan. La couleur est représentée par 218 bins des coordonnées de couleur dans l’espace L*ab. La texture est représentée par le contraste et l’anisotropie dans les régions. La forme est représentée par la surface (excentricité et orientation).

Pour apparier, on utilise une décomposition en couleur singulière (SVD) pour projeter le vecteur d’histogramme en un sous espace de dimension inférieure. Les points résultants sont indexés par un R tree.

Le système ((OM95)) utilise une base de données de description de texte et d’autres élé-ments textuels comme la date et la position de la photo. Pour chaque image un histogramme de la couleur contenant seulement 20 bins est calculé.

Par ailleurs, dans ((BM00)), les caractéristiques utilisées sont les histogrammes sur la teinte et sur la luminance.

L’appariemment consiste à calculer la distance entre deux histogrammes de caractéristiques avec une distance L1, L2 ou Minkovsky. La distance entre deux images est la somme pondérée des distances entre les caractéristiques.

Développement d’un descripteur global d’image

Notre contribution consiste à développer un nouveau descripteur global qui s’inspire du concept de l’MPEG7. Nous combinons les deux attributs couleur et texture en proposant une formule qui mesure à la fois la couleur et la texture. Cela permet une meilleure représentation du contenu de l’image. Pour évaluer notre descripteur, nous avons développé un prototype de système CBIR qui permet de récupérer les images similaires à l’image requête en utilisant une distance appropriée. Notre méthode s’inspire du travail de Geusebroek et al (GdBSG01), où on effectue une segmentation par mesure de la couleur et de la texture par une gaussienne 3D. Nous utilisons le résultat qui montre que la sortie du filtre de Gabor a une nature de Rayleigh pour réduire la dimension de notre vecteur d’attribut.

Description de l’image par le modèle de couleur Gaussien

Nous avons utilisé dans notre approche les attributs couleur et texture pour décrire l’image. En effet, dans l’approche physique de la mesure de couleur, la luminance de l’image L est représentée par une onde électromagnétique E(x; y; ). Dans la figure 1.1 nous présentons les espaces d’échelle utilisés pour la mesure de la luminance de l’image.

Espaces d’échelle

C’est une théorie qui permet de manipuler la structure des images à différentes échelles. Elle introduit en fait le concept de lissage dans lequel une image est un élément dans une famille plus grande qui est celle des images lissées. Elle est gérée par la taille du noyau de lissage utilisé pour supprimer les détails fins. L’espace d’échelle gaussien est le plus utilisé car il permet plusieurs applications. Plusieurs opérateurs visuels peuvent être construits à partir de l’espace d’échelle gaussien. Il permet en plus d’assurer l’invariance à l’échelle nécessaire pour traiter la taille des variations dans les données. Et les espaces d’échelle permettent de gérer la variation de la distance entre un objet et la caméra selon plusieurs échelles.

Pour le cas de signaux 2D f(x,y), l’espace d’échelle est un ensemble de signaux définis comme la convolution de f(x,y) avec les noyaux gaussiens suivants :

L(x; y; t) = (gt f)(x; y)

tel que : 1 (x 2 + y2)

gt(x; y) = exp ( )

L est l’image f convoluée avec un espace d’echelle gaussien.

Et gt est le noyau gaussien. Le point virgule signifie que la convolution est faite uniquement selon les dimensions x et y. t n’est qu’un paramètre qui représente la variance du noyau gaussien. Théoriquement, nous définissons une observation comme l’intégral de la densité de l’énergie E(x,y) et de l’espace d’échelle gaussien. L’intèrêt de la gaussienne est d’éviter de supprimer les détails quand l’échelle est grande.

Mesure de la couleur: modèle de couleur gaussien de Koendering

Dans ce qui suit nous présentons l’outil de mesure de la couleur qui nous a permis d’avoir notre descripteur.

L’idée du modèle est que la structure spatiale peut être extraite à partir de données de l’environnement en mesurant des dérivées à un certain ordre. De plus, l’énergie spectrale peut être approximée par le développement de Taylor au point 0 une mesure physique avec une aperture est mathématiquement exprimée par : e(x; ) = e(x; 0) + e (x; 0)(0) + 1 e (x; 0)(0)2 + O((3))

Dans notre cas, la couleur est mesurée par l’intégration de l’ énergie électromagnétique sur une bande spectrale. Le modèle de couleur Gaussien est défini par le développement de la distribution de l’énergie au dérivées second ordre. Cette approche reflète le processus de vision humain. Le modèle gaussien mesure les coefficient du modèle de Taylor. La relation entre le modèle de couleur gaussien et celui de l’oeil humain est donné par :

0 ee 1 = 0 00::019 0 0:16 1 0 Y 1

019 0:048 0:011 X

les@ e 0:047 0:052 0 Z

dérivéesA zéro@ (luminance), premier et secondA@ de laA fonction gaussienne sont données en

fonction de la sensitivité de la longueur d’onde. Selon Koendering, la longueur d’onde centrale est 520nm et l’ecart type est de 55 nm.

Mesure de la texture

La texture est importante dans la reconnaissance de forme. Daugman (Dau80) a généralisé la fonction de Gabor pour modéliser le champ réceptif dans la vision humaine. Généralement, le filtre de Gabor peut être vu comme la modulation de l’enveloppe Gaussienne et du plan sinusoïdal d’une fréquence et orientation particulière.

Un filtre de Gabor est un filtre linéaire utilisé dans le traitement d’images pour la détection de points. Sa réponse impulsionnelle est définie par une fonction harmonique multipliée par une fonction gaussienne. En raison des propriétés de convolution (théorème de convolution), la transformée de Fourier de la réponse impulsionnelle d’un filtre de Gabor est la convolution de la transformée de Fourier de la fonction harmonique et de la transformée de Fourier de la fonction gaussienne.

Table des matières

Introduction générale

1 Indexation globale des images

1.1 Introduction

1.2 Récupération d’images par leur contenu

1.2.1 Attribut couleur

1.2.2 Attribut texture

1.2.3 Etat de l’art sur les CBIR

1.3 Développement d’un descripteur global d’image

1.3.1 Description de l’image par le modèle de couleur Gaussien

1.3.2 Espaces d’échelle

1.3.3 Mesure de la couleur: modèle de couleur gaussien de Koendering

1.3.4 Mesure de la texture

1.3.5 Mesure conjointe de la couleur et de la texture

1.4 Descripteur Couleur Texture

1.4.1 Implémentation du descripteur couleur-texture

1.5 Conclusion

2 Indexation locale des images

2.1 Introduction

2.2 Etat de l’art

2.2.1 Indexation par apparence

2.2.2 Formulation mathématique

2.2.2.1 Changement d’échelle

2.2.2.2 Rotation d’images

2.2.3 Le détecteur de Moravec

2.2.4 Détecteur de Harris et ses variantes

2.2.5 Détecteur de régions saillantes

2.2.6 Filtres orientables (Steerable filters)

2.2.7 Descripteur SIFT

2.3 Développement d’un descripteur couleur invariant à l’échelle et à la rotation

2.3.1 Nature de notre détecteur-descripteur

2.3.2 Développement mathématique

2.3.2.1 Calcul d’un vecteur d’échelles caractéristiques

2.3.2.2 Calcul de l’orientation

2.3.3 Calcul du descripteur

2.4 Reconnaissance d’objets

2.4.1 Généralités

2.4.2 Résultats expérimentaux

2.4.3 Evaluation des performances

2.4.4 Répétabilité

2.4.5 Discussion :

2.5 Conclusion

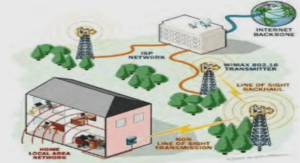

3 Localisation des robots mobiles à partir de radio-étiquettes

3.1 Introduction

3.2 Localisation

3.2.1 RFID

3.2.2 Etat de l’art sur la navigation par RFID

3.3 Localisation déterministe par RFID

3.3.1 Localisation par la méthode Range and Bearing

3.3.2 Localisation par des amers visuels ponctuels

3.3.3 Localisation stochastique par filtrage particulaire

3.4 Amélioration du recalage par localisation active

3.4.1 Discussion

3.5 Conclusion

4 Localisation et cartographie à partir d’amers visuels

4.1 Introduction

4.2 Introduction à la localisation et cartographie simultanées

4.3 Localisation par la vision

4.3.1 Localisation par odométrie visuelle

4.3.2 Localisation par amers

4.3.3 Localisation par indexation d’images

4.4 Principe et formulation mathématique du MonoSLAM

4.5 MonoSLAM par nos points d’intèrêt

4.5.1 Simulation

4.6 Navigation par fusion entre radio-étiquettes et points d’intérêt

4.7 Conclusion

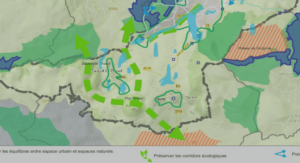

5 Cartographie des radio-étiquettes

5.1 Introduction

5.2 Modèles géométriques

5.2.1 Cartes métriques

5.3 Modèle topologique

5.3.1 Cartes topologiques

5.4 Grille d’occupation

5.5 Cartographie d’un environnement par des position de radio-étiquettes

5.5.1 Méthode déterministe

5.5.2 Méthode probabiliste

5.5.3 Discussion

5.6 Conclusion

Conclusions générale

Perspectives

Publications

Annexe

Bibliographie