Reconnaissance automatique de la parole

Cette partie est dédiée à la présentation des principes de la reconnaissance automatique de la parole. Le schéma de base étant une chaîne de traitements, nous présenterons donc dans un premier temps le traitement dans sa globalité avant de détailler chaque sous tâche spécifique. Pour chacune d’elles, nous décrirons quelques approches possibles en insistant sur les méthodes et algorithmes couramment utilisés de nos jours.

De l’onde au langage, schéma général

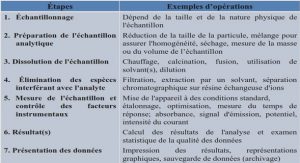

Le principe général a beaucoup évolué car, en passant d’une reconnaissance fondée sur l’exemple à une reconnaissance fondée sur le modèle, la suite de traitements s’est allongée. De façon générale, les systèmes de reconnaissance automatique de la parole actuels, à base de modélisation statistique .

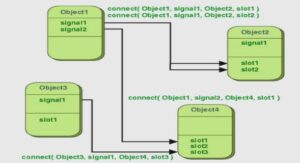

À partir d’un signal de parole, le premier traitement consiste à extraire les paramètres caractéristiques. Ces paramètres sont mis en entrée d’un module acoustique, ou un décodage acoustico-phonétique. Ce décodage acoustico phonétique peut produire à son tour une ou plusieurs hypothèses phonétiques associées en général à une probabilité pour chaque segment (une fenêtre ou une trame) de signaux de la parole. Ce générateur d’hypothèses locales est souvent modélisé par des modèles statistiques d’unités élémentaires de parole, par exemple un phonème. Pour entraîner des modèles acoustiques, nous apprenons les modèles des unités acoustiques d’un corpus étiqueté.

Le générateur d’hypothèses interagit avec un module lexical pour forcer le décodage acoustico-phonétique à ne reconnaître que des mots représentés dans le module lexical. Les modèles phonétiques sont représentés par un dictionnaire de prononciation (dictionnaire phonétique) ou par des automates probabilistes qui sont capables d’associer une probabilité à chaque prononciation possible d’un mot.

Pour la reconnaissance automatique de la parole continue grand vocabulaire, le générateur interagit avec un module syntaxique pour forcer le reconnaisseur à intégrer des contraintes syntaxiques, voire sémantiques. Ces contraintes sont souvent formalisées par des modèles de langage. Pour reconnaître ce qui est dit, on commence par chercher, grâce aux modèles d’unités acoustiques, l’unité qui est supposée avoir été produite, puis construisons, à partir du treillis d’unités acoustiques et d’un modèle statistique du langage, la suite de mots la plus probable.

Analyse acoustique et paramétrisation du signal

Au niveau acoustique, la parole apparaît physiquement comme une variation de la pression de l’air causée et émise par le système articulatoire [Boite 2000, Calliope 1989]. Ce signal continu est converti numériquement en intervalles de temps discret (phase d’échantillonnage), puis quantifié en valeurs discrètes d’amplitude (phase de quantification ou conversion analogique / numérique).

Pour la modélisation acoustique et pour le décodage acoustico-phonétique, le signal numérique n’est pas exploitable directement car la quantité de données est trop importante et beaucoup de ces données sont inutiles (telles que le bruit de fond) ou redondantes.

Pour réduire cette quantité de données et supprimer les informations inutiles, plusieurs algorithmes sont nécessaires. Le signal de parole est fortement non stationnaire [Boite 2000]. Généralement, une analyse spectrale, dont l’outil est la transformée de Fourier discrète, est effectuée environ toutes les 10ms sur une fenêtre (ou trame) de 10 à 20ms de signal vocal pondérées par une fenêtre de pondération (Hamming, Hanning, …). Dans la fenêtre de 10 à 20ms, on suppose que le signal vocal est suffisamment stable. On en extrait des coefficients, dits coefficients spectraux. Ensuite, d’autres coefficients (Mel-cepstrum par exemple [Davis 1980]) peuvent être dérivés de ces coefficients spectraux.

Suite à ces prétraitements, le signal est généralement transformé en une série de vecteurs comportant typiquement de 8 à 50 coefficients. Plusieurs types de coefficients, donc de représentations, sont couramment utilisés selon les systèmes et les besoins : ZCR (Taux de passage par zéro), Energie, MFCC (Mel Filter Cepstral Coefficients), LPC (Linear Prédictive Coding), PLP (Perceptual Linear Predictive), …Une présentation détaillée de ces coefficients se trouve dans [Rabiner 1978, Davis 1980, Boite 2000].

D’une façon générale, l’ensemble des paramètres extraits du signal fournit un vecteur de grande dimension. Il est alors courant de réduire la taille de ce vecteur en gardant le maximum d’informations utiles. Par exemple, proche de l’analyse en composantes principales, la LDA (Linear Discriminant Analysis) [Haeb-Umbach 1992, Balakrishnama 1999] est une méthode d’extraction de paramètres qui fournit une transformation linéaire de vecteurs-paramètres de dimension n dans un espace de dimension m < n de telle sorte que les individus appartenant à une même classe soient proches les uns des autres, et que ceux appartenant à des classes différentes soient éloignés.

Décodage acoustico-phonétique à base de modélisation acoustique

D’après [Haton 1991], un décodage acoustico-phonétique (DAP) est défini généralement comme la transformation de l’onde vocale, en unités phonétiques – une sorte de transcodage qui fait passer d’un code acoustique à un code phonétique- ou plus exactement comme la mise en correspondance du signal et d’unités phonétiques prédéfinies (opération de couplage / identification) dans lequel le niveau de représentation passe du continu au discret. Ce module est composé d’une première partie consistant à extraire les paramètres choisis pour représenter le signal, et d’une seconde partie qui, à partir de ces jeux de paramètres, apprend des modèles d’unités acoustiques ou décode le signal d’entrée, selon que l’on veuille apprendre ou reconnaître.

Modélisation acoustique

Les approches statistiques et les modèles probabilistes sont très utilisés, de nos jours, dans les systèmes de reconnaissance automatique de la parole. Ces approches, notamment celles basés sur les Modèles de Markov Cachés (HMM), ont atteint des performances remarquables avec des vocabulaires de plus en plus importants et une robustesse au bruit et à la variabilité des locuteurs de plus en plus grande [Rabiner 1993] Dans les années 70, l’approche consistait en un paradigme de reconnaissance de mots « par l’exemple ». Ces premiers systèmes fonctionnaient à base de patrons de vecteurs acoustiques ou « template-based systems » en anglais [Huang 2001]. Le principe consistait à faire répéter plusieurs exemples des mots à reconnaître et à les analyser sous forme de vecteurs acoustiques dans un patron. Ensuite, pour reconnaître un mot inconnu, il « suffisait » de comparer le jeu de vecteurs acoustiques extraits du signal avec les suites d’exemples appris (ou enregistrés) précédemment. Ce principe de base n’est cependant pas implémentable directement parce qu’un même mot peut être prononcé de nombreuses de façons différentes, en changeant le rythme de l’élocution. La superposition du signal inconnu aux signaux de base doit dès lors se faire en acceptant une certaine « élasticité » temporelle, formalisée mathématiquement par l’algorithme Dynamic Time Warping (DTW) [Silverman 1990]. Cette approche pionnière s’est rapidement confrontée aux grands problèmes de la reconnaissance automatique de la parole. Comment faire face à la variabilité due aux locuteurs et au contexte d’enregistrement, comment élaborer une construction sémantique et non simplement lexicale et donc comment gérer de très grands dictionnaires ? De tous ces obstacles sont apparus des unités acoustiques plus petites (en termes de temps) et les modèles probabilistes. Les unités acoustiques ne sont plus des mots mais des phonèmes. Le principe consiste alors à déduire des modèles de phonèmes plutôt que des exemples de mots. Ainsi, ces modèles sont beaucoup plus souples, dans le sens où ils couvrent beaucoup plus de variations et permettent la gestion de gros vocabulaires sans modifier le nombre d’unités acoustiques représentées. Les modèles peuvent être applicables pour n’importe quelle voix. Il est même possible de découper encore ces petites unités acoustiques au sein du modèle luimême. Enfin, ces unités acoustiques peuvent être non plus des phonèmes, mais des combinaisons de phonèmes, c’est-à-dire un phonème en fonction de son contexte. Par exemple, on modélisera le phonème [ε] suivi du phonème , ou le phonème [ε] suivi du phonème [ε], etc. au lieu du phonème [ε]. Nous parlons alors de polyphones: diphones, triphones ou même quintphones selon le nombre de contextes pris en compte.

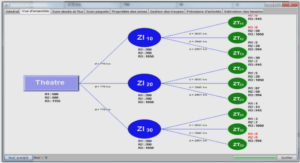

Pour la modélisation statistique acoustique, les modèles de Markov cachés (HMM) sont aujourd’hui utilisés dans un très grand nombre des systèmes de reconnaissance automatique de la parole. Chaque unité de parole est modélisée par un HMM. Dans le cas de petits lexiques, ces unités de parole peuvent être les mots. Dans le cas de grands lexiques, on préférera souvent utiliser des modèles de phonèmes (ou polyphones), ce qui limitera le nombre de paramètres à estimer. Dans ce dernier cas, lors de la reconnaissance, les mots seront construits (dynamiquement) en termes de séquences de phonèmes et les phrases en termes de séquences de mots.

Les HMMs supposent que le phénomène modélisé est un processus aléatoire et inobservable qui se manifeste par des émissions elles-mêmes aléatoires. Cette approche markovienne offre une flexibilité séduisante de modélisation pour un phénomène aussi complexe que la parole.

Modèles de Markov Cachés

Les modèles de Markov cachés sont apparus dans la problématique de la reconnaissance automatique de la parole dans les années 70 [Baker 1975, Jelinek 1976]. L’idée sous-jacente est que la parole peut être caractérisée par un processus aléatoire dont les paramètres peuvent être estimés d’une manière appropriée. Les modèles HMM ont prouvé leur efficacité dans de nombreux domaines de la reconnaissance automatique de la parole. Cependant, les modèles ont été améliorés au fil des recherches pour repousser leurs limites intrinsèques, particulièrement en intégrant des notions de corrélation entre trames et de modélisation de trajectoires.

Un modèle de Markov discret est un automate stochastique à nombre d’états fini N [Rabiner 1993]. Un processus aléatoire se déplace d’état en état à chaque instant et on note qt l’état atteint par le processus à l’instant t.

Introduction |