Développement et validation de modèles QSAR

Modélisation

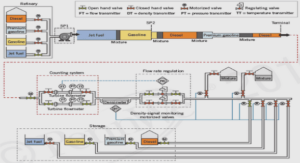

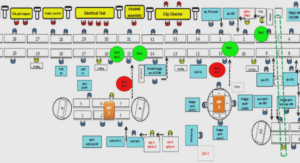

La modélisation par apprentissage consiste à trouver le jeu de paramètres qui conduit à la meilleure approximation possible de la fonction de régression, à partir des couples entrées/ sortie constituant l’ensemble d’apprentissage (ou de calibrage) ; le plus souvent, ces couples sont constitués d’un ensemble de vecteurs de variables ( descripteurs dans le cas de molécules) { xi , i = 1……..n}, et un ensemble de mesures de la grandeur à modéliser {y (xi ), i= 1………….n} [53]. La détermination des valeurs de ces paramètres nécessite la mise en œuvre de méthodes d’optimisation qui diffèrent selon le type de modèle choisi. Dans cette thèse deux types de méthodes ont été exploitées. IV-2 Régression linéaire multiple (MLR) [82-84] La régression linéaire multiple est la méthode la plus simple de modélisation, elle consiste à rechercher une équation linéaire par rapport à ses paramètres reliant la variable à modéliser au vecteur d’entrées x = {xk, k = 1………….p}. Ces entrées peuvent être des fonctions non paramétrées, ou à paramètres fixés, de ces variables. L’équation linéaire recherchée est de la forme : 1 , q k k k g x x X (47) Où 𝜃 = {𝜃k, k=1……………..p} est le vecteur des paramètres; X, matrice des observations de taille (n, p), est définie comme la matrice dont les éléments de la colonne k prennent pour valeurs les n mesures de la variable k. Pour chaque élément i de la base d’apprentissage, le résidu est défini comme la différence entre la valeur de la grandeur à modéliser pour cet élément i et l’estimation du modèle : , i i R y g x i (48) L’apprentissage est réalisé par minimisation de la fonction de coût des moindres carrés, qui mesure l’ajustement du modèle g aux données d’apprentissage : 2 2 2 1 1 , N N i i i i i J R y g x y X (49) La fonction J(𝜃) est une fonction positive quadratique en 𝜃: son minimum est unique. Il est donné par : IV. Développement et validation de modèles QSAR 41 1 T T mc X X X y (50) Les paramètres 𝜃k sont appelés coefficients de régression partielle ; chacun d’eux mesure l’effet de la variable explicative xk concernée sur la propriété modélisée lorsque les autres variables explicatives sont maintenues constantes. La régression linéaire est facile à mettre en œuvre, et les coefficients 𝜃k obtenus peuvent être interprétés : ils mesurent l’influence de chacune des variables sur les grandeurs étudiées. Cependant, il est souvent nécessaire d’avoir recours à des modèles de plus grande complexité. IV-3 Réseaux de neurones artificiels [85-88] Les réseaux de neurones formels [85] étaient, à l’origine, une tentative de modélisation mathématique des systèmes nerveux, initiée dès 1943 par McCulloch et Pitts [86]. Un neurone formel est une fonction non linéaire paramétrée, à valeurs bornées, de variables réelles. Le plus souvent, les neurones formels réalisent une combinaison linéaire des entrées reçues, puis appliquent à cette valeur une « fonction d’activation » f, généralement non linéaire. La valeur obtenue y est la sortie du neurone. Un neurone formel est ainsi représenté sur la Figure 8. Figure 8 : Représentation d’un neurone formel Les k k n 1….. x sont les variables, ou entrées du neurone, et les k k n 0…… sont les paramètres, également appelés synapses ou poids. Le paramètre 0 est le paramètre associé à une entrée fixée à 1, appelée biais. L’équation du neurone est donc : 0 1 n k k k y f x (46) Les fonctions d’activation les plus couramment utilisées sont la fonction tangente IV. Développement et validation de modèles QSAR 42 hyperbolique, la fonction sigmoïde et la fonction identité. Les neurones seuls réalisent des fonctions assez simples, et c’est leurs compositions qui permettent de construire des fonctions aux propriétés particulièrement intéressantes. On appelle ainsi réseau de neurones une composition de fonctions « neurones » définies cidessus. La Figure 9 représente un réseau de neurones non bouclé, organisé en couches (perceptron multicouche), qui comporte Ne variables, une couche de Nc neurones cachés, et Ns neurones de sortie Figure 9 : Représentation d’un réseau de neurones À chaque connexion est associé un paramètre. Les sorties du réseau sont donc des fonctions non-linéaires de ses variables et de ses paramètres. Le nombre de degrés de liberté, c’est-à- dire de paramètres ajustables, dépend du nombre de neurones de la couche cachée ; il est donc possible de faire varier la complexité du réseau en augmentant ou en diminuant le nombre de neurones cachés.

Propriétés des réseaux de neurones

Les réseaux de neurones ont pour but de modéliser des processus, à partir d’exemples de couples entrées / sorties. Ils ont la propriété d’approximation universelle : un réseau de neurones comportant un nombre fini de neurones cachés, de même fonction d’activation, et un neurone de sortie linéaire, est capable d’approcher uniformément, avec une précision arbitraire, toute fonction bornée suffisamment régulière, sur un domaine fini de l’espace de ses variables. De plus, il s’agit d’approximateurs parcimonieux : une approximation par un réseau de neurones nécessite en général moins de paramètres que les approximateurs usuels. Le nombre de paramètres nécessaires pour obtenir une précision donnée augmente en effet linéairement avec le nombre de variables pour un réseau de neurones, alors qu’il croît exponentiellement pour un modèle linéaire par rapport aux paramètres. Cette propriété est très importante, car les réseaux de neurones demandent de ce fait moins d’exemples que d’autres approximateurs pour l’apprentissage.

Développement et validation de modèles QSAR

Apprentissage des réseaux des neurones

Considérons un ensemble d’apprentissage, constitué de n couples entrées / sorties, c’est-à-dire d’un ensemble des variables , 1….. i y x i n et d’un ensemble de mesures de la grandeur à modéliser , 1….. i y x i n .Pour une complexité donnée, l’apprentissage s’effectue par minimisation de la fonction de coût des moindres carrés, définie par : 2 1 1 ( ) ( ) ( , ) 2 N i i j J y x g x (47) La minimisation de cette fonction s’effectue par une descente de gradient. Cet algorithme a pour but de converger, de manière itérative, vers un minimum de la fonction de coût, à partir de valeurs initiales des poids aléatoires. À chaque étape, le gradient de la fonction est calculé, à l’aide de l’algorithme de rétro-propagation. Puis les paramètres sont modifiés en fonction de ce gradient, dans la direction de la plus forte pente, vers un minimum local de J. Cette descente peut être effectuée suivant plusieurs méthodes : gradient simple ou méthodes du second ordre, dérivées de la méthode de Newton. Les méthodes du second ordre, généralement plus efficaces, sont les plus utilisées. La procédure de minimisation est arrêtée lorsqu’un critère est satisfait : le nombre maximal d’itérations est atteint, la variation du module du vecteur des paramètres ou du gradient de la fonction de coût est trop faible.