Nécessité d’évaluer l’exposition à L. monocytogenes

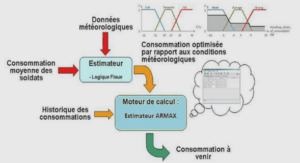

Construire un modèle d’évaluation de l’exposition à L. monocytogenes et de caractérisation des risques de listériose par consommation de salade de IVeme gamme Nous proposons de construire un modèle d’évaluation de l’exposition et de caractérisation des risques pour le couple L. monocytogenes/salade de IVeme gamme. Ce modèle est composée de plusieurs variables (ou paramètres) d’entrée et de sortie qui sont présentées dans la gure 1.2. L’objective est d’évaluer les variables de sortie qui sont les contaminations aux di¤érentes étapes de la chaîne alimentaire, l’exposition des consommateurs, le risque de listériose et le nombre de cas. Pour cela, il est nécessaire d’introduire dans le modèle des variables d’entrée, comme la contamination de la matière première entrant dans l’usine, les paramètres de croissance, les températures et les durées de conservation du produit pour les di¤érentes étapes constituant son circuit logistique (non détaillées dans la gure 1.2), la consommation de salade de IVeme gamme, etc. Nous choisissons de réaliser l’évaluation de l’exposition et des risques en deux temps. Dans un premier temps, les distributions des variables d’entrée sont déterminées en utilisant des modèles développés a n de rendre compte de la complexité du comportement des micro-organismes (contamination, croissance, etc). Dans un second temps, les distributions des variables de sortie sont déterminées à l’aide de méthodes de simulation ayant en entrée les distributions des variables établies précédemment. Il s’agit alors de prendre en compte dans l’estimation des variables d’entrée la variabilité et l’incertitude et de les propager séparément au cours des simulations a n d’intégrer ces deux dimensions dans l’évaluation de l’exposition et des risques. Le modèle développé doit aussi permettre d’évaluer les conséquences en terme de concentrations bactériennes, d’exposition et de risque de scénarios comme le retrait du chlore du procédé de fabrication des salades de IVeme gamme ou de scénarios futurs de gestion du risque pouvant être une meilleure gestion de la chaîne du froid. Ce modèle doit aussi être su¢samment générique pour être transposable aux di¤érents produits de la lière IVeme gamme et à d’autres lières alimentaires. Contamination de la matière première Réduction en L. monocytogenes lors du lavage Conditions de conservation temps/températures Répartition des bactéries du sachet aux quantités consommées Consommation française de salades de IVème gamme Relation dose/réponse population sensible/normale Caractéristiques de la population française Croissance de L. monocytogenes Variables d’entrée Contamination à l’entrée de l’usine Contamination à l’instant de la consommation prévalence/concentration dans les unités commerciales Consommation fréquence/quantité Exposition des consommateurs Risque des consommateurs Nombre de cas dans la population française Contamination à la sortie de la chaîne de fabrication Variables de sortie Fig. 1.2: Principaux composants du modèle d’évaluation de l’exposition et des risques lié à la présence de L. monocytogenes dans les salades de IVeme gamme

Intégrer dans l’évaluation des risques alimentaires des méthodes statistiques permettant de prendre en compte séparément la variabilité et l’incertitude

La variabilité représente la diversité et l’hétérogénéité de la réponse dans la population étudiée. Elle est intrinsèque à cette population et ne peut être réduite par un complément d’information à la di¤érence de l’incertitude qui représente l’ignorance partielle ou le manque de connaissances de l’évaluateur et qui peut être réduite par des données ou des études supplémentaires. L’incertitude totale est constituée de la variabilité et de l’incertitude. Ainsi tout phénomène biologique est intrinsèquement variable et la connaissance de ce phénomène ne peut être que partielle et cela même dans le cas d’information abondante. La statistique est la science adaptée à l’étude de la variabilité et de l’incertitude. Ainsi le Dr Daniel Schwartz 1994 déclare que « la variabilité est la raison d’être de la statistique » (Schwartz, 1994) ou encore Claudine Vergne dans son postulat pour les nouveaux programmes de statistique au lycée écrit « Prendre conscience de la variabilité d’un phénomène, ce n’est pas seulement constater que les résultats sont sujets à variation, c’est concevoir que, à notre échelle d’observation, les résultats sont nécessairement variables et imprévisibles, c’est accepter de prendre en compte les uctuations, c’est faire le deuil de la certitude et s’engager dans le monde de l’incertain. Renonçant à des connaissances assurées, on peut alors, par des méthodes statistiques, en suivant des raisonnements de type inductif, accéder à une maîtrise relative de l’incertitude pour estimer, prévoir et prendre des décisions avec risque consenti ». Il est alors indispensable lors de la réalisation d’analyse des risques alimentaires d’intégrer une mesure de l’incertitude totale. La commission du codex alimentarius recommande d’ailleurs de prendre en compte la variabilité du risque et d’évaluer les incertitudes autour des estimations du risque (Codex Alimentarius Commission, 2003). Le moyen de prendre en compte la variabilité d’un phénomène est d’opter pour l’approche probabiliste (ou distributionnelle) qui est l’utilisation de distributions de probabilité en opposition à l’approche déterministe (ou ponctuelle) qui caractérise le phénomène étudié par une seule valeur qui est en général la moyenne. Bien que l’approche probabiliste soit de plus en plus employée lors d’évaluation des risques, peu de travaux prennent en compte tout en les distinguant les deux dimensions de l’incertitude totale (variabilité et incertitude). La prise en compte séparée de la variabilité et de l’incertitude dans l’évaluation des risques alimentaires est l’un des enjeux de cette thèse. Les méthodes statistiques permettant de mener à bien ce travail sont présentées dans cette partie. L’approche bayésienne : une méthode statistique performante pour l’évaluation des risques et la prise en compte de la variabilité et de l’incertitude Le paradigme bayésien Considérons un modèle statistique où la loi de probabilité p(xj) qui génère les observations x est donnée par un modèle paramétrique particulier qui dépend d’un paramètre inconnu de dimension k : 2 R k : Dans l’approche classique de la statistique inférentielle, le paramètre , s’il est par nature inconnu, reste néanmoins xé dans : L’approche bayésienne considère toujours inconnu mais ce paramètre est, comme l’observation x; aléatoire (c’est-à-dire issu d’un phénomène aléatoire). Dans ce contexte, le paramètre est régi par une certaine loi de probabilité p(); dite loi a priori (supposée connue). Cette loi est subjective dans la mesure où elle représente la croyance de l’expérimentateur avant que l’expérience ne soit conduite. L’analyse bayésienne se fait en termes de lois régissant ; l’inférence sur ce paramètre inconnu se réalisant au travers de ces lois. Plus sphériquement, elle tire parti de l’observation x pour réactualiser la loi a priori p() : on construit sur la base de la loi a priori p() et des observations x; une loi p(jx) qui régit , dite loi a posteriori (car déterminée après avoir observé x). Le principe est donc de corriger l’a priori que l’on suppose sur par l’information apportée par x. Une telle modélisation n’est pas universellement acceptée, le choix de la loi a priori n’obéissant pas nécessairement à des critères objectifs. Cependant, il est des cas où l’on dispose de résultats d’expériences permettant de conjecturer que le paramètre se trouve avec une forte probabilité dans une région déterminée de l’espace des paramètres. On peut ainsi rendre compte de cette information au travers d’une loi a priori se concentrant dans cette région. A l’inverse, lorsque aucune information n’est disponible sur le paramètre ; cela peut être traduit par l’utilisation de lois a priori non informatives ou vagues (c’est-à-dire avec une variance élevée). Notons toutefois que le support de la loi a posteriori est inclue dans celui de la loi a priori. L’approche bayésienne est formalisée dans la gure 1.3. D’un point de vue pratique, les calculs nécessaires pour déterminer la distribution a posteriori sont souvent complexes voire insolubles. En e¤et, la résolution analytique de l’intégrale (1:3) de la gure 1.3 est particulièrement di¢cile lorsque la loi p() n’est pas conjuguée pour le modèle de vraisemblance p(xj), c’est-à-dire que les lois p() et p(jx) n’appartiennent pas à la même famille de lois, ou lorsque le modèle présente une structure hiérarchique (Fig. 1.4), c’est-à-dire que les lois a priori sont découpées en plusieurs niveaux, les paramètres (appelés aussi hyperparamètres) des derniers niveaux possédant également des lois de probabilité. Le découpage hiérarchique donne donc lieu à une explosion de lois marginales et de lois a posteriori, suivant le niveau par rapport auquel on conditionne.