L’impact de la dégradation du signal de parole sur le langage, de sa représentation à sa compréhension

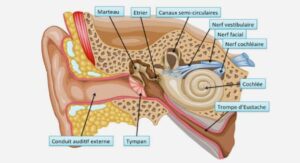

Le système auditif

Les premiers chapitres de la partie Théorique se sont intéressés au traitement de la parole, à son sens et enfin à la situation de parole dans le bruit. Pourtant, le traitement de la parole est nécessairement tributaire de l’intégrité des systèmes auditifs à la fois périphérique et central. Cette thèse vise à s’intéresser aux liens entre les processus bas niveau, ici le traitement auditif, et les processus haut niveau, ici les représentations langagières. L’Axe 1 s’intéresse aux dégradations acoustiques du signal lorsque la parole est dégradée par la présence de bruit. La dégradation est alors transitoire et n’affecte donc pas les représentations du langage. L’Axe 2 en revanche, s’intéresse aux dégradations permanentes du signal, du fait d’un traitement auditif déficitaire. Nous laissons de côté les atteintes périphériques (i.e., la surdité) pour nous intéresser aux déficits au niveau des traitements auditifs centraux (i.e., non périphériques). Ce déficit du traitement auditif peut provenir d’un manque de maturité puisque les traitements auditifs sont matures très tardivement (Etude 3). Enfin, il peut provenir d’un Trouble du Traitement Auditif (TTA), souvent associé à des troubles du langage (Etude 4). L’objectif de ce chapitre IV est de présenter les systèmes auditifs. Nous voyons tout d’abord brièvement le système auditif périphérique, la compréhension superficielle de son fonctionnement permet de mieux appréhender certains phénomènes comme le masquage énergétique (cf. p58). Puis nous nous intéressons à l’anatomie et au fonctionnement du système auditif central ainsi qu’à son développement, de la naissance à l’âge adulte. Ce chapitre présente ensuite le cas particulier des TTA, la définition de ce trouble et les outils diagnostiques disponibles pour les dépister. En dernier lieu, nous présentons la Batterie d’Evaluation des Compétences Auditives Centrales (BECAC ; Donnadieu et al., 2014) qui a été utilisée comme matériel expérimental dans les Etudes 3 et 4. Chapitre IV 68 1. Le système auditif périphérique Le système auditif périphérique est composé de trois parties, l’oreille externe, l’oreille moyenne et l’oreille interne. 1.1. L’oreille externe L’oreille externe est composée du pavillon auriculaire, ainsi que du conduit auditif externe. La forme du pavillon auriculaire permet d’amplifier les différentes fréquences avant que l’onde sonore n’entre dans le conduit auditif externe. Lorsque le son est latéralisé, la tête et le torse vont modifier l’amplitude des différentes fréquences. L’amplitude des sons de basses fréquences (de 100 Hz à 10000 Hz) est ainsi amplifiée, alors que l’amplitude des sons de hautes fréquences (plus de 10000 Hz) sera diminuée. Ce phénomène s’explique par la petite taille des structures du pavillon auriculaire, de ce fait, seules les ondes à faible période (i.e., haute fréquence) vont être altérées. En plus de ces modifications apportées par le torse, la tête et le pavillon auriculaire, l’oreille externe engendre également une amplification de l’amplitude des fréquences comprises entre 1500 Hz et 7000 Hz. Cette amplification provient majoritairement de la conque et du conduit auditif externe. En effet, du fait de sa taille, la conque a une fréquence de résonnance de 5000 Hz alors que le conduit auditif externe a une fréquence de résonnance d’environ 2500 Hz. Ces deux structures amplifient ainsi l’intensité des sons qui sont présentés à l’oreille et dont la fréquence est comprise entre 1500 Hz et 7000 Hz. Une fois l’onde sonore amplifiée sur ces différentes fréquences, elle se dirige vers l’oreille moyenne (cf. Figure 9). Le système auditif 69 Figure 9 Tiré de Graven et Browne (2008). Représentation de l’oreille humaine

L’oreille moyenne

L’oreille moyenne commence au niveau de la membrane tympanique. Celle-ci va isoler le tympan du conduit auditif externe. Elle est attachée à la chaine des osselets, composée du marteau, de l’enclume et de l’étrier eux même liés à la fenêtre ovale et donc à l’oreille interne. La principale fonction de l’oreille moyenne va être de transmettre l’onde sonore entre l’oreille externe et l’oreille interne. Pour ce faire, 3 solutions sont possibles : (a) le son peut être conduit par transmission osseuse (i.e., transmission par les os du crâne) ; (b) le son peut être conduit par l’air, c’est-à-dire que les vibrations de la membrane tympaniques font vibrer l’air contenu dans la cavité tympanique et la fenêtre ovale ; (c) le son peut être amplifié par les osselets. Les deux premières possibilités ne permettent pas l’amplification du son, or, comme le passage entre l’oreille moyenne et l’oreille interne correspond au passage d’un milieu aérien a un milieu liquide (beaucoup plus résistant), si le son n’est pas amplifié, les vibrations en milieu liquide ne sont pas assez importantes pour engendrer un percept. Pour exemple, la disparition de la chaine des osselets chez un être humain engendrerait une perte auditive de 60 dB. Le son est donc principalement transmis de l’oreille moyenne à l’oreille interne via la chaine des osselets. Lorsque la membrane tympanique vibre Chapitre IV 70 sous l’effet des changements de pression de l’air du à l’onde sonore, elle met en mouvement la chaine des osselets. Celle-ci agit comme un levier et répercute le mouvement de vibration sur la fenêtre ovale. Du fait de cet effet de levier d’un osselet sur l’autre et de la plus petite surface de la fenêtre ovale comparativement à la membrane tympanique, l’amplitude de l’onde sonore est amplifiée. L’oreille moyenne a également pour fonction de protéger l’oreille interne en cas de bruit trop intense grâce au reflexe stapédien. En effet, en cas de trop grande pression sur la membrane tympanique, un muscle reliant la caisse du tympan et l’étrier se contracte afin de limiter la pression de l’étrier sur la fenêtre ovale, l’amplification de la transmission de l’onde sonore est ainsi diminuée. 1.3. L’oreille interne L’oreille interne est inclue dans l’os temporal et est composée de 3 parties : les canaux semi-circulaires, le vestibule et la cochlée. Les canaux semi-circulaires et le vestibule, font partie du système vestibulaire responsable du maintien de l’équilibre et non de l’audition. Nous allons donc nous intéresser uniquement à la cochlée, au sein de laquelle se fait la transduction mécano-électrique. Figure 10 Schéma d’un tour de la cochlée. Adapté de http://www.cochlea.eu/cochlee. 1 Lame Réticulaire. 2. Membrane de Reissner. 3. Mur Latéral. 4. Organe de Corti. 5. Rampe Vestibulaire. 6. Rampe tympanique 7. Canal Cochléaire.

Le système auditif

Anatomie de la cochlée

La cochlée est un tube enroulé sur lui-même environ 2,6 fois dont le diamètre est décroissant de la base près de l’étrier vers l’apex (cf. Figure 9). Elle est composée de trois canaux remplis de liquide : (a) la rampe tympanique ; (b) la rampe vestibulaire ; toutes deux entourant (c) le canal cochléaire. La membrane basilaire sépare la rampe tympanique et le canal cochléaire alors que la membrane de Reissner sépare la rampe vestibulaire et le canal cochléaire (cf. Figure 10). Ce dernier est rempli d’endolymphe alors que les rampes vestibulaires et tympaniques sont remplies de périlymphe. La structure de la membrane basilaire donne lieu à une représentation tonotopique des fréquences. Les régions basales sont stimulées par les fréquences élevées alors que les régions apicales sont stimulées par les fréquences basses. L’organe de Corti présent le long de la membrane basilaire contient les cellules sensorielles (i.e., les cellules ciliées). Il en existe deux types, les cellules ciliées externes, organisées le long de la membrane basilaire en 3 à 5 rangées, et les cellules ciliées internes organisées en une seule rangée. Chaque cellule ciliée contient entre 50 et 150 stéréocils. Les stéréocils des cellules ciliées externes sont insérés dans la membrane tectoriale contrairement à ceux des cellules ciliées internes. L’organe de Corti est également composé de cellules de soutient : les cellules de Deier et les cellules de Henson.

Physiologie de la cochlée

Lorsqu’un son atteint la cochlée, la mise en mouvement de la périlymphe génère également un mouvement de la membrane basilaire. Du fait de son élargissement de la base vers l’apex, les mouvements de la périlymphe n’influencent pas la membrane basilaire de la même façon au même endroit. C’est ainsi que la fréquence du son perçu fait vibrer différemment la membrane, permettant un encodage différencié des fréquences. C’est la tonotopie passive. Les cellules ciliées externes présentes sur la membrane entrent également en mouvement. L’étirement de ces cellules du fait de leur insertion dans la membrane tectoriale engendre l’ouverture de canaux à cations. Le potassium contenu dans l’endolymphe entre ainsi dans les cellules ciliées externes et les dépolarise, créant ainsi un influx nerveux. Plus l’intensité du son perçu est importante, plus les cellules ciliées sont stimulées et ont une fréquence de décharge importante. En moyenne, les cellules adjacentes diffèrent par leur fréquence caractéristique de seulement 0.2%. L’influx nerveux ainsi créé se propage le long du nerf auditif travers le système auditif.

Le système auditif central

Le système auditif central est composé de différentes structures (cf. Figure 11) : (a) les noyaux cochléaires ; (b) les complexes olivaires supérieurs ; (c) les noyaux du lemniscus latéral ; (d) les colliculus inférieur ; (e) les corps génuticulés médiaux et (f) Chapitre IV 72 les aires auditives. A noter que toutes ces structures présentent une organisation tonotopique. De même que pour la cochlée, au sein de chaque structure il existe une correspondance entre la localisation topographique d’un neurone et sa fréquence de prédilection. Les voies auditives ascendantes se projettent de façon bilatérale, bien qu’elles se projettent de façon prédominante vers l’hémisphère contralatéral (70-80%). A chaque étape, des commissures permettent ces projections vers le côté contralatéral, et la liaison de chaque structure avec son homologue droite ou gauche.

Le noyau cochléaire

Les neurones auditifs primaires provenant de la cochlée, se divisent en deux branches se projetant ipsilatéralement sur le noyau cochléaire (cf. Figure 11). La branche antérieure se termine alors dans le noyau cochléaire ventral antérieur (NCVa) alors que la branche postérieure se termine dans le noyau cochléaire ventral postérieur (NCVp) et le noyau cochléaire dorsal (NCD). C’est au niveau des noyaux cochléaires que s’effectue un premier décodage des caractéristiques de l’information sonore, en intensité, durée et fréquence.

Le complexe olivaire supérieur

Les neurones en provenance des noyaux cochléaires se projettent de façon bilatérale sur le complexe olivaire supérieur. L’information pour chacune de ces structures provient donc des deux oreilles. C’est à ce niveau que sont traités les différents indices permettant la localisation spatiale du son perçu. En effet, la réception des signaux provenant de chaque oreille permet de traiter les différences interaurales de temps (ITD ; Interaural Time Difference) et d’intensité (ILD ; Interaural Level Difference). Les ITD et ILD correspondent en fait aux différences de temps et d’intensité que présente le signal entre les deux oreilles lorsqu’il n’est pas présenté face à la tête. En effet, un son présenté à droite mettra moins de temps à atteindre l’oreille droite que la gauche, il perd également de son intensité entre les deux oreilles du fait de la présence de la tête. Pour que les ITD puissent être traitées, il faut que le mécanisme de phase locking soit mis en œuvre. C’est-à-dire que la fréquence du son soit encodée par la fréquence de décharge des neurones. Les ITD ne sont donc utilisées que lorsque la fréquence du son est suffisamment basse (i.e., 3 kHz), elles sont traitées au sein de l’olive supérieure moyenne. Au-delà, c’est plutôt les ILD qui sont utilisées pour la latéralisation des sons, elles sont traitées au sein de l’olive supérieure latérale. De plus, les ILD sont très sensibles à la fréquence du son, les sons de haute fréquence produisent de plus grandes ILD que les sons de basse fréquence. Le système auditif

Le lemnicus latéral

Une partie des fibres nerveuses en provenance du noyau cochléaire se projette directement sur le lemnicus latéral contralatéral, sans passer par le complexe olivaire supérieur. Ce chemin particulier répond uniquement aux sons présentés monoralement. Cette structure encode le début et la durée de ce son, sans en encoder la fréquence. Toutefois le rôle précis de cette structure au sein des structures auditives centrales reste peu connu. 2.4. Le colliculus inférieur Le colliculus inférieur reçoit des projections non seulement du lemnicus latéral, mais également du complexe olivaire supérieur et directement aussi du noyau cochléaire. Il a pour spécificité le traitement des informations temporelles complexes. Certains neurones du colliculus inférieur répondent uniquement aux sons présentant des modulations de fréquence ou encore à des sons d’une durée particulière.

Le corps genouillé médian du thalamus

Le dernier relai avant le cortex auditif primaire est le corps genouillé médian du thalamus, il reçoit ses projections du colliculus inférieur. Les informations spectrales et temporelles traitées au préalable y sont combinées. Ce relai est également considéré comme une zone de convergence multisensorielle.

Table des matières |