Télécharger le fichier original (Mémoire de fin d’études)

Concepts de base de la RI

Selon [salton, 1971b] la recherche d’information est l’ensemble des techniques permettant de sélectionner à partir d’une collection de documents, ceux qui sont susceptibles de répondre au besoin de l’utilisateur exprimé via une requête. A travers cette définition, nous retenons 3 concepts clés : le document, le besoin et la pertinence.

Document

Le document est constitué par un texte, un morceau de texte, une image, une bande de vidéo etc., qui peut être retourné en réponse à une requête/ besoin en informatique d’un utilisateur. L’ensemble des documents sur lequel porte une recherche forme la collection de documents.

Besoin en info et requête

Le besoin en information d’un utilisateur peut avoir différents types : besoin vérificatif où l’utilisateur cherche une donnée particulière et sait souvent comment y accéder (exemple l’utilisateur cherche un document avec une adresse web), besoin thématique connu où l’utilisateur cherche à trouver une nouvelle information concernant un sujet ou un domaine connu, enfin un besoin thématique inconnu, l’utilisateur dans ce cas cherche de nouveaux concepts ou de nouvelles relations hors des sujets ou domaines qui lui sont familiers.

La requête formule le besoin de l’utilisateur sous forme d’un ensemble de mots exprimé en langage naturel, booléen ou graphique. La requête est soumise à un moteur de recherche pour une recherche documentaire donnée.

Pertinence

La notion de pertinence est un critère principal pour l’évaluation des systèmes de recherche d’information. De nombreuses définitions possibles, selon [Saracevic, 1970] la pertinence peut être vue comme une mesure de l’informativité du document à la requête, un degré de relation (chevauchement, etc.) entre le document et la requête ou un degré de surprise qu’apporte un document vis-à-vis du besoin de l’utilisateur etc.

La pertinence est subjective, c’est-à-dire elle dépend de l’utilisateur. Les études menées autour de la notion de pertinence [Barry, 1994] [Borlund, 2003] montrent qu’elle est définie par un ensemble de critères et des préférences qui varient selon les utilisateurs (le contenu informationnel des documents, le niveau d’expertise et de connaissances de l’utilisateur, des informations liées à l’environnement, les sources des documents, etc.). Ces critères sont des facteurs qui déterminent la pertinence accordée à l’information retrouvée par l’utilisateur dans un contexte de recherche précis.

Système de recherche d’information (SRI)

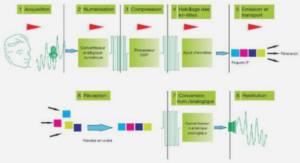

Comme illustré dans la Figure 1, un SRI intègre deux fonctions principales, représentées schématiquement par le processus U de recherche d’information [Belkin et al, 1992] : indexation document (resp. requête) et appariement document-requête. Plus précisément

• Processus d’indexation : consiste à extraire le descripteur à partir de la requête ou des documents. Le descripteur est une liste des termes significatifs qui doit couvrir au mieux le contenu sémantique d’un document ou d’une requête. L’ensemble des termes reconnus par le SRI est rangé dans une structure appelée dictionnaire constituant le langage d’indexation.

• Processus de recherche : il permet de sélectionner l’ensemble des documents potentiellement pertinents pour une requête. Le cœur de ce processus est une fonction de correspondance entre la requête et les documents par exploitation de l’index, ensuite présentation des résultats. Cette fonction de correspondance calcule un score de pertinence RSV(Q,D) (Retrieval Status Value) entre la requête indexée Q et les descripteurs du document D. Différents modèles de RI ont été proposés pour mesurer ces scores. Ces modèles sont au centre des travaux de recherche dans le domaine de la RI, ils seront détaillés dans la section 1.4. Les documents retournés généralement sont triés par ordre de leurs pertinences, du plus pertinent au moins pertinent (c.à.d. par ordre de valeur de correspondance décroissante)

Indexation

La tâche principale d’un processus d’indexation est de transformer les documents (ou requêtes) en substituts ou descripteurs capables de représenter leurs contenus [Salton, 1971b][Sparck Jones, 1979][Van Rijsbergen, 1979]. Dans une indexation classique, les descripteurs d’un document peuvent être des termes simples ou des termes composés. Dans des systèmes qui prennent en compte le sens des termes et les différents types de relations sémantiques dans un document, ces descripteurs seront des mots-clés (concepts) associés à des entrées dans un vocabulaire contrôlé, thésaurus [Salton et al, 1968] [Sparck Jones, 1986], ontologie (exemple PenMan, Cyc [Sowa, 1984] et WordNet [Miller, 1995], hiérarchie de concepts, etc.). Les descripteurs sont ensuite stockés dans une structure particulière appelée fichier inverse. Dans ce fichier, nous trouvons pour chacun de ces termes, la liste des références de chaque document le contenant. Par référence on entend identifiant, c’est-à-dire un moyen de retrouver de façon non ambigüe des documents ou un document ou une partie de document où le terme apparaît.

Pour améliorer l’indexation plusieurs approches d’amélioration de la représentation d’un document ont été proposées, citons :

Stoplists : Dans le but de représenter le document par les termes qui représentent mieux son contenu, des approches à base fréquentielle ont été employées comme nous les détaillerons dans la section suivante. Reste toujours certains mots qui sont fréquents dans le document mais ils ne lui donnent pas une valeur discriminante. Ces mots sont souvent des prépositions (e.g. « de », « à »), prénom (« aucun », « tout », « on »), certains adverbes (« ailleurs », « maintenant »), adjectifs (« certain », « possible »), etc. Afin d’éliminer ces mots et améliorer la représentation on utilise une liste appelée stoplist (ou liste des mots vides).

Certains mots inclus dans cette liste ne sont pas nécessairement vides de sens (ça dépend du domaine). Ils ne sont pas vides de sens en linguistiques, mais leur sens importe très peu pour des besoins de RI.

Le traitement lié à une stoplist est très simple. Quand on rencontre un mot dans un texte, on doit d’abord examiner s’il apparaît dans cette liste. Si oui, on ne le considère pas comme un mot à insérer dans l’index.

Lemmatisation : Les mots (lemmes) d’une langue utilisent plusieurs formes en fonction de leur genre (masculin ou féminin), leur nombre (un ou plusieurs), leur personne (moi, toi, eux, …), leur mode (indicatif, impératif, …) donnant ainsi naissance à plusieurs formes pour un même lemme. La lemmatisation désigne l’analyse lexicale du contenu d’un texte regroupant les mots d’une même famille. Chacun des mots d’un contenu se trouve ainsi réduit en une entité appelée lemme (forme canonique). La lemmatisation regroupe les différentes formes que peut revêtir un mot, soit : le nom, le pluriel, le verbe à l’infinitif, etc.

Plusieurs approches de lemmatisation ont été proposées : Porter [Porter, 1980] a créé un algorithme qui élimine les terminaisons des mots en anglais en 5 grandes étapes: la première étape tente de transformer le pluriel en singulier. Les étapes subséquentes essayent d’éliminer au fur et à mesure les dérivations. Cet algorithme transforme parfois deux mots différents en une même forme. Par exemple, derivate/derive, activate/active. Cependant, pour la plupart, la transformation semble raisonnable. Maintenant, la plupart de procédures de lemmatisation l’utilise, ou utilise une de ces variantes.

Autre algorithme de lemmatisation utilise un dictionnaire pour savoir si une séquence de lettre à la fin correspond à une terminaison [Savoy, 1993], il suffit de faire une élimination ou une transformation tentative, et de voir si la forme obtenue existe dans le dictionnaire.

D’autre modèle de lemmatisation, utilise un taggeur (ou un analyseur de catégorie) automatique. Dans ces approches, afin de déterminer la catégorie d’un mot on utilise un modèle probabiliste. Ce modèle détermine la probabilité qu’un mot soit présent dans une catégorie selon sa forme, et selon les mots qui l’entourent.

Le processus d’indexation dépend de plusieurs facteurs, en particulier la manière d’indexer : automatique ou manuelle, et la source utilisée pour représenter les descripteurs (vocabulaire contrôlé ou libre extrait directement du texte du document).

En RI, ils existent trois modes d’indexation: l’indexation manuelle, automatique ou semi-automatique.

− Indexation manuelle : les descripteurs d’un document sont choisis par un expert de domaine qu’il juge pertinents pour la description du contenu sémantique du document. Ce type d’indexation permet d’avoir un vocabulaire d’index contrôlé, ce qui permet d’accroître la consistance et la qualité de la représentation obtenue [Nie et al, 1999], par conséquent les documents retournés par un SRI en réponse à une requête utilisateur sont précis [ren et al, 1999]. Mais l’augmentation du nombre de documents à indexer rend la tâche d’indexation manuelle difficile et coûteuse en temps. De plus cette indexation dépend des connaissances des spécialistes qui peuvent être limitées à cause de l’évolution de la langue (apparition de nouveaux mots).

− Indexation automatique : La première approche à l’indexation automatique KWIC ou Keyword in Context, fut introduite à International Conference on Scientific Information (ICSI) en 1958 par Luhn. Dans ce type d’indexation les descripteurs sont automatiquement extraits à partir du texte du document. La fréquence d’occurrence de mots a été utilisée comme le critère de sélection d’index. Les mots vides de sens (ceux de stoplistes) sont systématiquement éliminés.

− Indexation semi-automatique ou encore notée indexation supervisée : consiste à tirer profit des 2 types d’indexation manuelle et automatique, certains travaux [Jacquemin et al, 2002] proposent d’exposer les résultats de l’indexation automatique à un spécialiste de domaine. Le spécialiste utilise un vocabulaire contrôlé sous forme de thésaurus ou de base terminologique qui couvre le langage d’indexation.

Pondération de termes

La pondération est l’opération qui consiste à affecter un poids aux termes d’indexation et de recherche. Ce poids permet de préciser l’importance relative des mots représentés dans les documents par rapport à ceux identifiés dans la question, selon une échelle déterminée.

Différents facteurs basés sur l’occurrence statistique ont été utilisés pour la pondération des termes d’un document :

La fréquence tf (ou Term Frequency en anglais): tf quantifie la représentativité locale d’un terme dans le document. Cette valeur est fonction de la fréquence d’occurrence du terme dans le document. Cependant on s’aperçoit que les mots les plus fréquents sont des mots fonctionnels (ou mots vides). En français, les mots « de », « un », « les », etc. sont les plus fréquents, en anglais, ce sont « of », « the », etc. L’intérêt et la spécificité de la fréquence des mots ont été étudiés à la fin des années 48 par Zipf [Zipf, 1949]. Selon Zipf, les mots dans les documents ne s’organisent pas de manière aléatoire mais suivent une loi inversement proportionnelle à leur rang. Le rang d’un mot est sa position dans la liste décroissante des fréquences des mots du corpus. Formellement, cette loi s’exprime de la manière suivante : é × ≃

Selon cette loi, la distribution des mots suit la courbe suivante (Figure 2): Figure 2: Courbe de distribution de mots selon la loi de Zipf

La fréquence de termes semble donc être un bon indicateur pour mesurer l’importance d’un terme. A ce titre, Luhn [Luhn, 1957] définit l’informativité d’un terme en se basant sur la loi de Zipf. L’informativité mesure la quantité de sens qu’un mot porte. Cette notion n’est pas définie très précisément en RI. Elle est utilisée seulement de façon intuitive. Cependant, on peut trouver son équivalent dans la théorie de l’information (par exemple, la théorie de Shannon qui est une théorie probabiliste permettant de quantifier le contenu moyen en information d’un ensemble de messages, dont le codage informatique satisfait une distribution statistique précise [Shannon, 1948]).

La correspondance entre l’informativité et la fréquence est illustrée sur la Figure 3. Ainsi, les mots ayant des fréquences entre les deux seuils Min et Max sont les mots qui ont l’informativité la plus élevée.

Les fonctions de calcul de tf:

− tf = 1 ou 0, dans le cas d’une fonction binaire qui rend 1 si le terme apparaît dans le document une ou plusieurs fois, et rend 0 si le terme n’apparait pas.

− tf = f(t,d), où f(t,d) est une fonction brute de calcul de la fréquence qui compte le nombre d’occurrence du terme t dans un document d.

− tf = α + log(f(t,d) + β), dans le cas d’une fonction logarithmique, où α et β sont des constantes. Cette fonction a pour but d’atténuer les effets de larges différences entre les fréquences d’occurrence des termes dans le document.

− tf = f(t,d)/Max[f(t,d)], dans le cas d’une fonction normalisée, où Max[f(t,d)] est la fréquence maximale des termes dans d; Cette fonction permet de réduire les différences entre les valeurs associées aux termes du document.

− tf = [f(t,d) * (K1 +1)]/ [k1 * ((1-b) + b * dl/avdl)], Robertson [Robertson, 1994a] [Robertson, 1994b] dans son modèle BM25 utilise une normalisation de la fréquence d’un terme t dans un document d en fonction du longueur de d noté par dl et la moyenne de longueur des documents dans la collection traitée avdl, où K1 et b sont des constantes.

La fréquence inverse idf (ou Inverse Term Frequency en anglais) : idf, quantifie la représentativité globale du terme dans une collection de documents. Cette valeur mesure si le terme est discriminant, les termes qui sont utilisés dans de nombreux documents sont moins discriminants que ceux qui apparaissent dans peu de documents. Un poids plus important est donc assigné aux termes qui apparaissent moins fréquemment dans la collection.

Citons par exemple une fonction de calcul d’idf : idf = log(N/n) ou log((N-n)/N), où N désigne le nombre totale de documents dans la collection et n désigne df(t,C) (le nombre de document de la collection C contenant le terme t)

La pondération basée sur tf*idf : d’une manière générale, la majorité des méthodes de pondération [Robertson et al, 1997] [Singhal et al, 1997] [Sparck Jone, 1979] est construite par la combinaison de deux facteurs, tf « Term Frequency » et idf « Inverse of Document Frequency ». La formule tf*idf assigne à un term t un poids dans un document d qui est : 1) le plus grand lorsque t apparait dans un petit nombre de document. 2) petit lorsque le terme a une petite occurrence dans le document. 3) le plus petit lorsque le terme apparait virtuellement dans tous les documents de la collection.

La formule finale de tf*idf est donc la multiplication de tf par idf. Par exemple : Tf*idf = [ f(t,d)/Max[f(t,d)]] * log(N/n)

Appariement Requête-document

Cette étape permet de comparer la représentation d’un document à celle de la requête. Ceci revient souvent à mesurer un score de correspondance (de pertinence) entre ces représentations souvent appelé RSV (Retrieval Status Value). Ce score prend en considération les descripteurs, ainsi que, leurs pondérations dans la représentation de la requête et la représentation du document.

Plus précisément, l’appariement requête-document dépend du modèle de RI utilisé. Un modèle de RI définit la manière dont la requête et les documents sont représentés, ainsi que, le modèle formel qui permet d’interpréter cette notion de pertinence. Plusieurs modèles ont été proposés dans le domaine comme les modèles vectoriels, probabilistes, connexionnistes, inférentiels, qui seront détaillés par la section 1.4.

Les modèles de RI

Le rôle d’un modèle est fondamental dans un SRI. Il permet d’interpréter la notion de pertinence d’un document vis-à-vis une requête dans un cadre formel. Il fournit donc un cadre théorique pour la modélisation de cette mesure de pertinence. Plusieurs modèles, s’appuyant sur des cadres théoriques allant des ensembles aux probabilités en passant par l’algèbre ont été définis.

Le modèle booléen était le premier à être employé dans la RI, à cause de sa simplicité. Cependant, le manque de pondération dans ce modèle limite ses utilisations. Ainsi, des versions étendues de ce modèle ont été proposées, elles intègrent la pondération, exemple l’utilisation de la théorie des ensembles flous [Kraft et al, 1983]. Le modèle vectoriel est sans doute le modèle le plus souvent utilisé en RI. Sa popularité est due à sa capacité d’ordonner les documents retrouvés et à ses bonnes performances dans les tests.

Depuis le milieu des années 1970, C.J. van Rijsbergen [Van Rijsbergen, 1977], S. Robertson et K. Sparck Jones [Robertson et al, 1976] étaient parmi les premiers à proposer les modèles probabilistes. La performance de ces modèles apparaît dans les années 1990. Ensuite, les modèles de langue [Ponte et Croft, 1998] ont eu de succès en raison de leur simplicité théorsique.

Nous présentons dans la suite le principe de ces modèles : modèle booléen, modèle vectoriel et modèle probabiliste.

Modèle booléen

La stratégie de recherche booléenne était employée dans les premiers systèmes de gestion de bibliothèques. Il est basé sur la théorie des ensembles [Salton, 1971b]. Dans ce modèle chaque document d est représenté comme une conjonction logique de termes (non pondérés) qui le composent, par exemple : = {t1 , t2 , . . . , tn}

Une requête de l’utilisateur est formulée à l’aide d’une expression booléenne. La requête booléenne est représentée par peu des termes reliés par des opérateurs booléens : = (t1 ˄ t2 ) ˅ (t3 ˄ ¬t4)

La correspondance RSV(D,Qk), entre une requête Qk(qk1, qk2,…,qkn) composée des termes qki avec i ∈ [1, n] et une listes documents représentés par D est déterminée comme suit :

RSV(D,qki)= R(qki ) où R (qki) est l’ensemble de documents retrouvé par qki

RSV(Dj,qki ˄ qkj)=R(qki) ∩ R(qkj)

RSV(Dj,qki ˅ qkj)= R(qki) ∪ R(qkj)

L’intérêt du modèle booléen est qu’il permet de faire une recherche très restrictive et obtenir, pour un utilisateur expérimenté, une information exacte et spécifique.

Les inconvénients de ce modèle sont les suivants :

− Les réponses à une requête ne sont pas ordonnées puisque la correspondance entre un document et une requête est soit 1, soit 0. Il n’est pas possible de dire quel document est mieux qu’un autre. Le problème devient plus difficile si les documents qui répondent aux critères de la requête sont nombreux.

− L’expression d’une requête nécessite une connaissance des opérateurs booléens, ceci n’est pas une tâche simple pour tous les usagers.

Avec tous ces inconvénients, le modèle booléen standard reste toujours utilisé. Des extensions ont été proposées pour tenir compte de l’importance des termes dans les documents. On y trouve par exemple le modèle booléen étendu [Salton et al, 1983] ou encore un modèle basé sur les ensembles flous [Zadeh, 1965].

Extension du modèle booléen

Différentes extensions ont été proposées pour remédier aux problèmes du modèle booléen standard. Dans ces extensions, chaque terme du document et de la requête est affecté par un poids. Citons :

Le modèle booléen étendu [Salton et al, 1983] : dans ce modèle, la représentation de la requête reste une expression booléenne classique. Tandis que, les termes représentant d’un document sont pondérés. L’appariement requête-document est le plus souvent déterminé par les relations introduites dans le modèle p-norme basées sur les p-distances. Où p est un facteur ajouté sur les opérateurs logiques ˅ et ˄ . La valeur de p varie dans l’intervalle [1, ∞ [. Plus p est grand, plus l’évaluation est stricte. Quand p=1, on retrouve une évaluation équivalente à celle du modèle vectoriel; Quand p→∞, l’évaluation est équivalente à celle du modèle booléen standard ou basée sur des ensembles flous.

Extension du modèle booléen basé sur les ensembles flou [Zadeh, 1965] : dans ce modèle, inspiré des ensembles flou, chaque terme a un degré d’appartenance à un document. Ce degré correspond au poids du terme dans le document. Dans ce modèle, la requête est toujours représentée par une expression booléenne classique, tandis que, l’évaluation des opérateurs logiques ˅ et ˄ et remplacer par les fonctions min et max.

Ces évaluations ont été proposées à la fin des années 1970 et au début des années 1980. Maintenant, ces extensions sont devenues standard: la plupart des systèmes booléens utilisent un de ces modèles étendus.

Modèle vectoriel

Dans le modèle vectoriel [Salton, 1971a], les documents ainsi que la requête sont représentés par des vecteurs dans un espace de n dimensions, constitué par les termes du vocabulaire d’indexation. Dans ce modèle, une pondération est attribuée à chaque terme de l’espace d’indexation. Ainsi, supposons E = {t1, …, tn} constitue l’espace d’indexation, où les ti sont les descripteurs. L’index d’un document dj est représenté par le vecteur de poids des termes : Où est le poids du terme tj dans le document dj. Notez qu’un terme tk de l’espace d’indexation qui n’est pas présent dans le document, son poids sera nul ( = 0). Le poids d’un terme est calculé en utilisant les méthodes de pondération citées dans la section 1.3.2 Pondération de termes.

Le mécanisme de recherche consiste à retrouver les vecteurs documents qui sont les plus proches du vecteur requête. Il existe plusieurs fonctions permettant de mesurer la similarité entre deux vecteurs. Par exemple la fonction de cosinus [Salton, 1971b] .

Le modèle vectoriel est l’un des modèles de RI classique les plus étudiés et les mieux utilisés. A l’inverse du modèle booléen qui ne permet pas de distinguer entre deux documents qui sont indexés par les mêmes termes. La fonction de pondération permet de présenter à l’utilisateur une liste des documents triés selon leur ordre de pertinence.

Plusieurs extensions ont été proposées. On peut distinguer en particulier celle basée sur une analyse sémantique latente, modèle LSI (Latent semantic Indexing) [Deerwester et al, 1990] ou encore le modèle vectoriel généralisé proposé par Wong [Wong et al, 1985] qui contrairement aux modèles classique, ne considère pas l’hypothèse d’indépendance des termes d’indexation, il permet de tenir compte des dépendances qui peuvent exister entre les termes. Le modèle LSI, quant à lui, permet de corriger les défauts du modèle vectoriel liés à la non-prise en compte des variations linguistiques (principalement synonymie) des mots. Ce modèle utilise les techniques de l’analyse en composante principale sur l’espace des mots afin de, le ramener à un espace de concepts. Pour ce faire, LSI exploite les corrélations (co-occurrences) entre les mots afin de regrouper ceux qui sont susceptibles de représenter un même concept dans une même classe. On obtient ainsi, une représentation conceptuelle des documents, ce qui limite l’impact de la variation dans l’utilisation des mots dans les documents.

Table des matières

Introduction Générale

PARTIE I : ETAT DE L’ART

Chapitre 1 : Recherche d’information, modèles et concepts de base

1.1 Introduction

1.2 Concepts de base de la RI

1.3 Système de recherche d’information (SRI)

1.3.1 Indexation

1.3.2 Pondération de termes

1.3.3 Appariement Requête-document

1.4 Les modèles de RI

1.4.1 Modèle booléen

1.4.2 Extension du modèle booléen

1.4.3 Modèle vectoriel

1.4.4 Les modèles probabilistes

1.4.4.1 Binary Independent Model

1.4.4.2 Modèle BM25

1.4.4.3 Modèle statistique de langue

1.5 Fonctionnalité additive à un SRI

1.6 Evaluation des SRI

1.6.1 Protocole d’évaluation

1.6.2 Les mesures d’évaluations

1.6.2.1 Les mesures de rappel précision

1.6.2.2 La courbe précision-rappel

1.6.3 La R-précision et la MAP (Mean Average Precision)

1.6.4 Présentation des campagnes d’évaluation des systèmes de recherche d’informations

1.6.4.1 La campagne d’évaluation TREC

1.6.4.2 Autres campagnes d’évaluations

1.6.4.3 Limites des campagnes d’évaluation des systèmes de recherches d’informations

1.6.5 Les outils d’évaluations

1.7 Conclusion

Chapitre 2 Représentation des textes

2.1 Introduction

2.2 Différentes formes qui peuvent avoir un descripteur

2.2.1 Unité représentative d’un descripteur

2.2.2 Approches statistiques

2.2.3 Approche syntaxique

2.2.4 Approches hybrides ou mixtes

2.2.5 Approches sémantiques

2.2.6 Approches conceptuelles

2.2.6.1 Méthode de désambiguïsation proposée par Baziz

2.3 WordNet, ressources externes pour l’extraction des descripteurs

2.3.1 Synset WordNet

2.3.2 Relations WordNet

2.3.3 Limites de WordNet

2.3.4 WordNet pour d’autres langues que le français

2.4 Modèle de représentation de l’information

2.4.1 Représentation par clusters

2.4.1.1 Représentation par cohésion lexical calculée par des relations extraites d’un thésaurus

2.4.2 Représentation sous forme de réseaux sémantiques

2.4.3 Représentation sous forme de graphes conceptuels

2.4.4 Autres modèles de représentations des connaissances

2.5 Résumé d’un texte ou d’un document

2.5.1 Les approches classiques

2.5.2 Les approches par apprentissage

2.5.3 Les approches basées sur le centroïde

2.5.4 Les approches exploitant la structure rhétorique

2.5.5 Les approches basées sur les graphes

2.6 Conclusion

PARTIE II : CONTRIBUTION

Chapitre 3 Extraction de termes significatifs d’un document

3.1 Introduction

3.2 Extraction de termes significatifs d’un texte

3.2.1 Extraction des concepts

3.2.2 Grouper les termes reliés

3.2.3 Facteurs pour caractériser les clusters et leurs concepts

3.2.3.1 Centralité d’un concept-terme

3.2.3.2 Fréquence d’un concept-terme

3.2.3.3 Fréquence conceptuelle

3.2.3.4 Spécificité

3.2.3.5 Taille du cluster

3.2.3.6 Poids du cluster

3.3 Conclusion

Chapitre 4 Vue sémantique d’un texte

4.1 Introduction

4.2 Les ensembles flous

4.3 Extraction d’une vue sémantique d’un texte

4.3.1 Sélection progressive des termes

4.3.2 Selection des mots à partir des clusters

4.3.3 Algorithme général

4.4 Expérimentation et résultats

4.4.1 Evaluation de l’extraction des termes significatifs

4.4.1.1 Collection de documents

4.4.1.2 Jugement de pertinence

4.4.1.3 Déroulement des expérimentations :

4.4.1.4 Analyse des résultats et discussion

4.4.2 Extraction de phrases significatives

4.4.2.1 Collection de documents

4.4.2.2 Jugement de la pertinence

4.4.2.3 Déroulement de l’experimentation

4.4.2.4 Analyse des résultats et discussion

4.5 Conclusion

Chapitre 5 Nouveaux facteurs pour la Recherche d’Information

5.1 Introduction

5.2 Désambiguïsation basée sur la centralité

5.3 La fonction c×f×s basé sur c, f et S pour la RI

5.4 Expérimentations et résultats

5.4.1 Collections de test TREC

5.4.2 Protocole d’évaluation

5.4.2.1 Baseline

5.4.2.2 Mesures d’évaluations

5.4.3 Les étapes d’expérimentations

5.4.4 Configurations utilisées

5.5 Meilleures valeurs de α, β et γ de notre fonction d’appariement

5.6 Optimiser les paramètres de « combinaison-paramètre(x,y,z) »

5.6.1 Evaluation des techniques de désambiguïsation des concepts requête et document

5.6.2 Prise en compte des multi-termes vs terme simple

5.6.3 Evaluation de notre modèle d’appariement avec deux approches

5.6.3.1 Comparaison de notre modèle d’appariement à BM25

5.6.3.2 Comparaison de notre approche à celle de Baziz [Baziz, 2005]

5.7 Influence de la centralité et de la spécificité sur la pertinence

5.8 Impact des relations sur la centralité et la fréquence conceptuelle

5.8.1 Impact des relations WordNet pour représenter la centralité

5.8.2 Impact des relations WordNet pour représenter la fréquence conceptuelle

5.9 L’efficacité de la centralité et de la fréquence conceptuelle en RI

5.10 Conclusion

Conclusion Générale

REFERENCES BIBLIOGRAPHIQUES

Bibliographie

PARTIE III : Annexes